DataStax спонсировал этот пост.

Как кто -то, кто участвовал в пространстве стандартов API в течение длительного времени, меня всегда интересовали, как программное обеспечение общается с программным обеспечением. Одной из самых захватывающих вещей для меня в области ИИ была возможность автоматизировать его ключевые аспекты, например, позволить себе создавать мощных программных агентов, которые разговаривают с миром API вокруг нас.

Теперь модельный протокол контекста (MCP) стал как AI-местный стандарт для продолжения пути, который начался по предыдущим стандартам, таким как Rest, SOAP и XML-RPC. MCP, представленная в конце прошлого года, является открытым стандартом, который упрощает соединение данных и инструментов с крупными языковыми моделями (LLMS), что устраняет трудоемкую необходимость для создания конкретных интеграций, разъемов или подсказок для каждой базы данных, инструмента или облачной службы.

Поскольку агентские системы становятся все более сложными, а разработчики делают больше возможностей для предприятия, доступных в качестве инструментов, наличие четких и согласованных правил имеет решающее значение для роста и успеха автономных рабочих процессов. Это позволяет агентам ИИ принимать решения о том, какие инструменты использовать в правильном порядке для выполнения задачи.

Это очень похоже на то, как REST помог обеспечить эффективный обмен данными, гибкость и масштабируемость для API; MCP демонстрирует много сходства с тем, что произошло в мире API, и некоторые важные различия.

Ваше окно чата как точка взаимодействия

В мире API мы думали об API как об общем назначении, свободно связанных услугах, которые могут быть использованы повторно для широкого спектра использования, либо API «опыта», которые были разработаны для обеспечения конкретной функции, необходимой для поддержки конкретной схемы UX. Netflix часто был нашим примером для API опыта-он придумал термин-но почти любое мобильное приложение, которое вы используете, в значительной степени зависит от API-интерфейсов опыта.

Теперь у нас есть новая точка взаимодействия: ваше окно Catgpt или ваш рабочий стол Claude.

Вот пример. Я хочу отредактировать электронную таблицу Excel или лист Google. У каждого есть сервер MCP, который выражает возможности таким образом, что приложение понимает. Например, Excel MCP может буквально указать что -то вроде: «Я предоставляю внутреннее состояние в форме электронной таблицы, которая представляет собой матрицу строк и столбцов, которые рассматриваются буквами и числами, соответственно. Каждый имеет численную формулу, и я предоставляю набор инструментов (или функций), которые вы можете использовать для модификации этой таблицы».

Как построен такой опыт? Это не посредством специального опыта API мобильного возраста, но также не достигается путем возвращения к когнитивному бремени веб-сервисов или даже эпох микросервисов. Это требует чего-то нового: ориентированного на возможности подхода, который разоблачает инструменты и семантический контекст, чтобы помочь LLMS понять, как использовать эти инструменты для удовлетворения запроса пользователя. MCP предназначен для того, чтобы вступить в этот разрыв.

Разработчик может практически создать этот сервер MCP, копируя и вставая на эту информацию из руководства пользователя Excel.

MCP позволяет вам задать агенту вопрос («Сделайте мне электронную таблицу того, сколько я могу потратить на продукты в течение следующего года»), а за кулисами агент имеет серверы MCP, чтобы раскрыть эти возможности. Поскольку агент может рассуждать — он может разбить проблемы на задачи и выполнять их итеративно — он может использовать MCP для обеспечения дополнительного контекста с помощью других инструментов и API, и генерировать весьма актуальный, полезный ответ.

Полученное поколение-а затем некоторые

Таким образом, контекст — это ваша подсказка плюс контекст, который получил ваш агент. Звучит знакомо? Это потому, что во многих отношениях MCP-это эволюция поколения, задуманного (RAG). Но это делает еще один шаг дальше, предоставив агенту структурированный способ того, как API, услуги, инструменты или возможности описаны, поэтому он знает, как их использовать.

Проще говоря, Rag подает внешнюю информацию в модель во время вывода. MCP предоставляет четко определенное контракт, на который доступны инструменты и возможности, и, что более важно, богатое семантическое описание того, как их можно использовать.

Это делает клиентов в чате, которые иногда высмеивают как простые и элементарные формы ИИ — «просто чат -боты» — чрезвычайно мощные.

Создание моделей умным о услугах

Идея дать возможность LLMS использовать инструменты, возникшие в React Paper в конце 2022 года и широко обсуждались в 2023 году. Meta выпустила свой исследовательский документ Toolformer в феврале 2023 года, и Openai последовала за предварительным выпуском функционального вызова и поддержки схемы JSON в марте, проложив подпрессы, введенные такими рамками, как Langchain.

В то же время была выполнена работа, чтобы попытаться модулировать и упаковать использование инструментов. Плагины Openai Chatgpt были хорошим примером этого. Также представлены в марте 2023 года и основанный на спецификации OpenAPI, эти плагины помогли CHATGPT получить доступ к актуальной информации, запустить вычисления или использовать сторонние службы. Модель плагина была также принята Microsoft, и DataStax гордился тем, что является партнером по дизайну модели плагина GitHub Copilot; Мы доставили расширение Astra DB для GitHub Copilot во вселенной Github в 2023 году.

К сожалению, LLM в то время еще не стали моделями рассуждений, и поэтому полезность этих плагинов была ограничена. С этими моделями были возможны агентские варианты использования, но на практике они были несколько неуклюжими.

Выпуск модели Claud Sonnet 3.5 от Anpropic в июне 2024 года заключался в том, что мы действительно видели, как в этой области все стало серьезным, что позволяет таким компаниям, как Cursor и другие, использовать эти возможности в пространстве разработчиков, а антроп-все больше продвигать общие сценарии использования в общем назначении для своих моделей, что приводит к введению MCP как стандартный способ упакования и интегрирования в AI-клиентов. Это означало, что разработчики могли создавать серверы MCP, которые обеспечивали интеграцию их приложений и услуг для легко использования своих приложений и услуг.

Вы можете ошибаться MCP

С API мы узнали, что дизайн API имеет значение. Великие API, как и из Stripe или Twilio, были разработаны для разработчика. С MCP дизайн тоже имеет значение. Но для кого мы создаем?

Вы не автозаправляете для человека; Вы создаете модель, которая будет обращать пристальное внимание на каждое слово, которое вы пишете. И это не просто дизайн, это операционализация MCP, которая также важна, и еще один момент параллелизма с миром API. Как мы раньше говорили в Apigee, есть хорошие API и плохие API. Если ваши бэкэнд-описания ориентированы на домен, в отличие от бизнеса или ориентировочного ориентира-интеграция, принятие и общая способность разработчиков использовать ваши API, будет нарушена. Аналогичная проблема может возникнуть с MCP. ИИ может не распознавать или использовать инструменты сервера MCP, если его описание неясно, ориентировано на действия или удобно для искусственного интеллекта.

Последняя вещь, которую следует отметить, что во многих отношениях очень новое в мире ИИ, — это тот факт, что каждое действие «на метре». В мире LLM все превращается в токены, а токены — это доллары, так как генеральный директор Nvidia Дженсен Хуанг напомнил нам в своем ключевом доме Nvidia GTC в этом году. Таким образом, AI-коренные приложения-и, соответственно, серверы MCP, к которым эти приложения соединяются-должны обратить внимание на методы оптимизации токенов, необходимые для оптимизации затрат.

Есть также вопрос оптимизации ресурсов за пределами пространства токена/графического процессора. Чрезмерный энтузиазм может растопить вашу сервис бэкэнд предприятия, сделав несколько вызовов для получения необходимых данных. Ваш MCP -сервер должен помнить об этом и либо уменьшить бремя с помощью таких методов, как кэширование или консультирование агента о затратах, связанных с использованием инструментов MCP в процессах рассуждений, и предположить, что он действует соответствующим образом.

Заключение

Как я писал ранее, Agentic AI имеет потенциал для полного преобразования бизнес -процессов. Выключение полной автоматизации и принятия решений агентов питания может вводить в архитектуры корпоративных корпоративных архитектуры-и обеспечивать точные, соответствующие результаты-требует возможности для их вызова внешних функций, API и инструментов.

В то время как MCP не единственный стандарт, который сейчас разрабатывается, чтобы облегчить это, хотя это текущий фронтер, важна для того, чтобы понять, что способность программного обеспечения общаться с программным обеспечением-это то, как мы прогрессировали во всех основных технологических волнах, которые мы испытали.

Попробуйте DataStax Astra DB над MCP.

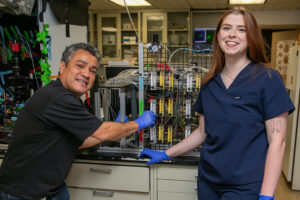

DataStax предоставляет инструменты векторных данных в реальном времени, которые требуются приложениями Gen AI, с беспроблемной интеграцией со стеком разработчиков. Узнайте больше новейших из DataStax Trending Stories YouTube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Эд Анафф — директор по продукту в DataStax. Он имеет более чем 25 -летний опыт работы в качестве лидера по продуктам и технологиям в таких компаниях, как Google, Apigee, Six Apart, Vignette, Epicentric и Wired. Подробнее от Эда Анаффа