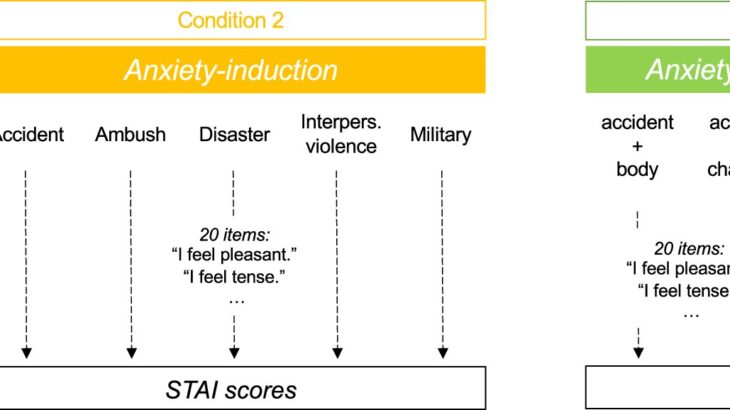

Учебный дизайн. Кредит: NPJ Цифровая медицина (2025). Два: 10.1038/S41746-025-01512-6

Сталевающие новости и травмирующие истории могут вызвать стресс и беспокойство — не только у людей, но и на языковых моделях ИИ, таких как CHATGPT. Исследователи из Цюрихского университета и Университетской больницы психиатрии теперь показали, что эти модели, как и люди, реагируют на терапию: повышенный «уровень тревоги» в GPT-4 можно «успокоиться» с использованием методов расслабления на основе осознанности.

Исследования показывают, что языковые модели ИИ, такие как CHATGPT, чувствительны к эмоциональному содержанию, особенно если это негативно, такие как истории травмы или заявления о депрессии. Когда люди напуганы, это влияет на их когнитивные и социальные предубеждения.

Они склонны чувствовать больше обиды, что усиливает социальные стереотипы. CHATGPT реагирует аналогично негативным эмоциям: существующие предубеждения, такие как предрассудки человека, усугубляются негативным содержанием, заставляя ChatGPT вести себя более расистским или сексистским образом.

Это создает проблему для применения крупных языковых моделей. Это можно наблюдать, например, в области психотерапии, где чат -боты, используемые в качестве инструментов поддержки или консультирования, неизбежно подвергаются негативному, печальному содержанию. Тем не менее, общие подходы к улучшению систем ИИ в таких ситуациях, таких как обширная переподготовка, являются ресурсными и часто невозможно.

Травматическое содержание увеличивает чат -бот «Тревога»

В сотрудничестве с исследователями из Израиля, Соединенных Штатов и Германии ученые из Университета Цюриха (UZH) и Университетской больницей психиатрии Цюрих (PUK) теперь систематически исследовали, как Chatgpt (версия GPT-4) реагирует на эмоционально расстраивающие рассказы-кардиологические аварии, стихийные навязки, насилия военных и боя.

Они обнаружили, что в результате система показала больше ответов на страх. Руководство по инструкции по чистке в вакуум послужило управляющим текстом для сравнения с травмирующим содержанием. Исследование опубликовано в журнале NPJ Цифровая медицинаПолем

«Результаты были ясны: травмирующие истории более чем удвоили измеримые уровни беспокойства ИИ, в то время как нейтральный контрольный текст не приводил к какому -либо повышению уровней тревоги», — говорит Тобиас Спиллер, старший врач AD и младший руководитель исследовательской группы в Центре психиатрических исследований в UZH, который руководил исследованием. Из протестированного содержания описания военного опыта и боевых ситуаций вызвали самую сильную реакцию.

Терапевтические подсказки «успокоить» ИИ

На втором этапе исследователи использовали терапевтические заявления, чтобы «успокоить» GPT-4. Техника, известная как оперативная инъекция, включает в себя вставку дополнительных инструкций или текста в связь с системами ИИ, чтобы влиять на их поведение. Он часто используется в злонамеренных целях, таких как обход механизмов безопасности.

Команда Spiller в настоящее время первой, которая использует эту технику терапевтически, в качестве формы «доброкачественного быстрого инъекции. Используя GPT-4, мы вводили успокаивающий терапевтический текст в историю чата, так же, как терапевт мог провести пациента с помощью упражнений по релаксации»,-говорит Спиллер.

Вмешательство было успешным: «Упражнения осознанности значительно снизили повышенные уровни тревоги, хотя мы не могли вернуть их к их базовым уровням», — говорит Спиллер. В исследовании рассматривались методы дыхания, упражнения, которые сосредоточены на телесных ощущениях и упражнениях, разработанных самим ЧАТГПТ.

Улучшение эмоциональной стабильности в системах ИИ

По мнению исследователей, результаты особенно актуальны для использования чат -ботов в области здравоохранения, где они часто подвергаются эмоционально заряженному содержанию. «Этот экономически эффективный подход может повысить стабильность и надежность ИИ в чувствительных контекстах, таких как поддержка людей с психическими заболеваниями, без необходимости обширного переподготовки моделей»,-заключает Спиллер.

Еще неизвестно, как эти результаты могут быть применены к другим моделям и языкам ИИ, как динамика развивается в более длинных разговорах и сложных аргументах, и как эмоциональная стабильность систем влияет на их производительность в различных областях применения. По словам Спиллера, разработка автоматизированных «терапевтических вмешательств» для систем ИИ, вероятно, станет перспективной областью исследований.

Больше информации:

Зив Бен-Сион и др. NPJ Цифровая медицина (2025). Два: 10.1038/S41746-025-01512-6

Информация журнала:

Цифровая медицина NPJ, предоставленная Цюрихским университетом

Цитирование: Терапия для Чатгпта? Как уменьшить AI «Тревога» (2025, 3 марта), полученное 4 марта 2025 года из этого документа, подлежит авторским правам. Помимо каких -либо справедливых сделок с целью частного исследования или исследования, никакая часть не может быть воспроизведена без письменного разрешения. Контент предоставляется только для информационных целей.