Вычислительные требования к обучению моделей искусственного интеллекта могут привлечь много внимания со стороны технологической индустрии — просто спросите акционеров Nvidia. Но потребности, вызванные выводом ИИ, могут оставить сегодняшние передовые графические процессоры в пыли.

«Если вы посмотрите на мир предварительной подготовки, это было бы как бы монолитное»,-сказал Сид Шет, основатель и генеральный директор D-Matrix, в этом эпизоде новых производителей стека. «Группы доминировали. В частности, графические процессоры от одной компании доминировали в ландшафте. Но когда вы входите в мир вывода, на самом деле это не один размер.

«Существует слишком много разных рабочих нагрузок, каждая нагрузка с очень разными требованиями.… Вы можете быть пользователем, который заботится о стоимости. Там может быть какой -то пользователь, который заботится о интерактивности, где я действительно хочу иметь возможность взаимодействовать с моделью. Там могут быть пользователи, которых на самом деле не заботятся и просто заботятся о пропускной способности».

С этим разнообразием профилей пользователей Шет сказал: «Это не похоже на то же оборудование или та же вычислительная инфраструктура может удовлетворить все эти потребности одновременно.

Он подвел итог: «Мир вывода будет по-настоящему разнородным, где у вас будет специальное, лучшее в своем классе оборудование для удовлетворения конкретных потребностей от конкретных пользователей».

Поддерживать память и вычислять близко

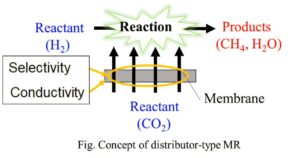

По словам Шет, одной из самых больших проблем с выводом вывода является сохранение памяти (которая держит данные) как можно ближе к вычислительному вычислению. «Причина этого в том, что вы в некотором роде совершаете много поездок в память. Когда вы говорите о генеративных рабочих нагрузках искусственного интеллекта, вы генерируете контент, который опирается на кэширование данных. Таким образом, все предыдущие данные кэшируются. И каждый раз, когда вы генерируете новый токен, по сути, вкладывая данные о том, каким необходимо быть лучшим токеном».

С агентами искусственного интеллекта «эта проблема умножается — 10x или 100x. Таким образом, следов памяти становится очень, очень важным, и удержание этой памяти близко к вычислению становится очень важным. Чем меньше расстояние, которые должны пройти данные, чтобы добраться до вычисления, тем быстрее будет ваш вывод».

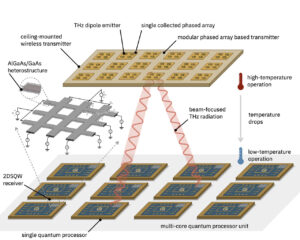

В этом эпизоде Шет обсудил и продемонстрировал платформу вывода AI D-Matrix Corsair, которая использует инновационный подход к архивированию и поиску памяти и вычислению. D-Matrix создает специализированные чипу, он сказал: «А затем мы объединяем эти чипсы в ткань, и это дает нам эту эластичность и модульность на платформе. Мы всегда можем их масштабировать или уменьшить его, в зависимости от требований клиента».

В Corsair память и вычислительные вычисления наложены непосредственно друг на друга — как стопка блинов — значительно сокращение расстояния прохождения вниз. «Данные сидят в этой памяти, и в вычислении идет дождь, который сидит прямо под ним», — сказал Шет. «Площадь поверхности намного больше, когда вы упаковываете вещи таким образом. Очевидно, что между памятью и вычислительностью есть больше площади поверхности, и гораздо больше данных может упасть в вычисление».

Посмотрите на полный эпизод, чтобы узнать больше о выводе, зачем ему нужна другая инфраструктура, чем обучение модели искусственного интеллекта, и о том, что Шет видит в будущем в инфраю в целом.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Хизер Джослин является главным редактором нового стека, с особым интересом к вопросам управления и карьеры, которые имеют отношение к разработчикам и инженерам программного обеспечения. Ранее она работала главным редактором контейнерных решений, облачного консалтинга … Подробнее от Хизер Жослин