Redis, компания, стоящая за одноименной базой данных в памяти в памяти, в основном сообщила новости в последние месяцы из-за изменения лицензии, что привело к запуску проекта Valkey. Теперь Redis надеется немного изменить разговор с запуском двух новых AI-ориентированных продуктов перед запуском Redis 8 в мае. Первым из них является новый инструмент кэширования Langcache, который позволяет разработчикам приносить кэширование отклика на большую языковую модель (LLM) в свои приложения. Вторым является запуск нового типа данных, векторных наборов, для хранения и запроса векторных внедрений.

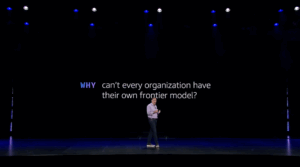

«Redis может быть кратковременным уровнем памяти для агентского стека»,-сказал мне генеральный директор Redis Роуэн Троллоп в интервью перед объявлением. «Это новая стратегия компании, и это то, что мы пытаемся сделать».

Кэширование является очевидным углом для Redis, который уже является популярным решением для кэширования для многих разработчиков. Причины кэширования ответов LLM не так отличаются от других применений (снижение стоимости и задержки), но, учитывая вероятностный характер этих моделей, процесс здесь сильно отличается от кэширования запроса SQL.

По словам Троллопа, Langcache использует Redis «под обложками», но он подчеркнул, что это не база данных Redis. Он использует тонкую модель встраивания, чтобы взять контекст запроса, а затем создать внедрение, чтобы отразить это.

Trollope ожидает, что основным вариантом использования для Langcache станет агенты ИИ, а не столько разговоров от человека к чатботу, которые, как правило, будут более свободными и, следовательно, труднее кэшировать.

«Наша уникальная причина существующего — это действительно производительность и действительно простой API для разработчиков», — сказал Троллоп. «Если вы хотите хранить триллионные векторы в базе данных, и вам все равно, какова это скорость, мы не лучший ответ на это. Но если вы находитесь в среде в реальном времени и хотите быстро двигаться, и задержка важна-я думаю, что будет все больше и больше случаев, когда это важно в этом агентском мире».

Векторные наборы — другая часть уравнения здесь для Redis. Когда Сальваторе «Антирес» Санфилиппо, основатель проекта с открытым исходным кодом Redis, вернулся в компанию в конце прошлого года, он немного рассказал о своем интересе к векторным наборам и о том, почему он считает, что существует необходимость в другом, чтобы подумать о хранении векторных данных.

«Санфилиппо посмотрел на то, что произошло с волной векторной базы данных, и сказал:« Это глупо ». Он сказал: «Все идут в неправильном направлении здесь». Таким образом, Pinecone, Milvus, Weaviate, Yada, Yada, Yada — все они примерно делают одно и то же, то есть они создают базу данных для векторов », — сказал всегда откровенный тролл. «То, как они обычно смотрят, вы добавляете свои данные, а затем у него будет векторный двигатель, проводной в […] И он сшит вектор данных вместе, а затем создает индекс, и вы сможете искать против него ».

Использование векторных наборов, которые также хранят исходные векторы в более сжатом и оптимизированном формате, и новый алгоритм поиска сходства, разработанный Санфилиппо, должно обеспечить значительное ускорение по сравнению с текущим состоянием искусства, утверждает Редис. Поскольку база данных хранится в памяти, это также означает, что требуется меньше потребности в дорогой памяти, или разработчики могут хранить больше этих векторных наборов на своих существующих серверах.

Санфилиппо утверждал, сказал Троллоп, что Редис стал успешным, потому что он не пытался сделать слишком много для разработчиков, и компания должна использовать такой же подход с этим и сделать векторные наборы доступными, как новый строительный блок для разработчиков, чтобы они могли решить, как их использовать.

Что касается бизнеса, Троллоп отметил, что Редис все еще надеялся на IPO в какой -то момент. По его словам, компания почти ломается, и может быть финансово готова к процессу IPO. Вместо этого он хочет сделать глубоко инвестировать в де-факто кратковременную память для приложений искусственного интеллекта (тогда как LLM больше сродни долговременной памяти).

«Я разговаривал с банкирами, которые все хотят, чтобы мы пошли IPO. Они как:« IPO, Go, IPO ». Я не заинтересован в этом, на самом деле, я имею в виду. […] Для предыдущей волны Cloud Mobile Apps Redis был де -факто стандартом, как и любое Dev, создающее Cloud Mobile App, будет привлекать Redis, вероятно, в 95% случаев, — и тогда мы будем монетизировать небольшую часть этого. Теперь у вас есть новая эра, где все собираются переписать все агент приложения, и все еще все в воздухе ».

Trollope считает, что, поскольку разработчики создают эти новые варианты использования и приложения, они будут использовать инструменты, с которыми они знакомы. Он утверждает, агентская архитектура, по сути, использует микросервисы, которые используют LLMS вместо того, чтобы иметь жесткие правила и бизнес-логика в своей основе. Для этого вам нужен слой оркестровки и сеан -магазин, потому что эти микросервисы/агенты должны быть без сохранения состояния. Редис, по его мнению, идеально подходит для разработчиков, которые хотят спасти состояние этих агентов, потому что это быстро и долговечно.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Прежде чем присоединиться к новому стеку в качестве старшего редактора для ИИ, Фредерик был редактором предприятия в TechCrunch, где он освещал все, от роста облака и самых ранних дней Kubernetes до появления квантовых вычислений …. Подробнее от Frederic Lardinois