Signadot спонсировал этот пост.

Многие инженерные команды участвуют в том, чтобы отправить функции искусственного интеллекта. Умный поиск, персонализированные рекомендации, автоматизированная генерация контента — давление для интеграции генеративных возможностей ИИ (Геная) является неустанным. Но вот неудобная истина, которую я обнаружил, разговаривая с сотнями инженерных команд: хотя они могут строить эти функции быстрее, чем когда -либо, надежно тестирование их стало экспоненциально сложнее.

Это не просто проблема производительности; Это фундаментальный кризис тестирования. Команды, создающие функции, способствующие ИИ, обнаруживают, что их существующие подходы к тестированию просто не были предназначены для сложности, которую Genai представляет для архитектур микросервисов.

Вопрос, поддержание технических лидеров, не бодрствующих по ночам, не является: «Как мы создаем функции искусственного интеллекта?» Это: «Как мы узнаем, что они действительно работают надежно в производстве?»

Идеальный шторм: когда Genai встречает микросервисы

Недавно я поговорил с вице-президентом по технике в компании Fintech, пытающейся отправить функции, работающие на AI, чтобы оставаться конкурентоспособными. «Теперь мы можем довольно быстро построить интеллектуальное обнаружение мошенничества», — сказала она мне. «Но каждая функция искусственного интеллекта, которую мы добавляют, приносит новые зависимости — векторные базы данных, LLM [large language model] API, встраивающие услуги, Guardrail Systems. Выяснить, действительно ли все эти компоненты работают вместе с нашей существующей обработкой платежей, аутентификацией пользователя и уведомлениями? Вот где мы тонули ».

Особенности Genai вводят принципиально различный класс сложности, который нарушает традиционные подходы к тестированию:

- Непредсказуемые модели поведения. В отличие от традиционных API, Genai API могут возвращать совершенно разные выходы для аналогичных входов. Вы просто не можете эффективно издеваться над этой изменчивостью.

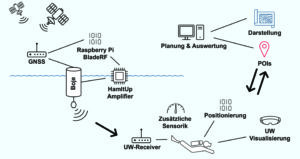

- Сложные цепочки интеграции. Одна функция искусственного интеллекта, как правило, требует организации нескольких сервисов: векторных баз данных, API LLM, API модерации контента и существующих услуг бизнес -логики.

- Внешняя зависимость разрастается. Особенности ИИ в значительной степени полагаются на внешние API -интерфейсы Genai и специализированные базы данных, каждый из которых добавляет новые режимы отказа и шаблоны ответов, которые невозможно имитировать локально.

Почему традиционное тестирование разрушается

Большинство команд пытаются обрабатывать тестирование функций искусственного интеллекта так же, как они всегда тестировали микросервисы: модульные тесты с высмеиваемыми зависимостями, за которыми следуют интеграционные тестирование в общих условиях постановки. Этот подход эффектно терпит неудачу с функциями ИИ по нескольким критическим причинам.

- Макеты не могут захватить поведение ИИ. Как издеваться над ответами LLM? Любая макета, которую вы пишете, будет плохим приближением моделей поведения фактической модели, времени ответа и краевых случаев. Реальная служба искусственного интеллекта может вернуть ответы в совершенно разных форматах на основе контекста, который ваши макет не могут ожидать.

- Местные среды развития становятся невозможными. Запуск векторных баз данных, множества служб искусственного интеллекта и сложная оркестровка локально не просто медленное, часто технически невозможно. Разработчики в конечном итоге тестируют с упрощенными, нереалистичными местными установками, которые мало сходства с производственной средой.

- Проблемы интеграции поверхностны слишком поздно. Команды в конечном итоге полагаются еще в большей степени на постановку среды, чтобы подтвердить, что все на самом деле работает вместе. Но с большим количеством команд, конкурирующих за одни и те же общие постановочные ресурсы, это создает огромные узкие места. При проведении перерывов — и часто это делает с функциями ИИ — целые инженерные команды блокируются.

- Отладка становится кошмаром. Когда многочисленные функции ИИ развертываются для одновременного постановки и что -то ломается, поиск первопричины становится все равно, что раскрытие загадки убийства. Это был новый алгоритм рекомендаций? Обновленная модерация контента? Взаимодействие между несколькими изменениями? Инженеры тратят дни, переключаясь на код, который они написали несколько недель назад.

Легкий императив для систем искусственного интеллекта

Решение не замедлить разработку функций искусственного интеллекта — это сдало бы конкурентное преимущество. Решение состоит в том, чтобы принципиально переосмыслить, когда и как мы проверяем эти сложные интеграции.

Передовые команды переключают левое исчерпывающее тестирование, подтверждая поведение функций искусственного интеллекта в реалистичных средах до того, как код даже сорвается. Но вот важная информация: «Сдвиг слева» не означает, что тестирование локально с макетами. Это означает, что с приближением производственной среды ближе к рабочим процессам разработчиков.

Именно здесь традиционный левый совет сдвигается для систем ИИ. Вы не можете запустить все на своем ноутбуке, и вы не можете издеваться над всем, не теряя верности. Сложность интеграции ИИ требует другого подхода: легкие, реалистичные среды, к которым разработчики могут немедленно получить доступ без накладных расходов на полную среду дублирования.

Реалистичные среды: недостающая часть

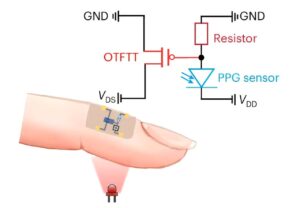

Что, если вместо выбора между дорогостоящим дублированием полной среды или нереалистичными макетами, был третий вариант? Современные платформы для тестирования на основе песочницы решают это, раскручивая легкие среды, содержащие только модифицированные сервисы при маршрутизации запросов на реальные услуги искусственного интеллекта, базы данных и нижестоящие зависимости, работающие в общей базовой линии.

Этот подход позволяет тестировать на фактические API LLM с реальными шаблонами ответа, проверки истинных интеграций услуг и выявления специфичных для искусственного интеллекта проблем, в то время как код свежий без затрат на дублирующие целые среды.

Конкурентное преимущество

Команда Fintech, с которой я работал, недавно сократила свое время доставки функций ИИ с недель до часов, используя этот подход. «Раньше мы проводили больше времени на отладку проблем с постами, чем на строительстве», — сказал мне их инженерный директор. «Теперь мы немедленно поймаем проблемы с интеграцией AI, в то время как разработчики все еще помнят, почему они сделали конкретный выбор реализации».

Математика убедительна. Когда проблемы интеграции искусственного интеграции появляются в постановке после того, как несколько команд внесли изменения, отладка может потреблять дни инженерного времени. Когда те же проблемы попадают в изолированные песочницы во время процесса запроса на вытяжение, разрешение занимает минуты.

Что еще более важно, команды, которые могут проверить функции искусственного интеллекта, быстро поставляют больше возможностей для ИИ. В то время как конкуренты борются с постановкой узких мест и загадки интеграции, дальновидные организации быстро итерации быстро итерации в возможностях ИИ, которые повышают ценность бизнеса.

Помимо кризиса тестирования

Революция Genai создает совершенно новые классы сложности программного обеспечения, для которых наши существующие инструменты тестирования не были предназначены для обработки. Организации, которые будут процветать, — это те, которые дополняют традиционные тесты на единицу и интеграции с реалистичным тестированием среды, которые могут фактически проверять сложное, непредсказуемое поведение систем ИИ.

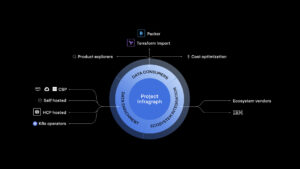

В Signadot мы видим эту смену из первых рук, поскольку все больше команд принимают тестирование на основе песочницы для своих функций искусственного интеллекта. В мире, где создание функций ИИ становится легче с каждым днем, конкурентное преимущество принадлежит командам, которые могут проверить их быстрее. Вопрос не в том, будет ли ваша команда принять реалистичные тестирование среды для функций искусственного интеллекта — это сделает ли вы это до того, как ваши конкуренты сделают.

Signadot-это платформа для тестирования Kubernetes для микросервисов. Используя Signadot, инженерные команды «сдвигаются налево», чтобы выяснить проблемы раньше и повысить доверие. Узнайте больше новейших из Signadot Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Арджун Айер, генеральный директор Signadot, является опытным экспертом в облачной местной области с глубокой страстью к улучшению опыта разработчика. У Арджуна хвастается более чем 25-летним опытом работы в отрасли, есть богатая история разработки программного обеспечения для интернет-масштаба и … Подробнее от Arjun Iyer