Последние крупные языковые модели (LLMS) по-прежнему получают большую часть шума, но для тех, кто был сосредоточен на реальном потенциале ИИ, волнение за последний год сместился к обещанию интеллектуальных приложений, основанных на LLMS, иначе известных как агенты искусственного интеллекта.

Как только люди поймают концепцию агентского ИИ, понятие приложений, которые могут самостоятельно учиться, принимать решения и принимать меры, захватывает воображение. Возможности для личных помощников на основе AI, помощников по кодированию и вертикальных приложений, начиная от просмотра здравоохранения до агентов гостеприимства, бесконечны.

Агенты ИИ скоро автоматизируют многие аспекты нашей жизни. автоматизация, которую они могут предоставить, падает на три категории:

Когнитивная автоматизация Эмулирует человеческое мышление, такое как генеративное моделирование за чатами ИИ, которые синтезируют оригинальный текст и изображения.

автоматизация системы Не только заменяет управление человеческой системой, но и устраняет статические, предопределенные ответы, позволяя системам самодиагностировать и самовосстанавливаться, когда они терпят неудачу.

Физическая автоматизация позволит роботизированным системам ориентироваться в реальном мире, но разработка основополагающих моделей для этой цели все еще продолжается.

Чтобы агенты искусственного интеллекта любого типа были полезны, им необходимо взаимодействовать с другими приложениями, чтобы увеличить базовый LLM, получая дополнительные данные или сообщить другим приложениям для выполнения каких -либо действий. Это взаимодействие может быть с другим агентом искусственного интеллекта или с системой, в которой вообще не хватает встроенного интеллекта.

Другими словами, агенты ИИ можно рассматривать как интеллектуальные услуги в распределенных системах. И, как и в случае почти всех распределенных систем, API позволяют взаимодействовать между услугами.

Жизненно важная роль APIS

Взаимодействие между ИИ и API является мощным. LLMS статичны: их обучение требует огромных вычислительных ресурсов, и после обучения они остаются неизменными, пока поставщик LLM не выпустит новую версию. Напротив, хотя агенты ИИ работают над LLM, они динамичны, увеличивая свои предварительно обученные модели с помощью новых данных с помощью API по мере выполнения своих задач.

Одним из способов оценки динамического характера агентских систем ИИ является сопоставление их с обычными приложениями, основанными на микросервисах. С последним, хотя каждый микросервис имеет API, взаимодействие между услугами предопределено разработчиком или архитектором приложений. С агентством ИИ сам агент ИИ решает, с какими услугами или агентами соединяться в зависимости от поставленной задачи.

Агент ИИ оценивает различные факторы, определяет закономерности, основанные на его обучающих данных, и определяет наиболее разумный следующий шаг для достижения наилучших возможных результатов. Затем он обращается к AP-доступным службам для обогащения ответов или выполнения различных действий для выполнения запроса пользователя. Некоторые поставщики услуг, такие как Stripe и Amazon, уже выпустили API, адаптированные для рабочих процессов на основе агентов, в то время как другие используют протокол контекста модели (MCP), чтобы сделать свои API доступными для LLMS.

Естественно, агент ИИ должен использовать только доверенные API. Одним из мест для их поиска является сеть Postman API, которая предлагает крупнейший в мире каталог проверенных публичных API от доверенных поставщиков, доступных для LLMS, посредством облегченного генерации кода или размещенных в качестве MCP. В рамках организации несколько команд инженеров и продуктов также сотрудничают с помощью частных API. В зависимости от характера агента и пользовательского подсказки, агенты искусственного интеллекта могут использовать комбинации как публичных, так и частных API, чтобы инициировать действия или генерировать ответы.

Управление агентскими рисками ИИ

Агент ИИ поднимает ставки для результатов ИИ. Сегодня мы часто переносят случайную галлюцинацию или ложную информацию из -за ограниченных учебных данных, доступных от чат -ботов искусственного интеллекта. Ошибка имеет радикально разные последствия, когда, скажем, агентам искусственного интеллекта несет ответственность за управление облачной инфраструктурой или взаимодействие с клиентами таким образом, чтобы все еще звучали человеком.

Вот почему будет градиент агентов. Некоторым из них будет доверять, чтобы они были полностью автономными, в то время как другим потребуется человеческий проверчик в цикле, с шагом одобрения и гарантированием в рамках процесса утверждения. Разработка ограждений, чтобы определить, что агенты могут и не могут делать, следует считать минимумом; Однако такие ограждения требуют исследований и разработок, и мы все еще находимся на этапе эксперимента.

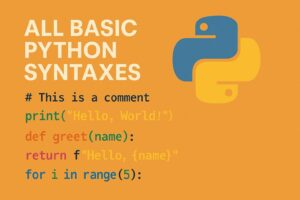

Строгое тестирование систем агентов ИИ имеет важное значение. Агенты ИИ могут предпринять автономные действия, поэтому, если эти действия пойдут не так, они могут нанести серьезный ущерб, особенно если они скомпрометированы или плохо спроектированы. Разработчики должны протестировать как системные, так и пользовательские подсказки, контрольное время отклика и сравнить LLMS, чтобы выбрать лучший для данной агентской системы. После выбора, LLMS, лежащие в основе агентов искусственного интеллекта, должны быть точно настроены для достижения лучших, наиболее предсказуемых результатов.

API в рамках агентской системы должны быть полностью защищены. Чтобы предотвратить злоупотребление API, необходимо создать надежную аутентификацию, разрешение и ограничение ставок как для API, так и для API, к которым они получают доступ при вызовах данных или функциях, предлагаемых обычными системами.

Наше агент будущее

Генеральный директор NVIDIA Дженсен Хуан сказал, что «ИТ -департамент каждой компании станет отделом кадров агентов искусственного интеллекта». Аналогия не так неправдоподобна, как кажется: как люди, интеллектуальные агенты должны соблюдать правила, непрерывно учиться и обеспечивать ресурсы, которые позволяют им процветать.

Организации будут разрабатывать и развернуть десятки и десятки агентов искусственного интеллекта с течением времени. В зависимости от их сдачи, эти агенты могут интенсивно общаться друг с другом по сложным совместным задачам, открывая целый новый мир интеллектуальных систем. Многочисленные агенты могут работать поверх одного и того же LLM, в то время как другие могут быть построены на различных языковых моделях, включая более мелкие модели для специализированных задач.

Мы переходим от парадигмы, где все предписано и статичнее к тому, где агенты ИИ по существу думают, с миром доступных AP-доступных данных и функциональности для их расширения своих возможностей. Разработчикам больше не нужно будет писать код на каждом этапе процесса. И в тех блестящих разработчиках новых агентских систем создают, без API, нет ИИ.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Родрик Рабба является главой продукта для Postman Plows, визуального программирования, предлагающего ведущей мировой платформы API. Ранее он основал Nimbella, облачную компанию без серверов, приобретенную Digitalocean, и создала Apache OpenWhisk, ведущую платформу с открытым исходным кодом, не работающую на сервере …. Подробнее от Rodric Rabbah