Привет, ребята, добро пожаловать в регулярную рассылку AI TechCrunch. Если вы хотите это в своем почтовом ящике каждую среду, зарегистрируйтесь здесь.

Возможно, вы заметили, что мы пропустили информационный бюллетень на прошлой неделе. Причина? Хаотичный цикл новостей ИИ, ставший еще более попощатым из -за внезапного роста китайской компании AI Deedseek на известность, и реакция практически в общем зачете промышленности и правительства.

К счастью, мы вернулись на правильный путь — и не слишком рано, учитывая новые разработки на прошлых выходных от Openai.

Генеральный директор Openai Сэм Альтман остановился в Токио, чтобы поболтать на сцене с Масайоши Сон, генеральным директором японского конгломерата Softbank. SoftBank является крупным инвестором и партнером OpenAI, который пообещал помочь фонду массового проекта инфраструктуры центра обработки данных OpenAI в сша

Так что Альтман, вероятно, чувствовал, что он должен сын несколько часов своего времени.

О чем говорили два миллиардера? Много абстрагирующих работает через AI «агенты», отчетность в подержании. Сон сказал, что его компания будет тратить 3 миллиарда долларов в год на продукты Openai и объединится с Openai для разработки платформы »,« Кристал [sic] Интеллект », с целью автоматизации миллионов традиционных рабочих процессов белых воротничков.

«автоматизация и автономизирование всех своих задач и рабочих процессов, Softbank Corp. преобразует свой бизнес и услуги и создаст новую ценность», — сказал Softbank в пресс -релизе в понедельник.

Я спрашиваю, однако, что стоит смиренный работник, чтобы подумать обо всех этих автоматизации и автономизировании?

Как и Себастьян Сиемиатковски, генеральный директор Fintech Klarna, который часто хвастается из-за замены ИИ, сын, кажется, придерживается мнения, что агентские автономные заведения для работников могут только ускорить сказочное богатство. Закрытый — это стоимость изобилия. Если широко распространенная автоматизация рабочих мест пройдет, безработица в огромном масштабе кажется самым вероятном результатом.

Неответственно, что те, кто находится на переднем крае гонки искусственного интеллекта — такие компании, как Openai и инвесторы, такие как Softbank, — предпочитают потратить пресс -конференции на рисующих картину автоматизированных корпораций с меньшим количеством работников на заработной плате. Это предприятия, конечно, не благотворительные организации. И разработка ИИ не поступает дешево. Но, возможно, люди будут доверять ИИ, если те, кто направляет его развертывание, проявили немного больше заботы о своем благополучии.

Еда для размышлений.

Новости

Глубокое исследование: OpenAI запустил новый «агент» ИИ, предназначенный для того, чтобы помочь людям провести подробные, сложные исследования с использованием CHATGPT, платформы чат-ботов на основе AI на основе AI.

O3-Mini: В других новостях Openai компания запустила новую модель «рассуждения», O3-Mini, после предварительного просмотра в декабре прошлого года. Это не самая мощная модель Openai, но O3-Mini может похвастаться повышенной эффективностью и скоростью отклика.

Я запрещаю рисковать там: По состоянию на воскресенье в Европейском союзе регуляторы блока могут запретить использование систем ИИ, которые они считают «неприемлемым риском» или вредом. Это включает в себя ИИ, используемый для социальной оценки и подсознательной рекламы.

Спектакль об искусственном интеллекте «Doomers»: Есть новая игра о культуре «Doomer» AI, основанной на изгнании Сэма Альтмана в качестве генерального директора Openai в ноябре 2023 года. Мои коллеги Доминик и Ребекка делятся своими мыслями после просмотра премьеры.

Технология для повышения урожайности: На этой неделе Google X «Moonshot Factory» объявил о своем последнем выпускном. Наследственное сельское хозяйство- это стартап, управляемый данными и машинным обучением, направленным на улучшение того, как выращиваются культуры.

Исследовательская работа недели

Модели рассуждений лучше, чем ваш средний ИИ при решении проблем, особенно в научных и математических запросах. Но они не серебряная пуля.

Новое исследование исследователей из китайской компании Tencent исследует проблему «недостаточного мышления» в моделях рассуждений, где модели преждевременно, необъяснимым образом отказываются от потенциально многообещающих цепочек мышления. Согласно результатам исследования, закономерности «недостаточное мышление», как правило, встречаются чаще с более сложными проблемами, что приводит к переключению между цепочками рассуждений без ответов.

Команда предлагает исправление, в котором используется «штраф за размышления», чтобы поощрить модели к «тщательно» развивать каждую линию рассуждений, прежде чем рассматривать альтернативы, повышая точность моделей.

Модель недели

Команда исследователей, поддержанная владельцем Tiktok Bytedance, китайской компанией AI Moonshot, и другие выпустили новую открытую модель, способную создавать относительно качественную музыку от подсказок.

Модель под названием YUE может вывести песню до нескольких минут в длину с вокалом и дорожными треками. Он находится под лицензией Apache 2.0, что означает, что модель может использоваться в коммерческих целях без ограничений.

Однако есть недостатки. Бег Юэ требует мускулистого графического процессора; Создание 30-секундной песни занимает шесть минут с NVIDIA RTX 4090. Более того, неясно, была ли модель обучена с использованием защищенных авторским правом данных; Его создатели не сказали. Если оказалось, что авторские права действительно были в учебном наборе модели, пользователи могут столкнуться с будущими проблемами IP.

Захватить сумку

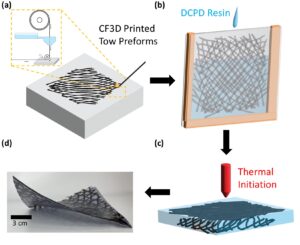

Лаборатория ИИ Антропические утверждения о том, что она разработала методику для более надежной защиты от «джейлбрейков», методов, которые можно использовать для обхода мер безопасности системы ИИ.

Техника, конституционные классификаторы опираются на два набора моделей «классификатора»: «входной» классификатор и классификатор «вывода». Входной классификатор добавляет подсказки в защищенную модель с шаблонами, описывающими джейлбрейки и другое запрещенное содержание, в то время как выходной классификатор вычисляет вероятность того, что ответ от модели обсуждает вредную информацию.

Антропический говорит, что конституционные классификаторы могут отфильтровать «подавляющее большинство» джейлбрейков. Тем не менее, это стоит по цене. Каждый запрос на 25% более требователен на вычислительном отношении, а защищенная модель на 0,38% реже отвечает на безобидные вопросы.