В ноябре прошлого года Anpropic запустил протокол контекста модели (MCP), стандарт с открытым исходным кодом, предназначенный для оптимизации того, как модели искусственного интеллекта взаимодействуют с API. Как мы объяснили ранее в этом месяце, это видение состоит в том, чтобы сделать MCP универсальным методом для агентов ИИ, чтобы вызвать внешние действия.

MCP привлекла большой интерес к своим первым нескольким месяцам, в том числе от API Management Companies, таких как Spekeasy. Компании API рассматривают MCP как механизм связывания с богатой экосистемой LLM и агентских рамок. Чтобы узнать больше, я поговорил с генеральным директором Speakeasy Сагаром Батче.

Что такое модельный протокол контекста (MCP)?

Как объяснено в его документации, MCP «следует архитектуре клиента-сервер, где хост-приложение может подключаться к нескольким серверам».

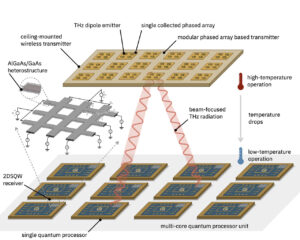

По сути, MCP стандартизирует доступ API для агентов AI. Вы также можете думать об этом как о мета-API, как показывает эта диаграмма от Мэтта Покока:

«Таким образом, MCP — это протокол и действительно очень тонкий слой над API, в котором говорится, что вот определение, что этот API должен разоблачить для LLM или агента, чтобы иметь возможность запрашивать и узнать больше о […] Какими бы ни были эти данные », — объяснил Батче.

Клиентом MCP может быть LLM, такой как Claude, Ides, как курсор и Windsurf, и различные другие инструменты (такие как Spinai, структура TypeScript для построения агентов ИИ).

Что касается сервера MCP-блока оранжевого цвета на приведенной выше диаграмме-вы можете либо создать свой собственный, либо использовать предварительно построенный MCP-сервер. В своем вступительном сообщении в блоге «Антропический» упомянул, что существуют предварительно созданные серверы MCP «для популярных предприятий, таких как Google Drive, Slack, Github, Git, Postgres и Puppeteer».

Роль Speakeasy в архитектуре MCP

Создание собственного MCP-сервера-это то место, где появляется Speakeasy. Недавно компания запустила MCP Server Generation, инструмент, который автоматизирует создание MCP-совместимых серверов.

В настоящее время генерация MCP-сервера SpeakeAsy поддерживает SDK на основе TypeScript. Однако, учитывая доминирование Python в экосистеме ИИ, компания планирует в ближайшее время добавить поддержку Python.

Batchu отметил, что, поскольку MCP работает как модель клиентского сервера, агенты искусственного интеллекта, взаимодействующие с сервером MCP, могут использовать любой язык программирования. Он объяснил, что, в отличие от традиционных SDK, которые являются специфичными для языка и требуют от разработчиков писать код интеграции-серверы MCP обнажают конечные точки, к которым агенты ИИ могут получить непосредственно.

Как MCP сравнивается с OpenAPI?

OpenAPI является широко принятым стандартом для определения API, поэтому на первый взгляд он также является своего рода слоем выше API. Но, по словам Batchu, MCP опирается на OpenAPI, а не заменяет его.

«Прыжок от спецификации Openapi на MCP очень маленький», — сказал он. «OpenApi — это какая -то суперсет всей информации, которая нуждается MCP, а затем вы собираете ее с конкретными примерами и описаниями [for] LLM, и вы запускаете его как сервер ».

Иными словами: в то время как OpenAPI предоставляет структурированное определение возможностей API, это в первую очередь статическая спецификация. MCP, напротив, вводит модель взаимодействия с клиентом. MCP -сервер — это живой, управляемый экземпляр, который агенты ИИ могут запросить в режиме реального времени. Это означает, что сервер MCP может динамически реагировать на запросы, сгенерированные AI, что делает API более доступными для агентских рабочих процессов.

«Прыжок от спецификации OpenAPI на MCP очень маленький».

— Сагар Батче, генеральный директор Speakeasy

Как сказал Батче, «разница в [that] Спецификация OpenAPI-это просто определение, а MCP-сервер на самом деле является опытом сервера-клиента ».

До прибытия MCP, интеграция API с моделью ИИ была сложной задачей. Батчжу отметил, что многие интеграции API на основе API не удались, потому что у моделей не хватало необходимой информации схемы для понимания ответов API. MCP решает это путем структурирования взаимодействий API таким образом, чтобы ИИ мог понять, что делает интеграции более надежными.

Реальные варианты использования для серверов MCP

По словам Батче, у Soipsey уже есть несколько клиентов, использующих свой набор функций MCP. Такие компании, как Vercel, Dub и другие, используют серверы MCP для улучшения своих рабочих процессов, управляемых API.

На Dub, платформе обмена ссылками маркетинговые команды часто создают короткие ссылки для отслеживания производительности статьи. Вместо ручного поиска аналитических панелей аналитики они теперь могут попросить помощника искусственного интеллекта извлечь свои самые клиркированные ссылки на прошлой неделе. MCP -сервер AI Dub Dub Dub получает соответствующие данные и даже генерирует визуализацию — все без пользователя покидают свой интерфейс чата.

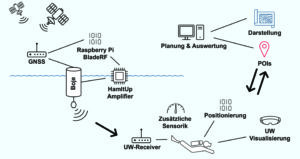

Speakeasy Customer Dub с использованием MCP.

Я спросил о потенциальных приложениях электронной коммерции, так как это область, по-видимому, хорошо подходит для агентов искусственного интеллекта. Представьте себе такую компанию, использующую MCP для питания бизнес-аналитики, управляемой искусственным интеллектом, предложил Батче. Помощник искусственного интеллекта может запросить сервер MCP для данных о продажах, генерировать отчеты и даже предлагать маркетинговые стратегии на основе идей в реальном времени. Это уменьшило бы необходимость в извлечении и анализе ручной данные.

Конкурирующие стандарты впереди?

Anpropic разработал MCP, но до сих пор не было никаких признаков того, что другие большие собаки в ИИ примут его — такие, как Openai, Google и Meta.

Batchu считает, что парадигма MCP, вероятно, будет развиваться вместе с другими подходами API-управляемого AI. Он отмечает, что функция Openai уже дает возможность для моделей искусственного интеллекта взаимодействовать с внешними службами, хотя в нем не хватает стандартизированной, открытой природы MCP.

«Я полагаю, что какое -то время будет немного войн схемы, пока он не встанет на что -то вроде Openapi, верно, где есть стандарт», — сказал он.

«Некоторое время будет немного схемы войн».

— Батче

Несмотря на это, Batchu думает, что время для продюсеров API созрело время экспериментировать с MCP.

«Производители API должны инвестировать в агентские инструменты, такие как MCP, и, вы знаете, создавать репо, создать его, выпустить там».

Аналогичным образом, он думает, что потребители API должны экспериментировать, хотя он признает, что для них будет больше «разрушения и хаоса» — потому что стандарты все еще находятся в движении. Но у него есть несколько советов для разработчиков, которым поручено использовать API наряду с ИИ.

«Первое, что вы можете сделать, — это посмотреть, если у API есть сервер MCP. Вы можете установить это локально в свой клиент настольного компьютера IDE или LLM и фактически просто начать интегрироваться через запросы [via] естественный язык ».

Batchu также отмечает, что для разработчиков есть возможность для автоматизации рабочих процессов и динамически извлекать понимание из API, используя MCP вместе с агентскими рамками, такими как Langchain и Autogen.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Ричард Макманус — старший редактор нового стека и пишет о тенденциях разработки веб -и приложений. Ранее он основал ReadWriteWeb в 2003 году и встроил его в один из самых влиятельных технологических новостей в мире. С самого раннего … Подробнее от Ричарда Макмануса