CNCF спонсировал этот пост.

По мере того, как крупные языковые модели (LLMS) все более неотъемлемые для корпоративных приложений, становится первостепенным их надежно развернуть. Общие угрозы, такие как быстрые инъекции, могут привести к непреднамеренному поведению, нарушениям данных или несанкционированному доступу к внутренним системам. Традиционные меры безопасности на уровне приложения, хотя и ценные, часто недостаточны для защиты конечных точек LLM.

Контейнеризация может помочь решить эти проблемыПолем Обертывая LLMS и их вспомогательные компоненты в контейнерах, организации могут обеспечить строгие границы безопасности на уровне инфраструктуры. Этот многослойный подход в сочетании с надежными механизмами ограждения (например, из Nvidia nemo Guardrails) помогает предотвратить подозрительные или злонамеренные подсказки добраться до логики основной модели.

В этой статье изложены проектирование и соображения, необходимые для реализации безопасного развертывания LLM предприятия. В качестве иллюстрации мы используем платформу Kubernetes на Oracle Cloud Infrastructure (OCI) с OCI Kubernetes Engine (OKE), что очень соответствует Cloud Cloud Computing Foundation (CNCF) Kubernetes с открытым исходным кодом. Эта реализация также должна работать с Kubernetes с открытым исходным кодом. Наш пример функций:

- Контейнерные ограждения, чтобы противостоять быстрому инъекционным атакам.

- Многослойные политики сети, ресурсов и доступа в Оке.

- Интеграция с Kubeflow для непрерывного обучения, проверки и развертывания (операции машинного обучения или MLOP).

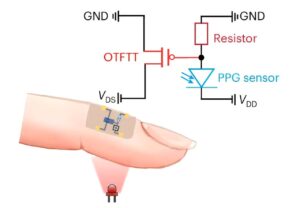

Сквозная диаграмма рабочего процесса

Эта диаграмма показывает архитектуру решения, которое мы представим в этой статье.

Понимание оперативных уязвимостей инъекций

Оперативная инъекция — это тип атаки, специфичный для LLMS, в котором вводится поделки противника (подсказка), которые манипулируют поведением модели. Например, злоумышленник может создать текст, который обходит фильтры содержимого или раскрывает системные инструкции, которые должны оставаться конфиденциальными. Эта эксплуатация может привести к:

- Несанкционированный доступ к данным: Получение понимания скрытых подсказок, конфиденциальных пользовательских данных или системных API.

- Неожиданное поведение LLM: Создание вредных, смещенных или запрещенных выходов.

Бывшие инъекционные атаки создают уникальные проблемы, что делает их особенно опасными в корпоративных условиях. В отличие от традиционных инъекционных атак, таких как инъекция SQL или сценарии поперечного сайта (XSS), которые могут быть обнаружены посредством соответствия подписи, быстрые инъекции включают тонкие текстовые манипуляции, которые легко уклоняются от стандартных методов обнаружения.

Динамический, зависимый от контекста природа LLMS еще больше усложняет эту проблему, поскольку вредоносные участники могут использовать собственные возможности рассуждения модели для обоирования защитных мер. Более того, в сложных предпринимательских системах успешная оперативная атака впрыска, которая показывает конфиденциальные данные, может служить ступенькой для злоумышленников, чтобы установить более широкие угрозы на основе сети.

Ограждения и безопасность на основе контейнеров

Нам нужны фильтры безопасности, и есть варианты создания таких фильтров, способных сканировать и дезинфицировать подсказки. Давайте посмотрим на одно такое решение:

Nvidia Guardrails

Nvidia Guardrails — это рамка с открытым исходным кодом для интеграции фильтров безопасности, которые могут сканировать и дезинфицировать подсказки, прежде чем они достигнут движения вывода LLM. Ключевые функции включают:

- Текстовая фильтрация: Выявление вредоносных или подозрительных моделей подсказок.

- Контекст правоприменения: Ограничение операционного контекста (например, обеспечение LLM обсуждает только определенные темы).

- Адаптивное обучение: Непрерывное улучшение наборов правил и стратегии реагирования по мере появления новых угроз.

В сочетании с оркестровкой контейнеров Kubernetes, Nvidia Guardrails может работать в качестве контейнера с предварительным устройством, который обеспечивает соблюдение политик безопасности по входящим запросам.

Многослойные элементы управления безопасности контейнеров

Интеграция логики Guardrail в контейнерах обеспечивает несколько уровней выгод безопасности, которые повышают общую защиту развертывания LLM. Эти контейнерные управления безопасности работают совместно с ограждениями, чтобы создать комплексную стратегию обороны. Преимущества включают:

- Изоляция сети: Сетевые политики Kubernetes ограничивают трафик между стручками. Контейнер LLM общается только с контейнером Guardrail и авторизованными службами.

- Ограничения ресурсов: Пределы процессора и памяти в Kubernetes помогают предотвратить монополизировать каких-либо контейнеров каких-либо кластерных ресурсов или запустить сценарий отказа в обслуживании.

- Политики безопасности во время выполнения: Такие инструменты, как SECCOMP, Apparmor или Selinux, уменьшают поверхность атаки, ограничивая системные вызовы, которые могут выполнять контейнеры.

Контейнерные элементы управления доступом

Организации, развертывающие конечные точки LLM в контейнерах, могут реализовать несколько важных элементов управления доступа для повышения безопасности:

- Наименьшая привилегия доступ: Гранулистые роли на основе ролей контроль доступа (RBAC), которые могут развертывать, изменять или добывать журналы из определенных контейнеров.

- Управление секретами: Этот метод надежно хранит клавиши API, ключи шифрования или учетные данные в таких услугах, как Vault или в секретах Kubernetes.

Модель развертывания

На высоком уровне модель развертывания реализует структурированный подход к обработке запросов пользователей, включая несколько специализированных контейнеров, которые выполняют конкретные функции безопасности и эксплуатации. Эта архитектура помогает гарантировать, что каждый запрос подвергается соответствующей проверке и обработке до достижения LLM и возвращения к пользователю. Некоторые из компонентов включают в себя:

- Пользовательская подсказка: Запрос пользователя вступает в систему через приложение frontend или шлюз API.

- Контейнер для ограждения: Запрос пересылается в специализированный контейнер (например, Nvidia Guardrails), который осматривает подсказку для злонамеренного или запрещенного контента.

- LLM контейнер с выводом: Если подсказка передает проверку ограждения, оно направляется в контейнер, размещающий LLM. Все операции по выводу и данные о состоянии состояния остаются здесь.

- Контейнер обработки вывода: Необязательно, другой контейнер может перепроверить ответ LLM или дезинфицировать его, прежде чем вернуть его пользователю.

- Непрерывный мониторинг: Журналы и метрики подают в централизованный стек мониторинга, предупреждая операторов, если возникает подозрительная активность.

Экстремальная среда

Включение Kubeflow для Mlops

Kubeflow служит важной платформой Mlops с открытым исходным кодом, которая наступает на Kubernetes, обеспечивая решающие возможности для управления развертываниями LLM. Это обеспечивает комплексное отслеживание экспериментов, позволяя командам контролировать и сравнивать различные эксперименты с точной настройкой для моделей LLM.

Благодаря функциям автоматизации трубопроводов Kubeflow оптимизирует рабочий процесс от приема данных посредством обучения, проверки и развертывания моделей. Используя возможности масштабирования Kubernetes, он эффективно обрабатывает большие наборы данных об обучении и поддерживает несколько параллельных экспериментов, что делает его идеальным для операций LLM в масштабе предприятия.

Интеграция рабочего процесса

Возможности интеграции рабочих процессов Kubeflow повышают безопасность и надежность развертывания LLM за счет автоматизации критических процессов и обеспечения последовательного применения управления безопасности. Платформа поддерживает несколько ключевых рабочих процессов, ориентированных на безопасность:

- Обучение и проверка: Используйте трубопроводы Kubeflow, чтобы запланировать и автоматизировать подготовку данных, LLM-шаги тонкой настройки и проверки.

- Обновления правил ограждения: Когда вы обнаружите новые потенциальные оперативные модели впрыска во время обучения или из производственных журналов, вы можете обновить правила или фильтры Guardrail. Это обновление может быть автоматически применено к контейнеру Guardrail через обновления Kubernetes.

- Развертывание: Kubeflow запускает контейнер и развертывание в Kubernetes, когда будет подтвержден набор правил модели или правил ограждения, обеспечивая непрерывную доставку с минимальным временем простоя.

Операционные лучшие практики

- Непрерывный мониторинг и регистрация: Соберите журналы из контейнеров Guardrail и LLM. Такие инструменты, как Прометея и Графана, время отклика, ошибок и моделей использования.

- Логирование аудита: В целях соответствия сохраняйте журналы того, кто получил доступ к LLM, введенные подсказки и, если таковые были помечены контейнером Guardrail.

- Регулярные оценки безопасности: Периодически запустить тесты на проникновение, посвященные быстрым инъекциям и попыткам обойти логику ограждения.

- Многокрасные или гибридные развертывания: Для аварийного восстановления или специализированных вариантов использования рассмотрите возможность развертывания по нескольким кластерам или гибридным настройкам (локальности + облако).

Заключение

Оперативные инъекции представляют собой серьезную и развивающуюся угрозу для развертывания LLM. Комбинируя ограждения на уровне приложения (например, Nvidia Guardrails) с мерами безопасности на уровне контейнеров, организации могут внедрить надежную, многослойную защиту. Этот подход помогает предотвратить вредоносные или манипулятивные входные данные о компромиссной функции LLM или более широкой инфраструктуре.

Использование Kubeflow для MLOPS добавляет дополнительную устойчивость и ловкость, что позволяет постоянно улучшать как модель LLM, так и соответствующие правила ограждения. Эта контейнерная, высоко оркестренная архитектура обеспечивает необходимую масштабируемость, безопасность и управляемость для развертывания LLM предприятия.

Облачный фонд Cloud Computing Foundation (CNCF) проводит критические компоненты глобальной технологической инфраструктуры, включая Kubernetes, Prometheus и Angoy. CNCF является нейтральным домом для сотрудничества, объединяющий ведущих разработчиков отрасли, конечных пользователей и поставщиков. Узнайте больше последних из CNCF Trending Stories YouTube.com/ThenewStack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Sanjay Basu PhD, старший директор — Gen AI/GPU Cloud Engineering в Oracle. Он сосредотачивается на продвинутых услугах, таких как генеративный ИИ, машинное обучение, инженерию GPU, блокчейн, микросервисы, промышленный IoT, Core 5G, а также облачная безопасность и соответствие. У него дважды … Читать больше от Санджая Басу Виктора — стратег по контенту в Oracle. Он писатель и отец двоих, базирующийся в Ноксвилле, штат Теннесси. Подробнее от Виктора Агреда