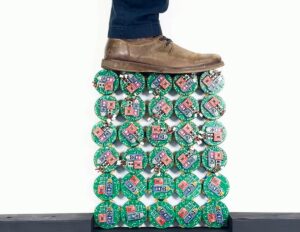

Давайте представим сценарий: есть больница, где пациенты владеют своими медицинскими картами. Больница хочет, чтобы медицинские помощники с поддержкой AI устанавливали на их личные устройства мониторинга, чтобы медицинские работники могли отслеживать и анализировать данные и обеспечивать обратную связь в реальном времени для обеспечения рутинных и экстренных лекарств, но система должна соответствовать региональным медицинским правилам. В таких случаях подходы к вычислительным вычислениям надежны для точности и безопасности данных — и работают локально; Облако не требуется.

Теперь представьте себе возможности, когда Edge Computing питается с Genai. Это слияние не просто делает решение умнее — это делает решение автономным и открывает новые возможности для разработки персонализированного, интеллектуального здравоохранения. Но воздействие вычислений по крае не ограничивается только здравоохранением. Он также может трансформировать отрасли, такие как инвестиционный сектор, где обработка данных в реальном времени имеет решающее значение для торговых решений и улучшает кибербезопасность, чтобы предотвратить попадание данных в чужие руки.

Сегодня разработчики в основном используют крупные языковые модели (LLMS) для разработки приложений Genai для их очевидных преимуществ. Но размер и сложность LLM делают их сложными для ограниченных ресурсов. SLM обучаются литературе для конкретного конкретного случая, и они могут принимать решения в реальном времени быстрее и эффективнее, чем LLMS.

Как глава новых технологий, моя команда и я несколько раз тестировали SLMS. В этой статье рассматриваются некоторые проблемы и потенциальные стратегии использования SLM в рамках экологических вычислительных систем.

Замена LLM на SLM для применений краев

Переключение на SLMS предлагает значительные преимущества в секторе здравоохранения, где распространено использование персональных устройств. Из -за ограничений производительности персональным устройствам часто не хватает ресурсов, необходимых для эффективного запуска LLMS. Поскольку SLMS являются конкретными для случая, они предоставляют идеальное решение для решения этих ограничений.

Преобразование LLM в SLMS легко с такими методами, как дистилляция модели, обрезка параметров и квантование. Модель дистилляции включает в себя обучение гораздо меньшей модели для эмуляции более крупной, сохраняя большую часть производительности оригинальной модели. Обрезка параметров устраняет ненужные веса и соединения в модели, чтобы упростить ее архитектуру без точки, не жертвуя точностью. Квантование сжимает модель, снижая точность численного представления весов, что приводит к меньшему следу и более быстрому времени вывода.

Теперь давайте повторно рассмотрим пример больницы. Различные наборы пациентов могут потребовать постоянного мониторинга и немедленного действия с заболеваниями и расстройствами, касающимися неврологии, нефрологии, сердечно -сосудистых, аутоиммунных, инфекционных заболеваний или даже несчастных случаев. SLM могут быть обучены отдельно для этих заболеваний. Они могут проанализировать данные этих пациентов в режиме реального времени и либо инициировать необходимое лечение, либо предупредить медицинских работников о том, чтобы они со временем приняли меры.

В зависимости от их потребностей, разработчики могут создавать SLMS либо с нуля, либо использовать предварительно обученные модели в качестве основополагающих инструментов для своих проектов и ускорять процесс разработки. Открытые рыночные площадки, такие как модели GitHub и обнимающееся лицо, имеют предварительно обученные SLM. Эти инструменты также способствуют более широкому внедрению генеративного ИИ на краю. Контекстуальные возможности SLM могут преобразовать несколько отраслей. В интеллектуальных городах SLM могут создавать лучшие устройства IoT с поддержкой краев, чтобы обеспечить контекстно-чувствительные направления, адаптированные к таким условиям, как заторы или закрытие дорог. Эта комбинация может повысить эффективность, минимизировать задержки и улучшить общий опыт городской мобильности.

Обработка требований разнообразия платформ и ресурсов

Гетерогенность платформы среди устройств Edge может сделать развертывание SLMS сложными. Личные устройства мониторинга могут работать на нескольких платформах, таких как iOS и Android. Тем не менее, стеки и структуры, такие как Exchange Open Neural Network (ONNX), MediaPipe, Wasi-NN, Rust и Webassembly, могут помочь создать экосистему для приложений, потребляющих SLM. Они поддерживают разнообразные аппаратные и операционные системы и обеспечивают кроссплатформенную поддержку и оптимизированные ресурсы приложения.

Такие фреймворки, как время выполнения открытых нейронных сети (ONNX), предоставляют уровень абстракции, который упрощает поддержку SLM на нескольких платформах для смягчения этой проблемы. Разработчики могут оптимизировать модели для определенных целей аппаратного обеспечения, используя инструментальные наборы ONNX, чтобы обеспечить эффективную производительность независимо от базовой архитектуры устройства. MediaPipe Framework упростила мигрирующие SLM на легкие устройства края, включая мобильные платформы. Его модульная структура и эффективные аппаратные ускорители позволяют предопределить преоптимизированные кроссплатформенные решения и оптимизировать развертывание сложных моделей ИИ в средах с ограниченными ресурсами.

Кроме того, WebAssembly может использовать базовые аппаратные возможности, включая графические процессоры, для оптимизации производительности и ускорения задач вывода. Он идеально подходит для приложений SLM, так как сочетает в себе легкое выполнение с мощными вычислительными ресурсами. Это также способствует инициативам по устойчивому развитию, поддерживая разработку надежных решений искусственного интеллекта на краевых устройствах с более низким энергопотреблением и генерацией тепла. WASI-NN предоставляет API-интерфейсы вывода машинного обучения для Webassembly. Это обеспечивает разработку многоже всего к веб -приложениям, которые используют возможности SLM.

Язык программирования ржавчины дополнительно улучшает эту экосистему. В отличие от стека Python, используемого в средах ML, Rust позволяет запустить приложения как компактные как 30 МБ, что позволяет легким, высокопроизводительным приложениям, подходящим для ограниченных ресурсов.

Совместное обучение на грани с расширенной безопасностью

Здравоохранение и многие другие домены работают в условиях конфиденциальности. Тем не менее, контролируемое обмен данными с приложениями Edge может помочь создать базу знаний для улучшения процедур лечения с использованием SLMS и других медицинских услуг. Такие методы, как федеративное обучение, могут обеспечить обучение и точную настройку SLM на нескольких устройствах при таких обстоятельствах. Поддержание конфиденциальности и безопасности данных является более простым с федеративным обучением. Этот подход помогает модели учиться на локализованных данных без обмена конфиденциальной информацией.

Давайте на мгновение вернемся в больницу. Больница решила присоединиться к программе совместной работы с другими больницами, направленной на создание более сложной модели для улучшения прогнозов и результатов ухода на основе понимания различных медицинских карт. Но есть улов: больницы не могут обнародовать документы, потому что правила назначают пациентов в качестве владельцев своих данных.

Именно здесь федеративное обучение в сочетании с SLM может изменить игру. Каждая больница может обучить свою SLM, используя свои записи пациентов. Затем он может загружать только изученные параметры в общую базу данных, принося пользу всем участникам при сохранении конфиденциальности. Затем сервер создает глобальную модель на основе полученных обновлений без доступа к отдельным файлам.

Тот же принцип применим ко всем случаям, связанным с конфиденциальными данными. Например, в инвестиционном секторе, где данные клиента требуют строгой безопасности, понимание общих параметров по моделям инвестиций может помочь банковскому сектору разработать более эффективные планы. Федеративное обучение облегчает сотрудничество между участниками, будь то отдельные лица, устройства или организации. Он улучшает модели, предоставляя данные без ущерба для конфиденциальности данных. Технология также обеспечивает соответствие правилам конфиденциальности.

Разработчики могут использовать проекты с открытым исходным кодом для федеративного обучения, такие как Flower, Substra, NVFlare и т. Д.

Заключение

Малые языковые модели (SLM) предлагают отличный баланс эффективности, конфиденциальности и адаптивности, что делает их идеальными для различных приложений. В области здравоохранения быстрый диагноз симптомов на грани также может быть дифференцирующим фактором для телемедицины, возникающего здравоохранения.

Такие отрасли, как промышленная IoT, Defense и Fintech, могут использовать SLM для аналитики в реальном времени, повышенной безопасности и индивидуальных решений. Эти отрасли могут еще больше выиграть от их адаптивности к многоязычным и мультимодальным входам. Например, индустрия Fintech может использовать SLMS для многоязычной поддержки клиентов и локализованных моделей для различных наборов данных. Поскольку SLM развернуты локально, они являются более безопасными и объяснимыми, что обеспечивает прозрачность в доменах, где соблюдение нормативных требований является приоритетом.

Zededa позволяет клиентам беспрепятственно управлять инфраструктурой Edge Computing, обеспечивая видимость, безопасность и масштабируемость в этих средах и поддерживает такие варианты использования, как компьютерное зрение, консолидация рабочей нагрузки, контекстуализация данных IIOT и прогнозирующее обслуживание, все в производстве сегодня. Узнайте больше последних из Zededa Trending Stories YouTube.com/ThenewStack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Панкадж Мендки является руководителем новых технологий в Talentica Software. Панкадж-выпускник ИИТ Бомбея и исследователь, который исследует и быстро отслеживает принятие развивающихся технологий для ранних и стадий роста стартапов. Он опубликовал и представил несколько … Подробнее от Pankaj Mendki