На этой неделе, некоммерческая исследовательская лаборатория AI, некоммерческая исследовательская лаборатория AI Startup Cohere, выпустила мультимодальную «открытую» модель ИИ, Aya Vision, Lab утверждает, что является лучшим в своем классе.

Aya Vision может выполнять такие задачи, как написание подписей изображений, ответа на вопросы о фотографиях, перевод текста и генерирование резюме на 23 основных языках. Cohere, который также делает Aya Vision доступным бесплатно через WhatsApp, назвал его «значительным шагом к тому, чтобы сделать технические прорывы доступными для исследователей по всему миру».

«Несмотря на то, что ИИ добился значительного прогресса, все еще существует большой разрыв в том, как хорошо работают модели на разных языках — тот, который становится еще более заметным в мультимодальных задачах, которые включают в себя как текст, так и изображения», — написал Коудер в посте в блоге. «Aya Vision стремится явно помочь закрыть этот разрыв».

Aya Vision происходит в паре вкусов: Aya Vision 32B и Aya Vision 8b. Более сложный из двух, Aya Vision 32B, устанавливает «новую границу», сказал Коухер, опережая модели 2x его размер, включая Meta Llama-3.2 90b Vision на определенных ориентировочных показателях. Между тем, Aya Vision 8B набирает лучшие оценки по некоторым оценкам, чем модели 10x его размер, согласно Cohere.

Обе модели доступны в платформе AI Dev, обнимающего лицо по лицензии Creative Commons 4.0 с приемлемым дополнением COHERE. Они не могут быть использованы для коммерческих приложений.

Cohere сказал, что Aya Vision обучалась с использованием «разнообразного пула» английских наборов данных, которые лаборатория переводила и использовала для создания синтетических аннотаций. Аннотации, также известные как теги или метки, помогают моделям понять и интерпретировать данные во время учебного процесса. Например, аннотация для обучения модели распознавания изображений может принять форму маркировки вокруг объектов или подписей, относящихся к каждому человеку, месту или объекту, изображенному на изображении.

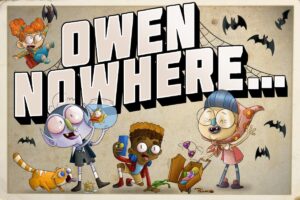

Модель Aya Vision от Cohere может выполнять целый ряд задач визуального понимания.Кредиты изображения:Кожух

Использование COHERE синтетических аннотаций, то есть аннотаций, генерируемых ИИ, является тенденцией. Несмотря на свои потенциальные недостатки, соперники, включая OpenaI, все чаще используют синтетические данные для обучения моделей, поскольку скважины реальных данных иссякают. Исследовательская фирма Gartner оценивает, что 60% данных, используемых для проектов по ИИ и аналитики в прошлом году, были синтетически созданы.

Согласно Cohuer, обучение Aya Vision по синтетическим аннотациям позволило лаборатории использовать меньше ресурсов при достижении конкурентной работы.

«Это демонстрирует наше критическое внимание к эффективности и [doing] Больше, используя меньше вычислительных веществ », — написал Кохер в своем блоге. «Это также обеспечивает большую поддержку исследовательского сообщества, которое часто имеет более ограниченный доступ к вычислению ресурсов».

Вместе с Aya Vision, Cohere также выпустила новый набор Clackmark, AyavisionBench, предназначенный для исследования навыков модели в «зрительном языке», таких как определение различий между двумя изображениями и преобразование скриншотов в код.

Индустрия искусственного интеллекта находится в разгар того, что некоторые называют «кризисом оценки», следствием популяризации критериев, которые дают совокупные оценки, которые плохо коррелируют с мастерством в задачах, о которых заботятся большинство пользователей ИИ. Cohere утверждает, что AyavisionBench является шагом к исправлению этого, обеспечивая «широкую и сложную» структуру для оценки межъязычного и мультимодального понимания модели.

Если повезет, это действительно так.

«[T]Набор данных он служит надежным эталоном для оценки моделей языка зрений в многоязычных и реальных условиях »,-написали исследователи Cohere в посте об обнимании лица. «Мы предоставляем этот набор оценки доступным для исследовательского сообщества, чтобы продвигать многоязычные мультимодальные оценки».