То, как все движется, каждый инженер -программист скоро станет нативным разработчиком ИИ. Нет, это не значит, что ИИ будет встроен в ваш мозг. Также это не означает, что вам придется работать с ИИ на протяжении всей своей карьеры в технологиях.

«Девелопер из ИИ» является еще более неправильным, потому что он не зависит от человека, и это не обязательно связано с созданием приложений, концепций, концепций, алгоритмов или моделей.

ИИ в этом случае вместо этого встроен во всем жизненном цикле разработки программного обеспечения (SLDC), посредством дополнений AI, которые работают в конкретных целях, так что разработчики могут сосредоточиться на предоставлении дифференциальной ценности. «Cloud Native AI», вероятно, лучший термин. В любом случае, генеративный ИИ с естественным языком будет продолжать быть активным программистом пар.

Но как вы максимально используете свои команды разработчиков программного обеспечения для нативных программных программ сейчас или вскоре? Как вы стратегически интегрируете ИИ в SLDC? Как вы делаете все это надежно?

Рост развития спецификации ИИ

В настоящее время основное внимание разработке программного обеспечения уделяется подготовимости ИИ в куски существующего рабочего процесса разработчика, ищет возможности для автоматизации. Но не все думают, что это разумный путь вперед.

«Истинный потенциал — вы действительно переосмысливаете рабочий процесс», — сказал Гай Поджарни, основатель Snyk и теперь Tessl, в разговоре в штате Open Con, Лондон. «В появлении этой мощной технологии, как я могу переосмыслить разработку программного обеспечения? Мы считаем, что разработка программного обеспечения будет переходить от кода, ориентируясь на спецификацию ».

«Мы считаем, что разработка программного обеспечения будет переходить от кода, ориентированного на код к спецификации».

— Гай Поджарни, основатель Tessl

Этот новый подход выглядит для того, чтобы встроить ограждения в вашей спецификации или спецификации, которые могут по умолчанию более безопасного, более высокого качественного кода, сгенерированного AI. Deviliend Development, AKA, управляемое поведением, Development 2.0, выполняет три шага:

По расширению, Devilience Development разворачивает дизайнерские ограждения вокруг того, что делает приложение AI.

Как и все спецификационные разработки, это позволяет:

- Улучшенная последовательность и управление.

- Более раннее подтверждение, что то, что строится, — это то, что должно быть построено.

- Сотрудничество и общение между техническими и бизнес -заинтересованными сторонами на естественном языке.

Эта последняя выгода особенно важна, поскольку сгенерированный AI код часто не связан с объясняемостью того, какие решения приняли крупные языковые модели (LLM) и почему.

То, что дает нативное значение ИИ, заключается в том, чтобы ИИ создавал то, что вы на самом деле хотите, что затем может быть уточнено в этом новом единственном источнике истины — вашей спецификации. В отличие от статус -кво, когда ваш единственный источник истины — ваш код.

«Сегодняшняя разработка программного обеспечения очень ориентирована на код. Вы получаете некоторые требования, вы пишете какой -то код, вы принимаете 100 решений, которые никогда не возвращаются, никогда не выбираете его в систему », — сказал Поджарни. Иногда создаются тесты и документы, но редко они тщательны-при этом они не остаются в курсе.

Единственный актив, который действительно выдерживает испытание временем, продолжил он, — это код.

«Год спустя удачи, пытаясь найти следы требований и определения исправлений и усовершенствований, в котором говорится: что было за вопрос? Что должно делать приложение? »

Но тогда, даже если вы не изменяете свой код, он меняется, потому что изменяются зависимости, реализации, среды и/или интеграции. Это связано с тем, что, как сказал Поджарни, «ваш код живет в динамичной среде», что «даже если вы не участвуете в приложении, вы несете риск разрушения», что, опять же, нигде не захвачено.

«И поэтому приложение становится хрупким», — добавил он.

Спецификация содержит определение того, что должно делать ваше приложение, с тестами, которые подтверждают, что сгенерированный AI код является правильным и соответствует спецификации.

Когда ИИ вовлечен, команды разработки программного обеспечения дальше от того, почему, как и что из кода. Как всегда, страх прикоснуться к коду увеличивается вместе с его возрастом.

Согласно утверждает, что благодаря разработке Спецификации ИИ вы «принимаете эти требования и отвлекаете их от того, что является одноразовым-которое появилось с самого начала и исчез-к тому, что находится в центре и долгоживущем».

Спецификация содержит определение того, что должно делать ваше приложение, с тестами, которые подтверждают, что сгенерированный AI код является правильным и соответствует спецификации. Этот код становится все более неизменным и одноразовым.

Но это всего лишь один шаг на пути к тому, чтобы стать группой разработчиков, занимающихся искусственным искусством.

Случай для запуска собственных LLMS с открытым исходным кодом

От теневого ИИ до менее чем половины компаний, даже имеющих политику управления ИИ, большинство Кодекса, создаваемого ИИ, создается и выпускается без каких-либо границ или руководящих принципов. Часто даже без тестов или людей в цикле.

Даже без всего этого заблокированного, 42% организаций рассматривают возможность разработки своих собственных собственных моделей крупных языков. Мы можем предположить, что очень немногие из этих предприятий на самом деле являются компаниями ИИ, поэтому это может сосредоточиться на недифференциальной, но дорогой, работающей.

«Как мы можем встать на наш собственный внутренний CHATGPT, который, как мы знаем, можем доверять? Чтобы остановить людей, делающих тень, потому что тогда, вместо того, чтобы пробираться на своем телефоне, они могут использовать внутреннюю версию », — сказал Люк Марсден, генеральный директор Helixml, сказал, что многие компании рассматривают.

Тем не менее, он утверждает, что решение не входит в проприетарные предложения, такие как Chatgpt или Gemini, когда LLM с открытым исходным кодом, такие как DeepSeek, становятся претендентами с точки зрения скорости и качества.

«Если вы думаете о Linux против Windows, Open Source выиграл на сервере. Почему это не повториться для этой новой волны ИИ? »

— Люк Марсден, генеральный директор Helixml

«Если вы подумаете о Linux против Windows, Open Source выиграл на сервере», — сказал Марсден. «Почему это не повторится снова для этой новой волны ИИ?»

Помимо того факта, что вам не нужно обучать частные крупные языковые модели самых богатых компаний в мире, есть и другие убедительные причины для размещения собственных версий LLM с открытым исходным кодом. Это включает в себя риск того, что вы могли бы поместить чужой собственный код в свой продукт или рискуя собственным авторским правом, потому что вы обучили публичный LLM в секретах своей компании.

Однако на переднем мнении для большинства технических лидерства находится риск безопасности LLM. По всем направлениям, до сих пор код, сгенерированный AI, более гораздо, чем то, что написано исключительно разработчиками, и быстрое инъекция является еще одним очень присутствующим риском безопасности ИИ.

«Любая компания или организация, которая имеет важные или ценные секреты, захотят убедиться, что они заблокировали использование этой технологии», — сказал Марсден. Но, «в то же время, на них находится давление, чтобы вводить новшества».

Часто существует необоснованное недоверие, что программное обеспечение с открытым исходным кодом и модели ИИ по своей природе менее безопасны, чем их проприетарные аналоги. Независимо от того, разделяет ли ваша организация в этом страхе, или вы просто хотите избежать блокировки и стоимости поставщиков, Марсден выступает за использование LLM с открытым исходным кодом на местном уровне в пределах брандмауэра.

«Там [are] Многие организации, которые, по нормативным причинам, не могут отправить свои данные крупному облачному поставщику и используют свою собственную инфраструктуру. Есть тенденция к работе на частных облаках, репатриируя их данные », — сказал он.

«Тот факт, что все локально, по своей природе безопаснее, потому что вы не отправляете данные в какую -то ненадежную третью сторону».

Это был вариант, который не был доступен в прошлом году во время кризиса нехватки графических процессоров; Но теперь, сказал Марсден, цена на графические процессоры снизилась, и они снова стали широко доступными.

Еще одна большая победа с нативным приложением для ИИ с открытым исходным кодом заключается в том, что оно позволяет интегрировать его в ваши DevOps и программные рабочие процессы.

Он утверждал, что еще дольше эти модели рассуждений с открытым исходным кодом — как дольше эти модели рассуждений с открытым исходным кодом — такие как DeepSeek — Run, тем лучше получаются ответы. Это возвращается к этой тенденции организаций, возвращающихся к запуску на собственном оборудовании, потому что чем дольше вы оставляете модель, работающую в облаке, тем больше затрат на облака растут.

Еще одна большая победа в создании нативного приложения ИИ с открытым исходным кодом заключается в том, что оно позволяет интегрировать его в ваши DevOps и программные рабочие процессы. По словам Марсден, это позволяет командам задавать вопросы, очень специфичные для их организаций. Он дал пару примеров:

- Что в нынешнем спринте?

- Можете ли вы помочь мне написать код для проблемы, который мне был назначен?

«У вас может быть 10 разных случаев, в которых вы хотите, чтобы этот помощник JIRA хорошо поработал. Что вы можете сделать, так это написать эти случаи в качестве тестов », — сказал он. Подобно тому, как вы пишете тесты для программного обеспечения, которое вы создали, но для приложений Genai, а затем «эти тесты используют спецификацию естественного языка для правильных ответов».

Затем, Марсден продолжил, вы можете применить схему LLM-AS-a-gudge в качестве метода оценки для оценки качества этих ответов-не только по общим стандартам, но и в контексте организации и ее управления. И у вас все еще есть возможность, чтобы человек в петле, чтобы проверить, является ли тест хорошим, прежде чем интегрировать эту возможность тестирования в существующий рабочий процесс CI/CD, чтобы тест работал каждый раз.

Снижение быстрой инженерии

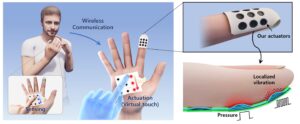

В последних двух годах наблюдался огромный спрос на роль быстрого инженера человека в петле, которая записывает конкретные, основанные на контексте примеры и инструкции, чтобы помочь направлять модели ИИ производить более качественные, более конкретные ответы. Эта тенденция может не продолжаться до 2025 года.

Обратная техника, в сочетании с отзывами от экспертов и клиентов темы, вероятно, будет вещью в течение следующего года или двух — чат -ботов обслуживания клиентов, особенно, похоже, еще предстоит пройти долгий путь.

Тем не менее, в промежуточном пике для технологического радара следующего мышления, существует удивительная тенденция к снижению быстрой инженерии — возможно, потому, что мы уже слишком много говорим с ботами?

«Это на самом деле произошло из-за роста моделей рассуждений, таких как Deepseek-R1 и некоторые вещи от Openai, где, если вы на самом деле вложите слишком много в подсказку, это может фактически снизить полезность ответа»,-сказал Майк Мейсон, главный сотрудник ИИ в «Мыслил».

«Это может изменить способ, которым мы делаем оперативную технику».

— Майк Мейсон, главный сотрудник ИИ в ThyingWorks

Мейсон сказал, что Сэм Альтман, генеральный директор Openai, «дразнил», что CHATGPT-5 будет слияние модельных стилей, которые могли бы сделать это количество рассуждений за почти.

«Это может изменить способ, которым мы делаем оперативную технику», — сказал Мейсон, или вскоре даже устранить весь спрос на роль.

Что также может повлиять на это изменение, так это рост разработки программного обеспечения для нативного ИИ. Несмотря на то, что, вероятно, все еще будут разговоры о естественном языке с документацией и кодовыми базами, большая часть подсказки будет автоматически выполнена в фоновом режиме, инициируя частоту действий, которые предписаны промышленностью и организацией.

По мере того, как эти технические роли в разработке программного обеспечения для искусственного интеллекта изменяются, одно можно сказать наверняка: мы не избавляемся от человеческого разработчика в ближайшее время.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Дженнифер Риггинс — культурная сторона технического рассказчика, журналиста, писателя и ведущего событий и подкастов, помогающих поделиться историями, где сталкиваются культура и технологии и перевести влияние технологий, которую мы строим. Она была … читайте больше от Дженнифер Риггинс