Этот пост является письменным глубоким прохождением разговора, который я выступил на Ярмарке World Ingener Engineer 2025 года в Сан-Франциско. Основываясь на моем опыте доставки программного обеспечения и агентов в качестве соучредителя Dagger и первого сотрудника в Docker.

По мере того, как LLMS генерирует все больше кода — от более интеллектуального автозаполнения до полностью автономных кодирующих агентов — стоимость написания кода падает. Затем давление переходит к конвейеру доставки, потому что каждая новая линия все равно должна очистить тестовый набор и обзор кода на пути к производству.

автоматизация с доставкой программного обеспечения всегда была узким местом-именно поэтому мы запустили кинжал-но узкое место подтягивается теперь, когда кто-то может изготовить большие объемы приличного кода.

В апреле 2025 года мы добавили нативные звонки LLM в кинжальные рабочие процессы. Теперь команды могут делегировать когнитивно тяжелые задачи в LLMS: упространение DockerFile для безопасности и эффективности, диагностируя ошибки CI и предлагая исправления (или непосредственно открытие PR), даже поднимая открытую проблему. Мы поделились конкретными примерами в нашей документации.

Давайте рассмотрим ловушки, которые большинство команд достигли, когда они внедряют LLMS — и как их избежать. Уроки поступают от автоматизации с доставкой программного обеспечения, но применяются более широко.

Большинство людей начинают с экспериментов с флагманскими моделями (GPT-4O, Claude 4, Gemini 2.5…). Эти модели прощают неаккуратные подсказки, поэтому ранние результаты дают «вау» момент и создают уверенность в том, что многоагентные рабочие процессы могут выполнять сложные задачи.

Реальность наступает с надежностью. Когда модель сдает плохой код или запускает неправильный инструмент, даже 1-в-10 запускается, доверие рушится. Вы не можете ввести этот уровень дисперсии в код, который отправляет ваш продукт.

Мы перегоняли четыре принципа в кинжале, которые сохраняют агентские рабочие процессы достоверными в производстве.

Агенты с применением AI до небольших, четко определенных задач

Большие модели делают его заманчивым, чтобы разоблачить, открытые цели вручную. Не. Совместите мандат каждого агента до минимума и компенсируйте узкую область с помощью длинной, явной подсказки, которая излагает каждое ограничение.

Противостоятельно, чем меньше задача, тем дольше подсказка. Этот дополнительный контекст дает модельные ограждения — и сами модели эффективны, помогая вам уточнить подсказку.

Думайте о LLM как о мозге и инструментах как о руках и ногах. Добавление инструментов чувствует себя расширяющим возможности, но каждый из них увеличивает контекстное окно и вероятность случайного поведения. Меньше инструментов → меньше контекста, более низкие затраты, более детерминированные прогоны.

Я часто понимаю, что помощники, которые я планировал разоблачить, так как инструменты дешевле вызывать за пределами цикла агента. Пример: в нашем оптимизаторе DockerFile функция, которая подсчитывает слои изображений и общий размер запуска до запуска агента; Мы подаем его выход в подсказку вместо того, чтобы позволить агенту вызвать его.

Нужен больший рабочий процесс? Цепные микроагенты. Легкий «агент сортировки» получает запрос и делегаты на специализированные суб-агенты, каждый с тонким масштабом и набором инструментов.

Агенты OpenAI SDK иллюстрируют эти закономерности.

Дайте каждому агенту AI повторяющуюся песочницу

Агенты, такие как человеческие разработчики, должны никогда Прикосновение привилегированных сред. Им нужно изолированное, воспроизводимое рабочее пространство — безопасное, одноразовое и с прямым управлением государством в и выходе.

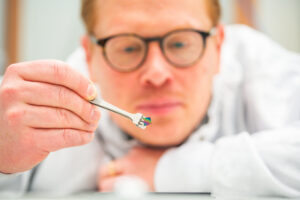

Поскольку ничего на рынке не соответствовало этим требованиям, мы построили контейнерное использованиеПолем Заработав в качестве сервера MCP, он разворачивает контейнерную среду разработки для любого агента кодирования — Claude Code, Openai Opex, Cursor, Goose — или для агентских рабочих процессов, которые вы создаете.

Работаете с несколькими агентами одновременно? Каждый получает свою собственную песочницу, поэтому вы можете свободно экспериментировать, не загрязняя местные ветви GIT. Песочница представляет собой полный стек контейнеров: агент может запускать команды оболочки внутри, и вы можете упасть в терминал в любой точке, чтобы осмотреть изменения или команды воспроизведения.

Доверие требует полной наблюдаемости

Прозрачность порождает доверие; Агенты не являются исключением.

В большинстве приложений наблюдаемость на уровне функций-это «приятный», который задерживается на дорожной карте. С агентскими рабочими процессами это становится обязательным. LLM ⇄ Tool Loop — это черный ящик, и отладка требует ответов на: какой инструмент был вызван? С какими аргументами? В каком порядке? Каким было государство песочницы на шаге N?

Проще говоря, вы не можете полагаться на умных агентов без видимости в их работе.

Основные поставщики моделей выставляют следы (например, следов Openai), но не прижимают к олицетворяемому стеку «наблюдаемость AI»-сделайте вашу существующую платформу AI-AWARE. Вот почему мы включили полный контекст LLM (системы/пользовательские сообщения, инструменты) в Кинчжал облако: Вы можете проследить весь трубопровод доставки, управляемый LLM или нет.

Та же философия относится к контейнерное использование: Каждый сеанс песочницы полностью инструментация, поэтому поведение агента никогда не является непрозрачным.

Агент AI -агента живет или умирает Evals

Из всех четырех принципов, это наиболее важно: чтобы оценить быстрое качество, показатели успеха агента, эффективность инструмента и производительность модели, вы должны инвестировать в начале Эвал — Коротко для оценки моделей. Думайте о Evals как CI для агентов.

Модели развиваются быстро. Даже «идеальный» рабочий процесс дрейфует, если вы не измеряете его непрерывно. Запустить Evall, когда:

- Изменяется код рабочего процесса,

- Вы обновляете или поменяете модель,

- Вы настраиваете подсказку,

- Вы изменяете инструмент.

Частые пробеги разоблачают экономическую правду: большие, способные модели также медленные и дорогие. С метриками в руке вы часто переключаете к более мелким моделям, которые, хотя и менее мощные, дешевле и (с правильной подсказкой) более эффективны. Компромисс? Эти подсказки становятся длиннее и более тщательными — полезная функция принуждения для ясности.

Как нравится Алекс в команде Dagger: Независимо от модели или рамки, вы не можете опередить быстрого инженера. Раннее автоматизированные эвалы мешают вам разорвать все, когда крупные расходы-или их причуды-ударили по стене.

В заключение, агентские рабочие процессы разблокируют замечательную скорость и масштаб, но только если они бегут внутри плотных областей, чистых песочниц, прозрачных следов и неустанных эвалей. Следуйте этим четырем ограждениям, и вы станете привлекательными демонстрациями в трубопроводы, на которые вы можете сделать производство-сегодня и в качестве моделей продолжают участвовать в гонках.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Сэм Альба в настоящее время является соучредителем и вице-президентом по технике инженерии в Dagger и является бывшим вице-президентом по технике инженерии Docker. Он присоединился к Docker в качестве первого сотрудника в 2010 году. Он возглавил инженерную группу, увеличив ее от трех … Подробнее от Sam Alba