РЭЛИ, Северная Каролина — Натан Фултон вспоминает момент, когда он осознал, что у искусственного интеллекта с открытым исходным кодом есть проблемы с инфраструктурой.

Старшие инженеры продолжали задавать ему один и тот же вопрос: когда модели искусственного интеллекта IBM будут поддерживать структурированные выходные данные? Функция, которая позволяет разработчикам контролировать форматирование ответов языковыми моделями, только что была добавлена в API OpenAI, и внезапно она захотела всех.

Фултон, исследователь и технический менеджер лаборатории искусственного интеллекта MIT-IBM компании IBM Research в Кембридже, штат Массачусетс, был сбит с толку, рассказал он The New Stack. Такая возможность существовала в библиотеках с открытым исходным кодом с 2021 года. И модели IBM поддерживали ее с самого начала.

«Вы могли делать это в течение многих лет», — сказал он. «Но его добавляют в конечную точку API, и внезапно они думают, что OpenAI — единственный, кто может это сделать».

Этот разрыв между тем, что может сделать ИИ с открытым исходным кодом, и тем, что люди думали, что он может сделать, и привел к созданию Mellea, новой библиотеки с открытым исходным кодом от IBM Research, которая пытается уравнять правила игры, о которых большинство людей даже не подозревали.

Фултон поговорил с The New Stack в зале IBM Generative Computing на мероприятии All Things Open 2025, состоявшемся на прошлой неделе здесь.

Нечестный бой

Проблема, как понял Фултон, заключалась вовсе не в качестве модели ИИ.

Когда компании оценивают платформы искусственного интеллекта, они не сравнивают яблоки с яблоками. Они сравнивают законченные, отточенные платформы OpenAI или Anthropic — модели плюс инфраструктуру проприетарного программного обеспечения — с моделями с открытым исходным кодом, которые, по сути, являются просто сырыми весами.

«Что они делают, так это набирают вес нашей сырой модели — они вставляют токены и извлекают их, а затем сравнивают это с огромным, сложным программным стеком, который был разработан вместе с моделями», — объяснил Фултон.

Это все равно, что сравнивать автомобильный двигатель, стоящий на полу гаража, с полностью собранным автомобилем и делать вывод, что двигатель работает не так хорошо, отметил он.

«Часто открытые модели фактически оказываются лучше», — сказал Фултон. «Но у нас нет стандартного программного обеспечения для этих моделей».

Разрыв стало невозможно игнорировать с помощью моделей рассуждения, которые представляют собой системы искусственного интеллекта, которые показывают свою работу и исправляются. Каждая реализация с открытым исходным кодом перестраивала одни и те же сложные алгоритмы вывода с нуля.

«После фиаско структурированных результатов в 2024 году я подумал: «О, нам нужно решение с открытым исходным кодом для того, чтобы иметь этот стек вывода, иначе открытые модели никогда не смогут конкурировать с этими вертикально интегрированными закрытыми поставщиками».

Когда подсказки идут не так

Другая проблема, которую увидел Фултон, была более близка ему, когда он наблюдал, как разработчики на самом деле используют ИИ в производстве.

Он называет это «антропологией программного обеспечения». Картина постоянно повторяется. Разработчик пишет подсказку. Добавляет некоторые инструменты. Оно работает. Вроде того. Затем начинают поступать запросы на функции.

«Поскольку все приложение на самом деле представляет собой просто подсказку, некоторые инструменты и немного программного обеспечения вокруг этого, некуда — если вы хотите добавить функцию, основное место, где вы это делаете, — в подсказке».

Поэтому разработчики продолжают добавлять к приглашению. Появляется ошибка. Они обновляют подсказку. Ошибка сохраняется. Они обновляют его снова, более решительно.

«Вы возвращаетесь и говорите заглавными буквами: «ПОЖАЛУЙСТА, НЕ ДЕЛАЙТЕ БАГГИ», верно?»

Фултон рассмеялся, но это настоящая проблема. «Во-первых, люди часто помещают в свои подсказки слишком много информации».

Абсурд заключается в том, что многое из того, что втиснуто в эти постоянно растущие запросы, может быть обработано традиционным программным обеспечением. «Многое из того, что они делают в командной строке, можно сделать с помощью старого доброго программного обеспечения. Им не нужно, чтобы все делал LLM. [large language model]».

Но разработчики попадают в ловушку оперативного мышления, «передавая все на аутсорсинг этой статистической модели, которая иногда работает, а иногда терпит неудачу и дает сбой непредсказуемым образом».

Разрушение вещей

Решение Меллеа почти радикально простое: перестаньте делать все в одной гигантской подсказке, сказал Фултон.

«По сути, делайте что-то одно за раз — разлагайте на нужное количество вещей, которые будут происходить на каждом отдельном этапе», — сказал он. После каждого шага «очень тщательно подумайте о том, что должно быть истинным после того, как вы сделаете этот шаг, и закодируйте это как постусловия. А затем обеспечьте выполнение этих постусловий».

Это программная инженерия 101 применительно к ИИ. Фреймворк «подталкивает разработчиков в правильном направлении с точки зрения того, как им следует думать о программировании с помощью LLM. Не бросайте все в подсказку».

Внутри IBM команды уже видят результаты. Несколько групп повторно реализовали своих агентов искусственного интеллекта с использованием Mellea и «получили очень положительный опыт получения действительно значительного прироста производительности по интересующим их критериям», — сказал Фултон.

Изменения зачастую минимальны. «Просто взять существующие гигантские подсказки и сказать: «В этой подсказке шесть шагов. Что, если мы выполним каждый из этих шести шагов по отдельности? В конце этой подсказки перечислены 15 требований. Что, если мы вырежем каждое из них и проверим их по отдельности?»

Проблема главного инженера

Самая сильная реакция на Mellea пришла не со стороны исследователей или младших разработчиков. По словам Фултона, это исходило от главных инженеров — людей, которые имеют представление о нескольких проектах в своих организациях.

«Самая сильная реакция, которую мы получаем, исходит от того покойного старшего, ставшего главным инженером, который говорит: «Да, нам явно нужно отойти от структуры агентов», — сказал он.

Эти инженеры наблюдали, как их команды пробовали LangChain, DSPy и другие платформы. Они видели, как они терпели неудачу. Они видели, как команды возвращались к написанию собственного кода для каждого проекта.

И они кое-что заметили: каждый проект переписывает одни и те же шаблоны. Отбраковочная выборка. Проверка требований. Циклы проверки. По словам Фултона, команды «просто переписывают этот код для каждого отдельного проекта, поскольку не существует общей библиотеки» для этих стандартных шаблонов.

Вот где подходит Меллеа. Не как новый революционный подход, а как уровень общей инфраструктуры, который должен был существовать всегда.

Инженерия, а не наука

Фултон обезоруживающе честен в отношении того, чем является Меллеа, а чем нет.

Когда он представляет исследовательскому сообществу, они спрашивают: «Что здесь нового?»

«Это справедливая реакция», — говорит он. «Мы делаем новые вещи. Но основные вещи, которые я только что вам описал, не являются глубокими исследовательскими проблемами».

Он делает паузу. «По большей части мы решаем инженерные и координационные проблемы — социальные и инженерные проблемы, а не фундаментальные научные проблемы».

Это не та работа, которую публикуют в NeurIPS. Но это может быть важнее, чем многое из того, что происходит, сказал Фултон.

После трех месяцев проектной работы — прототипирования высокоуровневых абстракций и низкоуровневых реализаций с коллегой с февраля по май — команда Фултона создала реальную библиотеку примерно за шесть недель. Они открыли его в июле 2024 года.

Генеративные вычисления

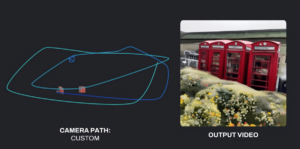

Mellea является частью более широкой концепции IBM Research, которую они называют «генеративными вычислениями», которая рассматривает языковые модели не как волшебные черные ящики, а как вычислительные элементы, требующие соответствующей программной инфраструктуры.

Проект возглавляет Дэвид Кокс, вице-президент по моделям искусственного интеллекта в IBM Research, который утверждает, что вычисления прошли через отдельные фазы: императивные вычисления (явные инструкции), индуктивные вычисления (обучение на примерах) и теперь генеративные вычисления.

«Мы считаем, что генеративные вычисления требуют новых моделей программирования для использования LLM, новых фундаментальных низкоуровневых операций, выполняемых LLM, и новых способов построения самих LLM», — написал Кокс в своем блоге.

Философия проста: «Весь потенциал генеративного ИИ [GenAI] будет реализовано путем плавного объединения искусственного интеллекта с традиционным программным обеспечением».

Чтобы искусственный интеллект с открытым исходным кодом мог конкурировать с такими платформами, как ChatGPT и Claude, ему нужны нечто большее, чем просто мощные модели. Ему нужна окружающая инфраструктура — абстракции времени выполнения, шаблоны проектирования, инструменты разработчика — которые делают эти модели надежными и предсказуемыми в производстве.

Реальная конкуренция

Меллеа, возможно, не решит самые большие проблемы ИИ. Это не сделает модели умнее или способнее. Это не предотвратит галлюцинации или предвзятость.

Но это может решить проблему, которую упускают из виду, а именно недостаток инфраструктуры, из-за которого модели с открытым исходным кодом кажутся хуже, чем они есть на самом деле.

Если Фултон прав, компании выбирают ChatGPT не потому, что модели OpenAI значительно лучше. Они выбирают его, потому что он поставляется с полным набором программного обеспечения, обеспечивающим простоту и надежность использования.

ИИ с открытым исходным кодом привнес нож в перестрелку — или, точнее, привнес в автомобильные гонки просто двигатель.

Mellea — это попытка IBM создать остальную часть автомобиля. От того, удастся ли это, зависит, останется ли ИИ с открытым исходным кодом диковинкой для любителей или станет настоящей альтернативой для предприятия.

Первые признаки обнадеживают. По крайней мере, внутри IBM главные инженеры обращают на это внимание.

Исследование Анаконды

Недавнее исследование компании Anaconda, которая предоставляет платформу для анализа данных с открытым исходным кодом и платформу распространения искусственного интеллекта для языков программирования Python и R, показало, что 92% респондентов используют инструменты и модели искусственного интеллекта с открытым исходным кодом, при этом 52% решительно предпочитают или вообще используют открытый исходный код.

Кроме того, согласно отчету Anaconda, почти 40% используют инструменты с открытым исходным кодом и коммерческие. Организации также следуют этому примеру чаще, чем в предыдущие годы. Примерно трое из каждых четырех респондентов (76%) заявили, что в этом году приоритет открытого исходного кода немного или значительно выше по сравнению с предыдущими 12 месяцами. Кроме того, 78% сообщают, что их организации решительно поддерживают открытый исходный код или поощряют его, когда экономическое обоснование поддерживает его использование, говорится в отчете.

«Несмотря на коммерческое использование, мы видим множество гибридных вариантов использования, около 40% сочетают открытый исходный код с некоторыми коммерческими предложениями», — рассказал The New Stack Стив Кроче, полевой технический директор Anaconda. «Тем не менее, обеспечение безопасности и возможность использования открытого исходного кода в ИИ станет огромной областью возможностей для людей, чтобы дифференцироваться и делать свои собственные вещи».

Более того: «Если вы хотите добиться успеха, не сосредотачивайтесь на коммерческих предложениях. Вместо этого сосредоточьтесь на открытом исходном коде», — сказал Сет Кларк, вице-президент Anaconda по продукту AI. «В зарождающихся областях открытый исходный код развивается быстрее, потому что большинство коммерческих предложений отстает. Когда инновации являются ключевой частью стратегии вашей компании, открытый исходный код будет играть значительную роль».

Mellea доступен по адресу github.com/generative-computing/mellea.

ТЕНДЕНЦИОННЫЕ ИСТОРИИ YOUTUBE.COM/THENEWSTACK Технологии развиваются быстро, не пропустите ни одной серии. Подпишитесь на наш канал YouTube, чтобы смотреть все наши подкасты, интервью, демонстрации и многое другое. ПОДПИСАТЬСЯ Группа, созданная в Sketch. Дэррил К. Тафт освещает DevOps, инструменты разработки программного обеспечения и вопросы, связанные с разработчиками, в своем офисе в Балтиморе. Он имеет более чем 25-летний опыт работы в бизнесе и всегда ищет новые новости. Он работал… Узнайте больше от Дэррила К. Тафта.