Couchbase спонсировал этот пост.

Большинство предприятий разделяют общую цель: для того, чтобы привлечь свои самые важные бизнес -операции как можно ближе к аудитории, которую они обслуживают. Это может означать, что потребители будут максимально безболезненными для заказа продуктов онлайн; Помощь сотрудникам справиться с запросами и заказов клиентов, где бы они ни встречали их на магазине; или демонстрировать регуляторам, что банк быстро идентифицирует и имеет дело с мошенничеством.

В мире, который все больше охватывает ИИ, это должно быть просто. Предприятия могут создавать инновационные приложения, которые могут удовлетворить и даже предсказать потребности своей аудитории. Тем не менее, создание этих приложений может быть более сложным, чем когда -либо. Как предприятие может гарантировать, что он создает приложения достаточно быстро, чтобы удовлетворить требования, которые развиваются так быстро, если не быстрее, чем технология? Как это может гарантировать, что эти приложения будут вести себя так же, как и ожидалось, и дать пользователям точную, полезную информацию и опыт? И как он может сделать это в масштабе, чтобы охватить тысячи или миллионы пользователей?

В то время как отрасли были зациклены на потенциале крупных языковых моделей (LLMS), питающих генеративный ИИ (Genai), модели малых языков (SLM) и другие подходы часто являются более эффективным решением.

Правильные инструменты для работы

Как и в любом проекте, при разработке любого нового приложения важно понимать его цель и для кого оно — и, и все чаще использовать это понимание, чтобы выбрать правильный инструмент искусственного интеллекта для работы. Например, ИИ -Дворцы быстро повторяют недостатки Genai, работающие на LLMS. Они могут быть ресурсоемкими, и они требуют тщательного управления данными и обучения, чтобы обеспечить риск ИИ не подвергает конфиденциальных данных и не страдает галлюцинациями или предубеждениями, которые делают какие-либо выводы в лучшем случае ненадежными.

Но в то же время нет правила, говоря, что LLM — это всегда ответ. Несмотря на то, что они предоставляют мощные общие возможности, они не подготовлены, чтобы ответить на каждый вопрос, относящийся к конкретной бизнес -области организации. Более специализированный SLM, обученный данным, специфичным для домена, может быть одинаково, если не более эффективным.

Больше не всегда лучше

Преимущества SLMS ясны. Их сосредоточение на более конкретных данных означает, что они могут более легко и точно отвечать на конкретные запросы, либо сами, либо согласно LLM. Для приложений, ожидающих выполнить специализированную функцию или ответить на специализированные запросы, это может быть бесценным.

Есть также преимущества безопасности и конфиденциальности. В отличие от LLM, который может полагаться на общедоступные данные, SLM может быть легче сделать запатентованным: алгоритм, обучение и — наиболее важно — все данные контролируются организацией владельца.

Независимо от того, обеспокоена ли организациям обменять критически важные для бизнеса или личные данные за пределами своих стен, обеспокоена тем, что она будет случайно получить доступ и использовать защищенные авторским правом или иным образом чувствительные данные из другого источника, или опасения, обнаружение его языковой модели, была испорчена благодаря воздействию противоречивых или неуместных данных, SLM может предложить некоторое спокойствие.

Помните основы

SLM имеет ряд преимуществ по сравнению с другими подходами к ИИ. Но, как и любая другая технология, это не значит, что они идеальны. Вместо этого предприятия должны понимать, какой подход лучше всего соответствует их потребностям, а затем убедиться, что у них есть все, чтобы сделать этот подход добиться успеха.

Например, эффективность SLM по -прежнему полностью зависит от данных. Если организация не может управлять данными на скорости и в масштабе, она неизбежно найдет, что его приложения ИИ поставлены под угрозу. Ключевым ожиданием современного ИИ является то, что он работает в режиме реального времени и может все больше расшифровать и говорить на человеческом языке. Любая архитектура данных должна иметь возможность поддерживать это, или приложениям не хватает жизненно важных возможностей.

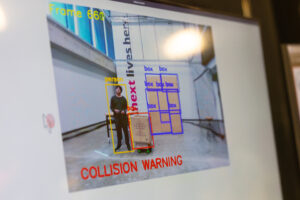

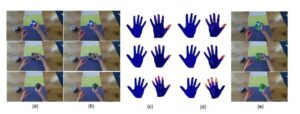

Существует также вопрос о том, где и как SLM обрабатывает данные. SLMS может быть реализована непосредственно на мобильные устройства, а возможность работать непосредственно на краю будет важна во многих вариантах использования. Это не только для того, чтобы гарантировать, что приложения могут работать при отключении от центрального сервера, но и для минимизации задержки и обеспечения максимально возможной работы. Например, приезжайте, чтобы построить более эффективные автономные транспортные средства. Большинство производителей, не говоря уже о пассажирах, хотели бы, чтобы этот ИИ работал немедленно, без задержки.

SLM имеет ряд преимуществ по сравнению с другими подходами к ИИ. Но, как и любая другая технология, это не значит, что они идеальны.

Важно отметить, что многие основополагающие модели также предлагают меньшие версии. Меньшие версии основополагающих моделей предлагают несколько преимуществ, включая повышение эффективности, более низкие вычислительные затраты и снижение задержки, что делает их идеальными для развертывания на устройствах с краями и местными машинами. Они также более интерпретируются, легче настраивать и более экологически чистые из-за более низкого потребления энергии. Тем не менее, они поставляются с компромиссами, такими как снижение точности, ограниченное удержание знаний и более слабая адаптивность, часто требуя большей настройки для конкретных задач.

Наконец, есть вопрос о том, кто владеет и управляет самими данными. Поддержание контроля над данными имеет решающее значение, не только для обеспечения конфиденциальности и соответствия ряду законов о защите данных, но и для обеспечения того, чтобы данные любая языковая модель изучалась и использует точную, полную и полностью доверяемая организацией.

Выбор вашей модели

Выбор правильного размера модели зависит от балансировки потребностей производительности с ограничениями ресурсов. SLMS может предложить предприятиям множество возможностей и доказать, что, когда дело доходит до ИИ, больше не всегда равняется лучше.

Выбор моделей (больших или маленьких) является частью рабочего процесса, который помогает поддерживать Couchbase. Couchbase предлагает векторный поиск по всей линейке продуктов, включая поддержку поиска сходства вектора на мобильных устройствах. Компания также запустила услуги Capella AI для облегчения рабочих процессов разработки и развертывания агентов с поддержкой AI. Зарегистрируйтесь, чтобы попробовать Couchbase Capella бесплатно. Частный предварительный просмотр услуг Capella AI также доступен.

Couchbase обеспечивает Capella, облачную платформу базы данных для современных приложений. Capella позволяет разработчикам и архитекторам быстро создавать приложения будущего и постоянно предоставлять клиентам постоянный опыт, чтобы упростить то, как предприятия разрабатывают, развертывают и потребляют современные приложения. Узнайте больше последних из Couchbase Trending Stories YouTube.com/thenewstack Tech, которые движутся быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Мохан Вартхакави — это вице -президент по разработке программного обеспечения, AI и Edge в Couchbase (NASDAQ: BASE) — поставщик платформы для данных разработчика для критических приложений в нашем мире ИИ. Ранее он занимал исполнительные должности в Cruise, AWS и Microsoft. Подробнее от Мохана Вартхакави