Наконец, ИИ может проверить сам факт. Один крупный языковой чат-бот теперь может проследить свои выходы до точных исходных источников данных, которые их информировали.

Разработанный Институтом искусственного интеллекта Аллена (AI2), Olmotrace, новой функцией на игровой площадке AI2, определяет источники данных, стоящие за текстовыми ответами из любой модели в проекте OLMO (Model Open Language).

Olmotrace определяет точный предварительный документ, стоящий за ответом, включая полные, прямые соответствия цитаты. Это также предоставляет исходные ссылки. Для этого базовая технология использует процесс, называемый «точный поиск» или «сопоставление строк».

«Мы познакомили Olmotrace, чтобы помочь людям понять, почему LLM говорят, что они делают из объектива своих учебных данных», — доктор философии в Вашингтоне Jiacheng Liu, университет Вашингтонского университета. Кандидат и исследователь AI2, рассказали новой стеке.

«Показывая, что многие вещи, созданные LLMS, отслеживаются к их учебным данным, мы открываем черные ящики о том, как работают LLMS, повышая прозрачность и наше доверие к ним», — добавил он.

На сегодняшний день ни один другой чат -бот на рынке не обеспечивает возможность отслеживать ответ модели на конкретные источники, используемые в рамках его обучающих данных. Это делает новости большим шагом для видимости ИИ и прозрачности.

Секретный соус: двигатель Infini-Gram

Прорыв Olmotrace возможен с использованием академического проекта Infini-Gram, двигателя, разработанного LIU для эффективной обработки запросов для массовых данных, используемых для обучения языковых моделей.

Доступный для обнимающего лица, Infini-Gram проводит точный матч по индексам, скомпилированным из восьми крупных корпораций, представляющих почти 5 миллиардов документов или 4 триллиона токенов.

Infini-Gram не вмешивается в процесс генерации, но проводит свои ссылки после того, как модель выпустила свой ответ. Это делает его привлекательным в качестве дополнения к подключам и игре для других чат-ботов на основе LLM.

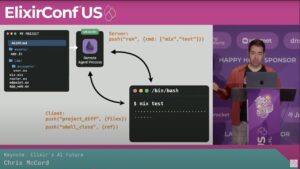

Что особенно убедительно, так это то, что двигатель запрашивается через API, который обрабатывает запросы всего за десятки миллисекунд. Разработчики могут отправлять HTTP -запросы в конечную точку с помощью полезной нагрузки JSON, определяющей семантику и другие параметры, и она выплеснет соответствующие исходные тексты.

Хотя API не имеет гарантированного времени безотказной работы, это захватывающее доказательство концепции для того, чтобы сделать LLM более проверяемых и заслуживающих доверия в масштабе. По словам Лю, это хорошо проверено, на сегодняшний день прослужал 500 миллионов запросов API.

Olmotrace использует Infini-Gram в своем ядре, но применяет свою собственную алгоритмическую специю сверху, которая перечисляет все возможные субстраты вывода модели и делает параллельные запросы. Он также вызывает собственную версию API с выделенным сервером с использованием более высоких требований к масштабируемости.

Почему прослеживаемость LLM была тяжелой

Исторически, что чат-боты на основе LLM изо всех сил пытались отслеживать выходы с точными ссылками.

Проблема возникает в результате фундаментального дизайна языковых моделей. Они не индексируются и легко доступны для поиска, как база данных — вместо этого они представляют шаблоны и статистические отношения, что делает их генезис сложным для разложения.

По словам Лю, что масштаб предварительных данных LLM — это виновник. «Современные LLM обучаются на триллионах токенов», — сказал он. «Существующие методы отслеживания трудно масштабироваться до этого уровня».

Другая проблема — нежелание чат -ботов, чтобы раскрыть свои учебные данные.

«Инструменты отслеживания, такие как Olmotrace, требуют от поставщиков чат -ботов, чтобы разоблачить как минимум часть данных обучения их модели», — сказал Лю. Поскольку учебные данные являются высокопоставленной бизнес-секретом в мире искусственного интеллекта, это может быть тяжелой иглой, добавляет он.

Сопоставление строк: дополнение к тряпке

За прошедший год чат-боты, такие как Chatgpt, Deepseek, Claude, Microsoft Copilot, Nemploexity и другие, были вооружены поколением-извлечением (RAG), чтобы указывать на внешние источники.

В то время как RAG обычно извлекает и использует внешние источники, Olmotrace добавляет еще один слой проверки, который рассматривает учебные данные самого LLM.

Это важно, поскольку с помощью RAG модели все еще могут производить уникальные (или ошибочные) претензии на основе их первоначальной подготовки. «На самом деле нет способа узнать, действительно ли модель полагается на документы в контексте по сравнению с параметризованными знаниями, полученными из учебных данных»,-говорит Лю.

Сопоставление строк дополняет недавние улучшения, такие как тряпичная и размер контекста. Но заставит ли AI2 Olmotrace прецедент для других чат -ботов, чтобы последовать их примеру с учебными цитатами? Время покажет.

«Мы хотели бы видеть больше чат -ботов для поддержки отслеживаемости и принять прозрачность данных», — говорит Лю. «Это разрыв во многих существующих системах чат-ботов, и он препятствует их развертыванию в более высоких сценариях».

Увеличение веры в ИИ в разных доменах

Для предприятий и разработчиков лучшая отслеживаемость и проверка для ответов на модели могут значительно помочь в отладке моделей.

«Olmotrace был бы особенно полезен для предприятий, где они часто настраивают модели на свои данные, специфичные для домена, и хотят убедиться, что модели остаются верными таким данным»,-говорит Лю.

Для исследователей это может разоблачить полезные условия, например, почему модель привилегирует одну математическую теорему над другой, добавил Лю.

Что касается потребительской стороны, такие инструменты, как Olmotrace, могут повысить уверенность пользователей в точности генеративного ИИ, что с самого начала было неуловимой проблемой. Тем не менее, общий вариант использования Olmotrace довольно академический.

«Игровая площадка (AI2) определенно выглядит и функционирует, как инструмент, созданный исследователями для исследователей», — сказал Brent Phillips, производитель Humanitarian AI Today Podcast, New Stack. «Для сотрудников гуманитарных организаций я с нетерпением жду возможности использовать его для взаимодействия с репозиториями, такими как гуманитарная обмен данными».

Закрытие текущих пробелов

В то время как Olmotrace предлагает беспрецедентные проверки и уравновешивания на генеративном ИИ, это не панацея для рисков LLM, таких как отравление данными обучения, ошибки модели или галлюцинации.

Кроме того, отслеживаемость имеет свои пределы. Например, хотя Olmotrace может предоставить точные текстовые совпадения для простых фактов, невозможно отслеживать источники для творческого поколения, такие как стихи или истории.

Другим недостатком является то, что Olmotrace выдерживает некоторые источники с 404-ошибчными ссылками. По словам Лю, это свидетельствует о том, что он свидетельствует о гниле ссылки и историческом моменте, когда веб -данные использовались для создания учебных наборов данных.

Надежда состоит в том, что, по его словам, благодаря открытому источникам, двигатель может быть добавлен и усовершенствован: «Выпустив исходный код и пакеты, мы можем позволить другим людям строить индексы на своих собственных данных обучения, чтобы они могли создать для этого разрыва».

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Билл Доеррфельд — технический журналист и лидер API. Он является главным редактором блога Nordic APIS, глобального сообщества API, посвященного тому, чтобы сделать мир более программируемым. Он также является активным участником горстки … Подробнее о Билле Доерфельде