В течение нескольких лет мы считаем само собой разумеющимся, что многие крупные языковые модели на основе трансформаторов (LLMS) используют технику, известную как авторегрессию. Эта техника машинного обучения хорошо согласуется с тем, сколько языков работает, поскольку она обрабатывает и генерирует каждое слово или токен, последовательно слева направо. Но с растущей сложностью текста, сгенерированного AI, затраты на вывод и проблемы с задержкой также возросли.

Тем не менее, может быть лучший способ, благодаря недавнему выпуску Mercury By US, основанными на основе основополагающих лабораторий, первой диффузионной диффузии в коммерческом масштабе (DLLM), которая обещает более быстрое и более эффективное генерацию текста с использованием того же подхода на основе диффузии, которые подкрепляют модели генерации изображений, такие как DALL-E, стабильная диффузия и Midjourney.

Авторегрессия против диффузии

Традиционные авторегрессивные модели крупных языков будут обрабатывать токены последовательно, при этом генерация каждого нового слова зависит от предыдущих токенов последовательности. В этом подходе есть примечательные преимущества: он предлагает большую когерентность, контекстуальную глубину и реалистичные результаты, которые отражают зависимости между словами и фразами. Тем не менее, недостатки этих моделей включают повышенную вычислительную стоимость, более медленную скорость вывода и более потенциальные ошибки.

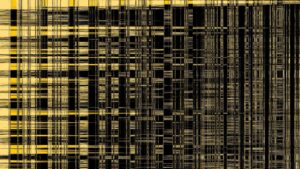

Напротив, не последовательный характер диффузионных моделей преодолевает многие из этих проблем. Для генерации изображений диффузионные модели работают, сначала постепенно добавляя случайный шум к изображению в процессе, называемом «Noising». Затем модель учится возвращаться от этого добавленного шума, итеративно «отменять», чтобы реконструировать исходное изображение. Благодаря этим процессам модель учится распознавать закономерности и, в конечном счете, как синтезировать и постоянно совершенствовать подобные изображения в будущем.

Как диффузионные модели работают для генерации изображений-затрудненного и отменения. Через Тима Кветко.

Этот целостный, параллельный подход диффузионных моделей невероятно эффективен с генерацией изображений и видео, но до сих пор трудно достичь с помощью текста.

«Трансформеры доминируют в генерации текста LLM и последовательно создают токены. Диффузионные модели предлагают альтернативу-они генерируют весь текст одновременно, применяя грубый процесс »,-объяснил основатель Deeplearning.AI Эндрю Нг в посте на X.

Меркурий ускоряет генерацию языка

По данным компании, Mercury в пять раз быстрее, чем обычные крупные языковые модели, и в 10 раз быстрее, чем другие оптимизированные скорости LLM-плюс, в целом, его дешевле. Модели Mercury могут работать на уровне более 1000 токенов в секунду на NVIDIA H100S-пылающая скорость, которая ранее была достижима только с пользовательскими чипами от специализированных аппаратных компаний, таких как Groq, Cerebras и Sambanova.

В настоящее время он доступен в качестве демонстрации как Mercury Coder, диффузионную большую языковую модель, которая специально оптимизирована для создания кода. Вы можете увидеть, как он складывается в другие LLMS в генерации кода в реальном времени в видео ниже.

Согласно Labs, «маленькая» версия Mercury Coder находится наравне с GPT-4O Mini от Openai и Claude 3.5 Haiku, в то время как в 10 раз быстрее во время тестирования. «Mini» Mercury Model превосходит небольшие модели с открытым исходным кодом, такие как Meta’s Llama 3.1 8b, достигая более 1000 токенов в секунду. По сравнению с некоторыми Frontier LLM, которые работают менее чем на 50 токенов в секунду, Mercury предлагает 20 -кратное ускорение.

Сравнение скорости: выходные токены в секунду, рабочая нагрузка кодирования. Через Labs.

При оценке по стандартным контрольным показателям кодирования, Mercury Coder может либо сохранить свои собственные, либо превзойти своих конкурентов, сохраняя при этом высокий уровень качества в своих результатах.

Через Labs.

Потенциальное воздействие на ИИ

С гораздо эффективнее, когда Mercury использует товарные графические процессоры, это может означать снижение стоимости вывода, без особого негативного влияния на производительность и без необходимости специализированного оборудования. Это может означать еще более повышенную производительность для диффузионных моделей, таких как Меркурий в будущем, поскольку графические процессоры продолжают развиваться.

В настоящее время есть некоторые недостатки, когда дело доходит до диффузионных моделей. Принимая во внимание, что авторегрессивные модели нуждаются только в одном проходе на токен, диффузионные модели обычно требуют, чтобы токены проходили несколько прямого проходов в нейронной сети, прежде чем он сможет генерировать выход. Тем не менее, этот потенциальный недостаток в основном уравновешивается тем фактом, что диффузионные модели могут обрабатывать все токены одновременно параллельно.

Потенциальное использование для генерации текста на основе диффузии

Начальные лаборатории считают, что генерация текста на основе диффузии будет отличной подходящей для генерации кода, автоматизации предприятия, а также чувствительных к задержке вариантов использования, таких как разговорная ИИ, агент ИИ и в ситуациях с ограниченными ресурсами (такими как мобильные устройства). Из -за расширенных возможностей рассуждения DLLMS они могут исправить галлюцинации, в то же время обрабатывая ответы — все в течение секунды. В долгосрочной перспективе, такие как Mercury, могут сигнализировать о сдвиге парадигмы от авторегрессии к моделям на основе диффузии для быстрого и эффективного генерации текста.

Меркурий теперь доступен в качестве демонстрации кодирования, а также для предприятия клиентов через API и развертывания локально, с точной настройкой поддержки, предлагаемой для обоих. Чтобы узнать больше, посетите Labs.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Кимберли Мок — репортер технологий и дизайна, который охватывает искусственный интеллект, робототехнику, квантовые вычисления, техническую культуру и научные истории для нового стека. Обученная как архитектор, она также является иллюстратором и междисциплинарным дизайнером, который был увлечен … Подробнее от Kimberley Mok