Японский стартап Сакана сказал, что его ИИ генерировал первую рецензируемую научную публикацию. Но хотя требование не соответствует действительности, есть существенные предостережения.

Дискуссия, кружащаяся вокруг ИИ, и его роль в научном процессе с каждым днем растет. Многие исследователи не верят, что ИИ вполне готов служить «ко-научным», в то время как другие думают, что есть потенциал-но признайте, что это первые дни.

Сакана попадает в последний лагерь.

Компания заявила, что она использовала систему ИИ под названием AI Scientist-V2, чтобы создать статью, которую Сакана затем представила на семинар в ICLR, давней и авторитетной конференции искусственного интеллекта. Сакана утверждает, что организаторы семинара, а также руководство ICLR согласились работать с компанией для проведения эксперимента по двойному слепому обзору рукописей, сгенерированных AI.

Сакана заявил, что он сотрудничал с исследователями из Университета Британской Колумбии и Оксфордского университета, чтобы представить три сгенерированных AI документа на вышеупомянутый семинар для Peer Review. Ученый из AI-V2 сгенерировал документы «сквозные», претендуют Сакана, включая научные гипотезы, эксперименты и экспериментальный код, анализ данных, визуализации, текст и названия.

«Мы создали исследовательские идеи, предоставив ИИ Аннотация и описание семинара», — сказал TechCrunch Роберт Ланге, ученый -исследователь и основатель Sakana, Роберт Ланге. «Это гарантировало, что сгенерированные документы были по теме и подходящим представлениям».

Одна статья из трех была принята на семинар ICLR — статью, которая бросает критическую линзу по методам обучения для моделей искусственного интеллекта. Сакана сказал, что это сразу же сняло статью, прежде чем она может быть опубликована в интересах прозрачности и уважения к конвенциям ICLR.

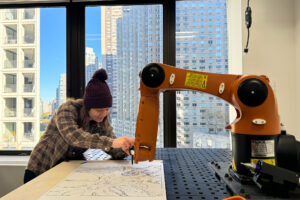

Фрагмент бумаги, сгенерированной AI Саканы.Кредиты изображения:Блокировать

«Общепринятая статья представляет новый, многообещающий метод обучения нейронных сетей и показывает, что существуют оставшиеся эмпирические проблемы», — сказал Ланге. «Это обеспечивает интересную точку данных, чтобы вызвать дальнейшее научное исследование».

Но достижение не так впечатляет, как может показаться на первый взгляд.

В сообщении в блоге Сакана признает, что его ИИ иногда доставлял «смущающие» ошибки цитирования, например, неправильно приписывая метод статьи 2016 года вместо оригинальной работы 1997 года.

Бумага Саканы также не подвергалась так много внимания, как некоторые другие рецензируемые публикации. Поскольку компания сняла его после первоначального рассмотрения, газета не получила дополнительную «мета-обзор», в течение которого организаторы семинара могли бы в теории отвергнуть его.

Тогда существует тот факт, что показатели приемлемости на семинары по конференциям, как правило, выше, чем показатели принятия для основного «трека конференции» — факт, как Сакана откровенно упоминает в своем блоге. Компания заявила, что ни одно из его исследований, сгенерированных AI, не передало свою внутреннюю бар для публикации на конференции ICLR.

Мэтью Гусдиал, исследователь ИИ и доцент Университета Альберты, назвал результаты Саканы «немного вводящими в заблуждение».

«Люди из Саканы выбрали документы из некоторых сгенерированных, а это означает, что они использовали человеческое суждение с точки зрения выбора результатов, которые, как они думали, могут попасть», — сказал он по электронной почте. «Я думаю, что это показывает, что люди плюс ИИ могут быть эффективными, а не только ИИ может создать научный прогресс».

Майк Кук, научный сотрудник King’s College London, специализирующийся на искусственном интеллекте, поставил под сомнение строгость рецензентов и семинара.

«Новые семинары, такие как этот, часто рассматриваются более младшими исследователями», — сказал он TechCrunch. «Стоит также отметить, что этот семинар о негативных результатах и трудностях — что здорово, я раньше проводил аналогичный семинар — но, возможно, легче заставить ИИ писать о неудаче убедительно».

Кук добавил, что он не удивлен, что ИИ может пройти рецензию, учитывая, что ИИ превосходен в написании человеческой прозы. Частично-сгенерированные статьи документы, проходящие обзор журнала, даже не новое, отметил Кук, и этические дилеммы не являются для наук.

Технические недостатки ИИ, такие как его тенденция к галлюцинации, заставляют многих ученых опасаться одобрения его для серьезной работы. Более того, эксперты опасаются, что ИИ может просто в конечном итоге создавать шум в научной литературе, не повышая прогресс.

«Нам нужно спросить себя, [Sakana’s] Результат заключается в том, насколько хорош ИИ для проектирования и проведения экспериментов, или о том, насколько хорошо это продавать идеи людям — которые, как мы знаем, уже отлично подходит », — сказал Кук. «Существует разница между прохождением рецензирования и содействием знаниями в поле».

Сакана, к его чести, не утверждает, что его ИИ может производить новаторскую — или даже особенно новую научную работу. Скорее, цель эксперимента состояла в том, чтобы «изучить качество исследований, сгенерированных AI», сказала компания, и подчеркнуть неотложную потребность в «нормах, касающихся науки, сгенерированной AI».

«[T]Вот сложные вопросы о том, [AI-generated] Наука должна сначала судить по собственным заслугам, чтобы избежать предвзятости против нее », — написала компания. «В дальнейшем мы будем продолжать обмениваться мнениями с исследовательским сообществом по состоянию этой технологии, чтобы гарантировать, что она не превратится в ситуацию в будущем, когда ее единственная цель — пройти рассмотрение сверстников, тем самым существенно подрывая значение научного процесса рассмотрения».