Я тесно сотрудничал с разработчиками в течение многих лет, и на протяжении многих этапов технологий. Я могу с уверенностью сказать, что темп, в котором происходит инновации искусственного интеллекта, не похож на то, что мы видели раньше. Эффективность является ключевым для разработчиков, чтобы сохранить этот темп, а отрасль достигает точки, когда ИИ может масштабироваться для каждого. Это достигается при развертывании рабочих нагрузок на основе искусственного интеллекта с помощью бесшовной аппаратной интеграции.

Понимание вычислительных требований, лежащих в основе обучения и вывода, имеет решающее значение для масштабирования эффективного развертывания на различных устройствах.

Доступ к самым быстрым и наиболее эффективным методам развертывания

Скорость и эффективность не подлежат обсуждению при развертывании ИИ в реальных приложениях. Например, Edge AI должен обрабатывать данные, близкие к источнику, часто с низкой задержкой, чтобы включить ответы в реальном времени. Это особенно важно для телемедицины, автономных транспортных средств и приложений онлайн -игр.

Разработчикам нужны правильные инструменты развертывания для ускорения модельной итерации, помогая быстрее выставлять решения на рынке. Такие рамки, как Tensorflow и Pytorch, предлагают надежную, удобную для разработчиков среду. Последние модели LLAMA 3.2 1B/3B в сочетании с недавним бета -выпуском Exectorch позволяют разработчикам экспортировать и запускать модели Pytorch на краевых устройствах, таких как мобильные телефоны и микроконтроллеры, оптимизируя развертывание модели искусственного интеллекта независимо от платформы.

Понимание важности этих структур имеет важное значение для разработчиков, стремящихся сбалансировать скорость и эффективность. Они обеспечивают быструю, итеративную разработку и приближают рабочие нагрузки ИИ ближе к краю, обеспечивая оптимальную производительность приложения даже с ограниченными ресурсами.

Включение масштабируемого ИИ в экосистеме с открытым исходным кодом

По мере расширения технологии искусственного интеллекта необходимо создание совместимости. Стандартизированные API и библиотеки предлагают согласованность, позволяя разработчикам создавать и развернуть модели на различных платформах, не постоянно реконфигурируя свой код. Это значительно сокращает время разработки проекта, позволяя разработчикам сосредоточиться на инновациях и создании дифференцируемой ценности благодаря своей уникальной функциональности приложения, а не на решении вопросов совместимости.

В моей роли в руке я был привержен улучшению взаимодействия, как видно из нашего последнего партнерства и сотрудничества с командами Pytorch в Meta, где мы поддерживаем миссию по предоставлению структуры обмена моделей, которая способствует взаимодействии и совместимости Модели и алгоритмы в экосистеме ИИ. Интегрируя вычислительные библиотеки, оптимизации производительности и микрокернелы для поддержки архитектуры базовой руки, мы обеспечиваем совместимость и повышение производительности по всему диапазону серверов ARM, таких как AWS Graviton в облаке и конечных устройствах на краю, будь то смартфоны или отдельные платтные компьютеры Как Raspberry Pi. Разработчики могут работать непосредственно с новейшими моделями Llama 3.2, Pytorc, H и Executorch Framework без дополнительных модификаций или оптимизации, экономя время и ресурсы.

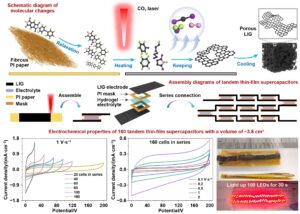

Мы применяем этот подход по мощности по всей экосистеме, в том числе несколько других основополагающих рамок, таких как библиотеки выводов Tensorflow и открытых исходных кодов, такие как XNNPACK Google, для демократизации и упрощения развития искусственного интеллекта для миллиардов устройств на основе рук по всему миру. Разработчики могут более эффективно доставлять надежные и масштабируемые решения ИИ с экосистемой инструментов и рамок.

Создание совместной экосистемы для оптимальной производительности

Важно подчеркнуть, что эволюция ИИ выходит за рамки рамки с открытым исходным кодом и в значительной степени зависит от партнерских отношений и сотрудничества между разработчиками, поставщиками оборудования, ML и DevOps ISVS и исследовательскими сообществами. Сотрудничество помогает аппаратным командам с тонкой настройкой моделей искусственного интеллекта и их выполнению на базовом оборудовании, гарантируя, что они максимизируют производительность, не жертвуя эффективностью. Отличным примером является работа Taws по ускорению вывода Pytorch с факелом. Компиль на гравитоне. Партнерство с поставщиками облачных услуг, работающих на основе серверов на основе ARM, опираются на более ранние инициативы с открытым исходным кодом, включив оптимизации, специфичные для оборудования, в рабочий процесс. Это упрощает процесс разработки, поэтому разработчикам не нужно сами справляться с этими оптимизациями.

ML ISV, такие как DataBricks, также играют ключевую роль, предлагая разработчикам разведывательные платформы, время выполнения и рабочие процессы, которые поддерживают оптимизированные ресурсы, такие как AWS Graviton для решения задач развертывания, при этом продвигая общие цели в масштабируемости и производительности искусственного интеллекта.

Конечно, разработка модели, MLOP и DevOps необходимы. Разработчики используют такие платформы, как HuggingFace и GitHub для сотрудничества, инновации и развертывания новейших моделей и рамок. Они делают развитие ИИ фундаментальным и вездесущим.

Недавно Github предложил упрощенный рецепт MLOPS для оптимизированной разработки. Отличным примером является упрощенный рецепт MLOPS Github, недавно предложенный для оптимизированной разработки. Мы работали с их предложением и создали учебник, внедряющий рецепт GitHub, чтобы демистифицировать MLOP для разработчиков повсюду. Наше партнерство с GitHub и обучающимися путями, которые позволяют разработчикам получить Jumpstart с реальными примерами на основе Pytorch, помогают обеспечить даже разработчики, которые только начинают работать, упростили рабочие процессы MLOPS и оптимизированную производительность в первый день.

Заключение

Мы смотрим на возможность уникальной возможности с ИИ, и разработчики-вместе с их сотрудниками в области аппаратного и программного обеспечения-удерживая ключ к разблокированию полного обещания этой технологии. Я провел большую часть своей карьеры, работая в сообществе ИИ. С момента присоединения к ARM в прошлом году моя миссия заключалась в том, чтобы расширить возможности разработчиков по всему миру, чтобы создать передовые возможности ИИ и приложений на ARM в качестве самой повсеместной платформы на планете.

Путь к масштабированию ИИ для удовлетворения требований отраслей и сообществ во всем мире включает в себя три области фокуса: эффективность, совместимость и сотрудничество. Благодаря бесшовной аппаратной интеграции, надежной структуры с открытым исходным кодом и партнерских отношений, которые упрощают и улучшают разработку ИИ, мы можем продолжать обеспечивать рост ИИ таким образом, чтобы он был доступным, устойчивым и эффективным для всех.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Алекс — старший вице -президент по искусственным средствам и разработчикам в ARM, где он отвечает за помощь разработчикам создать свои лучшие впечатления от ИИ и программные приложения на самой вездесущей вычислительной платформе на планете, от облака до … Подробнее от Алекса Спинелли