Большой языковой модели (LLM) генеративные услуги искусственного интеллекта, такие как OpenAI или Google Gemini, лучше в некоторых задачах, чем другие, консультировали Wei-Meng Lee, технолог и основатель Developer Learning Solutions, в ACM Techtalk в прошлом месяце, под названием «Разблокировать Объятие лица: упростите ИИ с трансформаторами, LLMS, тряпкой, тонкой настройкой ».

Например, LLM не очень хороши в выполнении аналитических задач, удивительно. И даже если вы хотите использовать LLM для задачи, это, вероятно, было бы чрезмерно дорого, учитывая размер вашего набора данных.

Скажем, у вас есть файл CSV с 20 столбцами и пятью миллионами строк. Это может включать записи транзакций, а также данные клиентов. Вы хотите задать вопрос, например, что сделал этот клиент в один конкретный день. Сколько вы заработали в этом месяце? Это легкая работа для LLM?

«Дело в том, что нет», — объяснил Вэй Мэн. «LLM очень плохи в аналитических задачах».

Конечно, LLM очень хороши по текстовым вопросам и извлекая информацию из крупных неструктурированных тел текста. Тем не менее, числовой анализ по -прежнему является проблемой.

Но есть способ, которым вы все еще можете использовать LLM для таких задач.

Токены и доллары

Информация, которую предоставляет пользователь, и ответы, полученные при взаимодействии с службой чата Genai, известна как «размер окна контекста». Обычно это измеряется в токенах.

Грубо говоря, один токен примерно равняется 3/4S английского слова. Части слов могут быть целыми токенами, с префиксами и суффиксами, составляющими свои собственные жетоны.

Пример токенизации из обнимающегося лицевого курса по созданию агентов искусственного интеллекта.

Услуги имеют различный размер контекста. GPT-40-Mini в OpenAI имеет размер окна содержимого 128 000 токенов, или около 96 000 слов и связанных с ними символов, как с вопросом, так и ответом.

Таким образом, вы должны заполнить весь свой вопрос, вместе со всеми подтверждающими данными, в окно контекста.

«Для обычного чата, а не проблемы», — сказал Вэй Мэн.

Но если вы используете действительно большие наборы данных, это будет стоить вам!

Файл значения CSV с пятью миллионами колонок будет быстро прожевывать это окно токена.

Превышайте размер окна контекста, и вы получите сообщение об ошибке или понесете дополнительную плату.

Также доставка ваших данных выводит конфиденциальность ваших данных в риске.

Сделай это вместо этого

Вместо того, чтобы отправлять весь набор данных, сохраните данные на вашем сервере. Затем формулируйте подсказку, включив описание формата набора данных, возможно, с самой схемой и, возможно, даже несколькими образцами анонимных примеров.

Затем вместо того, чтобы попросить Genai ответить на ваши вопросы, попросите Genai генерировать код или запросы, необходимые для них.

Затем вы выполняете код в своей местной среде.

«Вы не нарушаете размер окна контекста. Вы не жертвуете конфиденциальностью своих данных », — сказал он.

В качестве примера Вей Мэн сказал, как можно было проанализировать набор данных всех пассажиров на борту злополучного Titanic Voyage, используя OpenAI и LM Studio. Файл CVS с данными, которые имели 891 строки и 12 строк, был загружен в Python DataFrame.

Вот подсказка, которую он затем дал Openai:

{» ROLE ‘:’ userf ‘,’ Content ‘:’ » Вот схема моих данных: PassenderId, выжил, Pclass, имя, пол, возраст, SIB5p, Parch, билет, тариф, салон, приступил к тому, что для Выжил, 0 означает мертвые, 1 означает, что жив возвращает ответ в коде Python только для вашей информации, я уже загрузил файл CSV в DataFrame с именем df » » » » ‘

}

В целом, чем более описательный подсказка, тем лучшие ответы вы получите, посоветовал Вэй Мэн.

Как только все подсказки загружены, вы можете задать свои вопросы, например, как

- Какова доля пассажиров мужского и женского пола?

- Можете ли вы визуализировать уровень выживаемости для каждого пассажирского класса (PCLASS)?

- Можете ли вы визуализировать уровень выживаемости пассажиров, путешествующих в одиночку против семьи?

Обратите внимание, что ответы не должны быть на основе текста, если в этом случае есть инструменты визуализации Python.

Используя ноутбук Jupyter или LM Studio, вы можете даже автоматизировать выполнение запроса самостоятельно, при этом результаты отображаются в рабочем пространстве, как только он будет возвращен.

«Приятно то, что вам не нужно загружать данные или изучать анализ данных», — сказал он.

От презентации об объятиях Вей-Менга Ли.

Что такое обнимающее лицо?

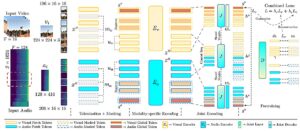

Презентация Wei-Meng Lee касалась главным образом того, как использовать Hearging Face, совместную платформу для разработчиков и исследователей для использования и сотрудничества в моделях машинного обучения, наборах данных и приложениях.

В презентации Wei-Meng показал, как использовать предварительно обученные модели Hugging Face через API компании Transformers. Объединяемые объекты Face Cools могут затем облегчить задачу использования этих моделей, он затем продолжает демонстрировать. И он показывает, как использовать библиотеку Gradio, чтобы легко запустить приложения Python на основе LLM.

«Gradio позволяет вам создать очень хороший веб-фронт с парой строк кода»,-сказал Вэй-Менг.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Joab Jackson является старшим редактором нового стека, охватывающего облачные нативные вычисления и системы системы. Он сообщил об инфраструктуре и развитии IT более 25 лет, в том числе в IDG и государственных компьютерных новостях. До этого он … читал больше от Джоаба Джексона