OpenAI привносит новые модели ИИ транскрипции и генерации голоса в свой API, который, как утверждает компания, улучшается после своих предыдущих выпусков.

Для OpenAI модели вписываются в его более широкое «агентское» видение: создание автоматизированных систем, которые могут самостоятельно выполнять задачи от имени пользователей. Определение «агента» может быть в споре, но глава продукта Openai Olivier Godemont назвал одну интерпретацию как чат -бот, который может говорить с клиентами бизнеса.

«В ближайшие месяцы мы увидим все больше и больше агентов», — сказал Гогемонт TechCrunch во время брифинга. «И поэтому общая тема помогает клиентам и разработчикам использовать агенты, которые полезны, доступны и точны».

OpenAI утверждает, что его новая модель текста в речь, «GPT-4O-Mini-TTS», не только обеспечивает более нюансированную и реалистичную речь, но и более «управляемый», чем его модели, синтезирующие речь предыдущего поколения. Разработчики могут обучать GPT-4o-Mini-TTS о том, как говорить вещи на естественном языке-например, «говорить как безумный ученый» или «использовать безмятежный голос, как учитель осознанности».

Вот «истинный стиль преступности», выветривший голос:

А вот образец женского «профессионального» голоса:

Джефф Харис, сотрудник продукта в Openai, сказал TechCrunch, что цель состоит в том, чтобы позволить разработчикам адаптировать как «опыт», так и «контекст».

«В разных контекстах вы не просто хотите плоский монотонный голос», — продолжил Харрис. «Если вы находитесь в опыте поддержки клиентов и хотите, чтобы голос был извиняющимся, потому что он сделал ошибку, у вас действительно может быть голос, есть такая эмоция в нем […] Мы считаем, что разработчики и пользователи хотят действительно контролировать не только то, что говорят, но и то, как об этом говорят ».

Что касается новых моделей Spearai, «GPT-4-Transcribe» и «GPT-4O-Mini-Transcribe», они эффективно заменяют модель транскрипции Whisper Long-The Tooth. Обученные «разнообразным, высококачественным аудио наборе данных», новые модели могут лучше отражать акцентированную и разнообразную речь, заявления OpenAI, даже в хаотических средах.

Харрис также добавил, что они также реже галлюцинируют. Шепше, как известно, имел тенденцию сфабриковать слова — и даже целые отрывки — в разговорах, вводя все, от расовых комментариев до воображаемых медицинских методов лечения в транскрипты.

«[T]Модели HESE значительно улучшены по сравнению с шепотом на этом фронте, — сказал Харрис. — Убедитесь, что модели точно, совершенно необходимо для получения надежного голоса и точного [in this context] означает, что модели точно слышат слова [and] не заполняют подробности, которые они не слышали ».

Однако ваш пробег может варьироваться в зависимости от языка, который транскрибируется.

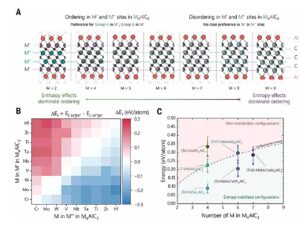

Согласно внутренним критериям Openai, GPT-4o-Transcribe, более точный из двух моделей транскрипции, имеет «частота ошибок слова», приближающееся к 30% для индийских и дравидийских языков, таких как тамил, телугу, малаялам и каннада. Это означает, что модель пропускает около трех из каждых 10 слов в этих языках.

Результаты внутренних показателей распознавания речи Openai.Кредиты изображения:Openai

В отрыве от традиций Openai не планирует сделать свои новые модели транскрипции открыто доступными. Компания исторически выпускала новые версии Whisper для коммерческого использования по лицензии MIT.

Харрис сказал, что GPT-4-Transcribe и GPT-4O-Mini Transcribe «намного больше шепота» и, следовательно, не хорошие кандидаты для открытого выпуска.

«[T]Привет, не та модель, которую вы можете просто работать на своем ноутбуке, как шепот, — продолжил он.[W]Эл, чтобы убедиться, что если мы выпускаем вещи в открытом исходном коде, мы делаем это задумчиво, и у нас есть модель, которая действительно оттачивается за эту конкретную потребность. И мы думаем, что устройства конечных пользователей являются одним из самых интересных случаев для моделей с открытым исходным кодом ».