В следующий раз, когда вы зададите CHATGPT или другую генеративную службу искусственного интеллекта вопрос, обратите внимание на порядок слов в ответе, который вы получите.

Последние несколько слов в вашем запросе почти всегда будут первыми несколькими словами сгенерированного ответа.

Это важный процесс того, как работают крупные языковые модели (LLMS) — назад, оценивая каждое слово с точки зрения каждого предыдущего — указывал на Брюса Момджяна, вице -президента EDB и евангелиста Postgres, в разговоре в Fosdem 2025, в Брюсселе, в прошлом месяце.

Используя технологию базы данных в качестве точки запуска, Momjian прошел аудиторию, как данные преобразуются в ИИ, и почему мы еще не должны ошибаться манипулирование данными за фактическую человеческую интеллект.

От описательного до генеративного

До 2022 года то, что мы знали как «ИИ», было в основном задачами дискриминации и разъяснения, где ИИ отвечал на такие вопросы, как «собака или кошка?» или была ли транзакция с кредитной картой реальной. Это было здорово для прогнозов, классификаций, рекомендаций.

Новый «ИИ», проявленный мгновенным успехом CHATGPT, посвящена созданию контента, которого раньше не было: суммирования, чат -ботов, семантического поиска, создание изображений, программирования, звуков и видео.

Вместо того, чтобы искать границы, как это сделал более ранний ИИ, генеративный ИИ эффективно генерирует новый контент.

«Мы на диком западе. На самом деле мы не знаем всего, что мы можем сделать», — сказал Момжян.

Массивная вселенная векторов

Ключ к этому подходу начинается с векторной обработки. Google впервые зарегистрировал эту технику в статье 2018 года под названием «Эффективная оценка представлений слов в векторном пространстве» и предложила модель под названием Word2VEC.

Вектор — это математический объект с двумя числами, величина (длина) и направление.

Каждое слово в учебных данных имеет вектор с любым другим словом, образуя очень размерное векторное пространство. (Ради простоты, Momjian сосредоточился на текстовом генеративном ИИ, хотя изображения и другие формы генерации контента работают по аналогичным принципам).

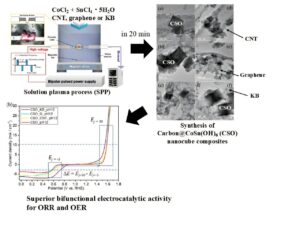

Слайд: Брюс Момжян

Эта вселенная слов действительно очень большая.

«Мы имеем дело в масштабе, которое находится в нескольких минутах от графиков, чтобы все, что мы можем понять в физическом мире», — сказал Момцзян.

MOMJIAN отметил, что в CathGPT LLM может быть до 12 288 измерений, которые в общей сложности до более чем 10 до 188 000 измерений, что намного больше, чем общее количество атомов во вселенной.

Вектор каждого слова дается одинаковая длины. Ему также присваивается направление, количество плавающей запятой случайным образом, которое существует где -то в этой вселенной от 10 до 188 000 измерений.

Тренировочный день

Следующим шагом является прокурор в это пространство огромным количеством учебных документов.

Для каждого слова его вектор будет отрегулировать, чтобы быть ближе к окружающим словам, и для каждого из окружающих слов, чтобы быть ближе к исходному слову.

В этом знаменитом наборе учебных данных:

Король высокий человек.

Королева красивая женщина.

Они сидят вместе в тронном зале замки.

Вектор «король» наклоняется к «мужчине», «королеве» к «женщине» и «трон» к «замку» и т. Д., Умножается в тысячи измерений.

За последовательными итерациями такие слова, как «мужчина» и «женщина», будут расти ближе друг к другу, как и «Король» и «Королева».

Кроме того, обратите внимание, что «мужчина» и «женщина» будет иметь аналогичное расстояние, что и «король» и «королева», что позволит LLM сделать некоторую базовую математику, чтобы еще больше понять отношения между словами.

И поскольку существует так много измерений, перемещение одного слова ближе к другому в одном измерении не обязательно означает, что эти слова будут расти более отдаленными для других слов.

«Когда мы приближаемся к« мужчине »ближе к« женщине », мы не обязательно перемещаем его дальше от« короля », потому что« близость короля к «мужчине», вероятно, находится в другом измерении, чем близость «мужчины» к «женщине», — сказал Момджян.

От данных до интеллекта

Реляционные базы данных действительно предлагают полнотекстовый поиск, но не ищут значение слов. Это сила семантического поиска на основе вектора.

Как правило, в процессе обучения LLM блоки текста могут быть «разбиты» в более короткие отрывки. Их можно войти в предложения, абзацы, или весь отрывок может быть единственным куском.

Семантический поиск в среднем все векторные оценки по каждой части.

Затем генеративный ИИ принимает среднее значение векторов в самом запросе и находит предложение или текстовый кусок с ближайшей оценкой.

Эрго, запрос «Кто король?» будет в среднем наиболее близко к фразе «Король — высокий человек», то есть средний вектор этой фразы является наиболее близким к среднему вектору запроса.

Momjian раскрыл какой -то код SQL, чтобы сделать этот образец, который может быть выполнен с использованием PGVector, расширения вектора в PostgreSQL. Он создал таблицу, чтобы удерживать контент и таблицу для их встраиваний. Скрипт Python Momjian создал вызовы Openai, отправляет каждое слово и получает внедрение. Векторы также усредняются и хранятся в базе данных.

Тогда запрос «Кто король?» через вызов API отправляется через API для OpenAI для внедрения номеров. Это также усредняется, а затем сравнивается со всеми средними значениями в базе данных, которые были ранжированы из наиболее похожая на наименьшие:

Сравнение векторных результатов для ближайшего матча

«Это отличается от полнотекстового поиска, потому что он имеет понимание того, как связаны слова»,-сказал Момцзян.

Генеративный ИИ

Momjian объяснил, что обработка вектора — только первый блок генеративного ИИ. Чтобы создать полные предложения, вам также нужны государственные трансформаторы, тип нейронной сети для обработки естественного языка.

Блок внимания, также впереди Google в 2017 году, является взвешенной версией входного текста. Каждый запрос получает новый блок внимания. Каждое слово просматривается и дается 128 размерного номера из LLM. Каждое слово в входном тексте взвешивается, чтобы быть ближе к другим, слово от слова.

Этот процесс перемещения слов ближе друг к другу в векторизованном пространстве продолжается для множественных итераций, пока не будет произведено полное предложение.

И именно поэтому последняя фраза в вашем ответе CHATGPT часто появляется первым в ответе — «Столица Франции — Париж» — потому что она последняя, которая будет вектором. LLM интерпретирует предложение в обратном порядке:

Колумбус в Огайо. Где Париж?

… может принести вам этот ответ:

Париж во Франции. В Соединенных Штатах также есть город по имени Париж, расположенный в Техасе. Если вы имели в виду другой Париж, укажите!

Ответы также могут быть дополнительно уточнены посредством получения добычи, которая дает LLM дополнительные инструкции, например, чтобы сохранить краткий обзор. В этом случае вопрос о местонахождении Парижа был бы простым ответом, что Париж во Франции.

Вы также можете использовать RAG, чтобы вернуть ответ на вопросы анализа данных. Например, Momjian показал, как вы можете ввести три вставки базы данных SQL в префикс RAG, и он вернет данные, которые была совершена каждая команда, потому что LLM «знает» SQL.

Таким образом, Momjian пришел к выводу, что, хотя скорость развития ИИ действительно ошеломляет, LLM, тем не менее, являются сложной формой манипуляций с данными, а не обладателем какого -либо фактического чувства.

Наслаждайтесь всей презентацией Momjian здесь. Слайды доступны здесь.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Joab Jackson является старшим редактором нового стека, охватывающего облачные нативные вычисления и системы системы. Он сообщил об инфраструктуре и развитии IT более 25 лет, в том числе в IDG и государственных компьютерных новостях. До этого он … читал больше от Джоаба Джексона