Исследователи обнаружили новый «Закон о масштабировании» в области искусственного интеллекта? Это то, что предполагает некоторый шум в социальных сетях — но эксперты скептически настроены.

Законы об масштабировании ИИ, немного неформальная концепция, описывают, как повышается производительность моделей искусственного интеллекта, как размер наборов данных и вычислительные ресурсы, используемые для их обучения. Примерно до года назад увеличение «предварительного обучения»-обучение вечно более широким моделям на наборах данных на постоянно более широких наборах-было доминирующим законом на сегодняшний день, по крайней мере, в том смысле, что большинство пограничных лабораторий ИИ приняли его.

Предварительные тренировки не исчезли, но два дополнительных закона о масштабировании, масштабирование после тренировки и масштабирование времени испытаний, появились, чтобы дополнить его. Масштабирование после тренировки-это по сути настройка поведения модели, в то время как масштабирование времени теста влечет за собой применение большего количества вычислений к выводу-т.е. запуска моделей-для управления формой «рассуждения» (см. Модели, такие как R1).

Исследователи Google и UC Berkeley недавно предложили в статье, что некоторые комментаторы онлайн назвали четвертым законом: «поиск времени вывода».

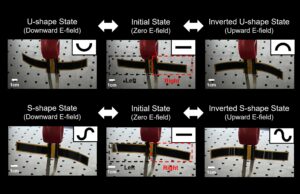

Поиск времени вывода имеет модель, генерирующую много возможных ответов на запрос параллельно, а затем выберите «Лучший» из группы. Исследователи утверждают, что это может повысить производительность годовой модели, такой как Google Gemini 1.5 Pro, до уровня, который превосходит модель «рассуждения» Openai по «рассуждениям» по науке и математике.

Наша статья фокусируется на этой оси поиска и ее тенденциях масштабирования. Например, просто случайным образом отбирая 200 ответов и самооценки, Gemini 1.5 (древняя модель начала 2024 года!) Прерывает O1-Preview и приближается к O1. Это без создания, RL или территористов-не прав и территории земли. pic.twitter.com/hb5fo7ifnh

— Эрик Чжао (@Ericzhao28) 17 марта 2025 г.

«[B]y Просто случайным образом отбирая 200 ответов и самооценка, Gemini 1.5-древняя модель начала 2024 года-бьет O1-просмотр и подходит к O1,-написал Эрик Чжао, докторскую степень в Google и один из соавторов газеты, написал в серии постов на X. «Магия-это самооценка, естественно становится легче в масштабе! Вы ожидаете, что выбор правильного решения становится все труднее, чем больше ваш пул решений, но наоборот имеет место! »

Однако несколько экспертов говорят, что результаты не удивительны, и что поиск времени вывода может быть бесполезным во многих сценариях.

Мэтью Гусдиал, исследователь ИИ и доцент в Университете Альберты, сказал TechCrunch, что подход работает лучше всего, когда существует хорошая «функция оценки» — другими словами, когда лучший ответ на вопрос может быть легко определен. Но большинство запросов не так уж и сушено.

«[I]f мы не можем написать код, чтобы определить, что мы хотим, мы не можем использовать [inference-time] Поиск, — сказал он. — Для чего -то вроде общего языкового взаимодействия мы не можем этого сделать […] Как правило, это не большой подход для решения большинства проблем ».

Майк Кук, научный сотрудник King’s College London, специализирующийся на ИИ, согласился с оценкой Гусдиала, добавив, что он подчеркивает разрыв между «рассуждениями» в смысле этого слова и нашими собственными процессами мышления.

«[Inference-time search] Не поднимает процесс рассуждения модели, — сказал Кук.[I]T просто способ, которым мы работаем над ограничениями технологии, склонной к тому, чтобы сделать очень уверенно поддерживаемые ошибки […] Интуитивно, если ваша модель совершает ошибку в 5% времени, то проверка 200 попыток в той же проблеме должна облегчить обнаружение этих ошибок ».

Этот поиск времени вывода может иметь ограничения, несомненно, станет нежелательными новостями для индустрии искусственного интеллекта, стремящейся к масштабированию модели «рассуждений» вычислительно эффективно. Как соавторы бумажной заметки, модели рассуждений сегодня могут нарастить тысячи долларов вычислительных вычислений по одной математической задаче.

Кажется, что поиск новых методов масштабирования будет продолжаться.