Качество данных развивалось от «хорошего к имеющейся до существенной и, в некоторых случаях, критически важной части операции данных. Когда ИИ начал набирать обороты, во многих руководствах по управлению данными и наукой о данных было написано написание на стене. Истотное поле выравнивается, и те, кто может правильно извлечь выгоду из своих данных, выиграют с новыми вариантами использования. Компании, которые недостаточно инвестируют в качество данных, пытаются не отставать.

Первоначально ИИ рассматривался как серебряная пуля, обещая автоматизировать сложные процессы и легко обрабатывать большие объемы данных. Тем не менее, стало ясно, что без стратегической структуры ИИ может быть столь же проблематичным, насколько это полезно.

Вкратце, казалось, что мы могли бы преодолеть классическую проблему «мусора, мусора» по масштабу. Тем не менее, недавнее замедление в самых больших моделях показывает, что существуют ограничения. Объем учебных данных имеет важное значение, но качество данных быстро становится дифферентором.

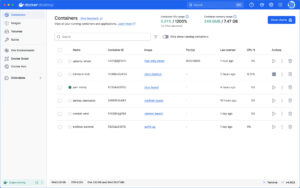

Качество данных в современном стеке данных

Организации запускали программы качества данных на протяжении десятилетий. Руководства, лучшие практики и эксперты расскажут вам, как писать правила качества данных, развернуть их и расставить приоритеты в различных частях вашего стека. Итак, это должно быть легко, верно?

К сожалению, современный ландшафт данных совсем не прост. То, что работало десять лет назад, когда у каждой компании было одно хранилище данных или базу данных центрального предприятия с несколькими взаимосвязанными системами, больше не масштабируется.

Вместо того, чтобы иметь дело с парой систем и форматов данных, предприятия должны иметь дело с ландшафтами данных, содержащими сотни или тысячи различных систем данных. В то время как технологии для увеличения обработки в шкалу петабайта доступны (если у вас достаточно денег), недавний толчок к демократизации данных означает, что сложность данных собирается взрываться.

Это широко признанная проблема. Gartner даже реклассифицировал свой магический квадрант для решений для качества данных в качестве дополнительных решений для качества данных, добавив акцент на автоматизацию и масштаб.

Письмо на стене. Чтобы выиграть гонку ИИ, вы должны переосмыслить, как приблизиться к качеству данных.

ИИ исправят… ИИ?

В старые времена, чтобы управлять растущей сложностью, вы наняли больше людей, чтобы позаботиться о большем количестве систем. Этот подход работал в течение многих лет и привел к тому, что целые отделы инженеров данных создавали правила качества данных, конфигурации и отчеты. Этот подход больше не масштабируется, но, к счастью, современная революция LLM наступила в нужное время.

Рассмотрим следующий вариант использования. CHATGPT использовался для решения проблем качества данных в базе данных пользовательских взаимодействий из различных приложений, чтобы подготовить ее к модели искусственного интеллекта, которая предоставит персонализированные рекомендации. Он показывает, как мы можем использовать ИИ для исправления данных для ИИ.

В этом примере нам просто нужно запускать этот запрос каждый день, когда появляются новые данные и запускать его и в других наших системах, охватывая различные источники данных и различные объемы данных …

Вы, вероятно, можете увидеть проблему здесь, и она не изолирована.

Рассмотрим, что зависимость от LLMS для автоматизации комплексного очищения данных без надлежащего надзора, что часто приводит к ошибкам и несоответствиям, которые проявляются только в масштабе. Даже приведенный выше пример хорошо работает на конкретных случаях использования, но будет бороться с масштабными, последовательностью и галлюцинациями.

ИИ исправят ИИ … но это не так просто

ИИ не может масштабироваться, используя только свою необработанную мощность в его текущей форме. Вы должны быть преднамеренными в том, где и как его использовать. Запуск обработки ИИ на основе LLM на тысячах источников и петабайт данных невозможно. Тем не менее, мы знаем, как устранить растущие объемы данных, так как существуют подходы больших данных, которые могут работать практически в любом масштабе; Они просто должны быть настроены правильно. Итак, что, если мы зададим Чатгпт другой вопрос?

В этом сценарии модель было предложено написать правила качества данных. Вместо полного набора данных он получил только образец и был предложен предложить правила, которые будут запускаться поверх данных.

Правила, предложенная моделью, являются примерами логики, которые можно использовать повторно с предсказуемыми результатами. Правила масштабируются для любого размера и источника данных, если они реализованы в подходящей технологии обработки.

Эта подсказка должна будет работать только тогда, когда источник данных или профиль значительно изменяется. Вы можете взять этот список вновь сгенерированных правил качества данных и использовать его в качестве ввода для отображения правил, применяя его к другому набору данных без необходимости повторного генерации логики правил. Это масштабируется намного лучше, чем просить ИИ обнаружить проблемы в ваших данных.

Конечно, есть предостережения. Проблемы с предсказуемостью и галлюцинациями не устраняются, и масштабирование их для больших ландшафтов данных также создает некоторые проблемы с оркестровками.

Используйте ИИ намеренно

Правильное применение LLM для качества данных является стратегическим императивом. LLM обладают огромным потенциалом для революционизации практик качества данных, но только при использовании точно и намеренно.

Организации должны взаимодействовать с ИИ в рамках более широкой, хорошо продуманной стратегии управления данными. Успешная интеграция LLMS в процессы качества данных требует четкого понимания как возможностей этих моделей, так и уникальных проблем вашего ландшафта данных.

Поскольку мы смотрим в будущее, остается вопрос: как вы будете адаптировать свои стратегии качества данных, чтобы ответственно и эффективно использовать весь потенциал ИИ?

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Marek Ovcacek, полевой технический директор Ataccama, имеет почти два десятилетия опыта в технологической индустрии. Благодаря глубокому опыту в качестве качества данных, управлении основными данными и управлением данными, он тесно сотрудничает со стратегическими клиентами, чтобы помочь им извлечь ценность из … Подробнее из Marek Ovcacek