Команда из Pathway считает, что архитектура трансформатора, разработанная восемь лет назад, достигла своих пределов, которые не могут преодолеть никакие вычисления. Нет и сил, чтобы поддержать себя. Кроме того, отсутствует временное мышление и постоянное обучение.

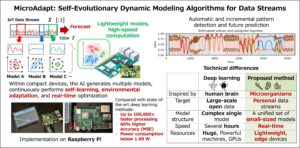

Итак, как обсуждалось в исследовательской статье Pathway, опубликованной в сентябре, и в нашем интервью на AWS re:Invent, компания строит пограничную модель эпохи посттрансформаторов, основанную на нейронной динамике с учетом драконов — архитектуру «Драконий детеныш», вдохновленную 20-ваттным человеческим мозгом.

«У вас есть нейроны, которые связаны друг с другом и разговаривают друг с другом», — сказала генеральный директор Pathway Зузанна Стамировска. «И как только в систему поступает новый бит информации – а он может продолжать поступать с течением времени, как и у людей – заинтересованные нейроны активируются, и те, кто связан с ними, могут активироваться вместе с ними».

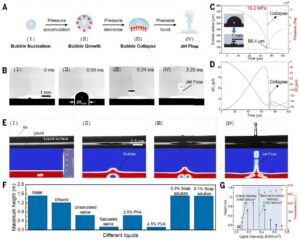

Совместная активация нейронов интегрирует обучение Хебба — концепцию, согласно которой «нейроны, которые срабатывают вместе, соединяются вместе». И эта маленькая информация? Pathway называет это разреженной активацией; это ключ к пониманию подхода компании. Согласно исследованию, которое я цитировал ранее, это означает, что в модели детеныша дракона срабатывает около 5% нейронных связей. Остальные 95% хранят молчание.

Доминирование и ограничения архитектуры-трансформера

Архитектура-трансформер обеспечивает работу больших языковых моделей от GPT до Claude с помощью механизмов внимания. Это позволяет модели взвешивать важность разных слов в предложении или документе, помогая обрабатывать и управлять контекстом и связями между словами.

Трансформаторные технологии достигли очень многого, повлияв на то, как мы живем и работаем. Просто его энергопотребление непостоянно, а производительность постепенно улучшается.

Рассмотрим, как трансформер учится во время обучения. Он видит закономерности тысячи или миллионы раз, используя градиентный спуск. Этот процесс требует повторения за повторением, пока система не поймет то, чему маленький ребенок или любой человек учится всего за один опыт.

«Сколько раз вам приходилось пробовать мыло в детстве?» – спросила Стамировская. «Один раз, максимум два. Но чтобы модель-трансформер почувствовала вкус мыла, это буквально [needs] тысячи или миллионы раз, чтобы изменить веса в модели, чтобы она могла сказать: «О, это [how] вкус мыла».

Проблема временной слепоты в трансформерах

По словам Стамировской, у нынешних архитектур есть ограничения, которые не решает масштабирование.

Существует проблема временной слепоты. «По определению, у трансформеров нет понятия времени», — сказала она. «Они не видят последовательности событий, которые обычно приводят нас к выводам: что-то хорошо, что-то плохо».

Например, в обучающих моделях собирается огромный объем данных, а затем перед обучением данные подвергаются процессу, аналогичному блендеру.

Вот где это становится сложнее. Обучение проводится параллельно. Все временные данные удаляются. Никакой последовательности, только параллелизм. Все токены просматриваются одновременно, а не в порядке времени. Цель: максимизировать пропускную способность. Недостаток: концепция времени становится измерением, которое модель не учитывает ради скорости.

«Для любого приложения, использующего временные рассуждения — от прогнозирования рынка до мониторинга системы — это фундаментальный недостаток», — сказала Стамировска.

Как память и непрерывное обучение бросают вызов магистратуре

Тогда есть проблема с памятью. Постоянное обучение не поддерживается так, как учатся люди. Знаете ли вы, что горячая плита может обжечь вас? Почему? Моя биологическая система говорит мне об этом.

«Преобразователи LLM не смогут объединить память и время. Типа, своего рода обучение и своего рода обобщение с течением времени. Они хотят это сделать».

И все это ужасно неэффективно.

Модель-трансформер обучается по градиентному спуску. Любое обучение происходит постепенно. Может потребоваться 10 000 документов, чтобы выучить что-то, что ребенок поймет, выучив что-то всего один раз.

Подход Pathway использует память в контексте нейробиологии. Это другая форма обучения по сравнению с моделями-трансформерами.

«Если два нейрона вспыхнут, связь между ними станет сильнее, верно?» — сказала Стамировская. «И эти связи, по сути, являются памятью системы».

Временная структура сохраняется, а не отбрасывается. В результате получается система, напоминающая мозг, известная как посттрансформаторная архитектура, которая работает в масштабе графического процессора и, как сказала Стамировска, работает «фактически на уровне трансформаторов».

Представляем архитектуру детеныша дракона от Pathway

У Pathway есть команда с признанным опытом работы в области искусственного интеллекта. Технический директор Ян Чоровски работал с Джеффри Хинтоном, лауреатом Нобелевской премии. Хоровски, один из первых, кто применил внимание к распознаванию речи, провел исследование, которое совпало с появлением механизмов внимания и последующим развитием этой области.

Адриан Косовски возглавляет исследования и разработки Pathway. Косовский — квантовый физик, ученый-компьютерщик и математик, специализирующийся на сложных системах.

Стамировска работала в Институте сложных систем в Париже, применяя динамику частиц для решения задач прогнозирования, что соответствует подходу, который они использовали в своих механизмах обучения.

Pathway создала платформу обработки потоков, получившую более 100 000 звезд на GitHub. По словам Стамировской, такие организации, как WhatsApp и НАТО, используют платформу искусственного интеллекта.

Драконы служат названиями моделей Pathway. Компания называет свою архитектуру Dragon Hatchlings, потому что драконам нужно гнездо. В гнезде дракона Pathway есть все разъемы для «детенышей».

Гнездо для вылупившихся детенышей поддерживается Pathway’s Live Data Framework, платформой Python ETL (извлечение, преобразование, загрузка) для потоковой обработки, аналитики в реальном времени, конвейеров больших языковых моделей (LLM) и генерации с расширенным поиском (RAG). По словам Стамировской, это механизм инкрементной обработки данных, использующий Apache Spark, который может обрабатывать потоковую передачу с малой задержкой с помощью того же API Python.

Ученые, работающие с данными, могут писать код на Python, который преобразуется в Rust с помощью механизма инкрементальной обработки данных, независимо от скорости, с которой данные поступают в систему.

По ее словам, это сравнимо с Apache Flink, но больше похоже на Apache Spark на стероидах. И именно так их платформа получит признание в корпоративной среде.

Гнездо готово. Теперь пришло время вылупиться Драконам.

Архитектура Dragon Hatchling включает память как часть модели. Напротив, архитектура трансформатора разделяет память. Вся модель не просматривается, только соответствующие нейронные коннекторы. И он не забывает: например, добавьте электронную таблицу, и модель ее запомнит.

Архитектура Pathway отражает инновации в архитектуре in-memory, появившиеся за последнее десятилетие. Виктор Щерба, сейчас работающий в команде Pathway, руководил выводом на рынок SAP HANA, базы данных, хранящейся в оперативной памяти.

«Состояние на самом деле встроено в платформу… оно встроено в саму карту обучения, потому что оно поддерживается синаптическим типом связей», — сказала Стамировска. «Так что это действительно похоже на то, что у трансформатора есть память по определению. По сути, это то, что мы имеем».

Эффективный подход к обработке данных, вдохновленный нейронаукой

Есть и другие концепции, о которых Стамировска говорила в нашем интервью, о том, как традиционные трансформаторы потребляют много энергии, постоянно запуская миллионы и миллиарды параметров.

Pathway решает эту проблему немного по-другому. Он опирается на нейронные связи, которые позволяют повысить эффективность работы в памяти.

«Поэтому, когда вы активируете те связи и нейроны, которые вам нужны, вы не всегда активируете огромные, плотные матрицы», — сказала она. «Потенциально у вас может быть довольно большая модель, потому что вы можете хранить в структуре довольно много данных, но используете только очень небольшую часть».

Подход Pathway развивает представление о прогрессе ИИ за пределами его корней-трансформеров.

Подводя итог, можно сказать, что подход Pathway эффективен при использовании данных. Он обеспечивает временные рассуждения и использует минимальное количество энергии (подумайте о возбуждении нейронов по сравнению с мегаваттами центров обработки данных). Модель – это память. И он может интерпретировать, основываясь на связях, которые он устанавливает с конкретными понятиями.

Компромиссы? Их много. Во-первых, у трансформаторов есть преимущество с их восьмилетней историей. Многое можно написать об инфраструктуре, моделях и экосистеме инструментов. Напротив, технология Dragon Hatchling представляет собой другой тип архитектуры по сравнению с системами на основе трансформаторов.

Будущее искусственного интеллекта после эры трансформаторов

Трансформаторы могут быть расточительными, но сопоставление с образцом имеет успешный опыт. И только до недавнего времени разговор начал переходить на темы не только о трансформерах.

Есть ли стремление к переменам? Некоторые знаки есть. Как сказала Стамировска: «Исследователю искусственного интеллекта было очень трудно сказать, что он или она не работает над трансформаторами… На самом деле это не было популярно примерно два месяца назад».

На этом этапе это становится скорее философским вопросом. Каково будущее ИИ, если подходы, основанные на трансформаторах, на самом деле не являются устойчивыми?

Эпоха трансформаторов принесла значительные достижения, но она также породила бушующее пламя, которое невозможно утолить. Возможно, нам действительно нужно лететь на драконах высоко над расплавленным ландшафтом.

ТЕНДЕНЦИОННЫЕ ИСТОРИИ YOUTUBE.COM/THENEWSTACK Технологии развиваются быстро, не пропустите ни одной серии. Подпишитесь на наш канал YouTube, чтобы смотреть все наши подкасты, интервью, демонстрации и многое другое. ПОДПИСАТЬСЯ Группа, созданная в Sketch. Алекс Уильямс — основатель и издатель The New Stack. Он давний технологический журналист, работавший в TechCrunch, SiliconAngle и в компании, которая сейчас известна как ReadWrite. Алекс работает журналистом с конца 1980-х годов, начиная с… Читать далее от Алекса Уильямса