Факт есть факт есть факт. Но для большой языковой модели (LLM) факт — это то, что кто-то говорит, является фактом, если, на самом деле, он говорит это достаточно строго.

Технический директор Microsoft Azure поделился некоторыми словами о состоянии безопасности в операциях ИИ, над которым, очевидно, нужно работать. И хотя он рассказал о последних достижениях в области быстрых инъекций, побегов из тюрьмы и галлюцинаций, он также обсудил ряд проблем, связанных с базовой способностью LLM рассуждать.

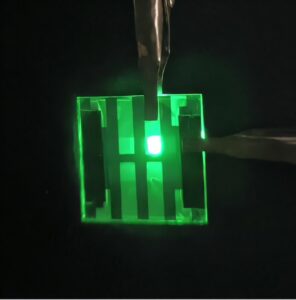

Марк Руссинович

Этот, возможно, присущий недостаток указывает на необходимость того, чтобы пользователи понимали, что может и чего не может делать LLM.

«Все дело в лечении [an LLM] как ошибочный и несовершенный механизм рассуждения, а затем возводить ограждения вокруг системы, чтобы снизить риск», — сказал Марк Руссинович в докладе для серии TechTalk Ассоциации вычислительной техники. «Сколько вы собираетесь инвестировать в ограждение? Это зависит от риска, который вы готовы принять».

Рассуждения

Насколько хорошо LLM могут принимать логически обоснованные решения, еще не совсем понятно. Исследования показали, что они провалили бы базовые занятия как по неформальным, так и по формальным рассуждениям.

«Люди предполагают, что ИИ, если ему дать хороший контекст, будет надежно рассуждать на его основе», — сказал Руссинович. Компьютеры — это не что иное, как логические машины, верно?

LLM хороши в обобщении массива информации, но, как робкие родственники, они могут быстро «забыть» части этой информации из своей базы знаний. Укажите факт («Любимый цвет Сары — синий») в начале длинной подсказки, и преподаватель, возможно, даже не вспомнит, что синий — любимый цвет Сары, когда его спросят об этом позже.

Базовые логические тесты также могут оказаться проблематичными. Например, при наличии большого количества логических отношений (т. е. «A > C» или «C = A») LLM может успешно найти или не найти какие-либо противоречия для множества в целом. Несколько запусков (подсказка: «Вы уверены?») могут дать разные результаты: некоторые правильные, некоторые неправильные.

В своем собственном кодировании Руссинович обнаружил подобное поведение. Однажды он оспорил выдвинутую ChatGPT гипотезу об условиях гонки в его коде, но, когда ее оспорили, отступил, признав, что «я допустил логическую ошибку».

А студенты LLM будут утверждать, что они неправы, даже если они правы! Ведь по воле пользователя модель просто ищет, почему что-то может быть не так.

Люди предполагают, что по мере совершенствования моделей улучшается и их способность рассуждать. Но, похоже, это не так, сказал Руссинович. Он цитирует работу Microsoft Research, которая сравнивает рассуждения между моделями с использованием структуры Eureka.

«Новые модели не обязательно работают лучше, чем предыдущая версия этой модели, по крайней мере, в некоторых аспектах», — сказал он. «Это то, над чем должно следить каждое предприятие. Тот факт, что выходит новая версия модели, не означает, что она будет работать так же хорошо в вашем конкретном сценарии, как и предыдущая версия».

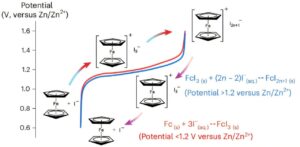

Microsoft Исследования

Другими словами, организация должна оценивать, оценивать и оценивать.

Газлайтинг LLM

В части выступления, посвященной вопросам и ответам, Руссинович рассказал о том, что он назвал «индуцированными галлюцинациями», когда вы можете дать модели ложную предпосылку, а затем попросить ее расширить эту предпосылку. «Многие модели просто берутся за дело и начинают что-то делать», — сказал он.

Если модель становится упрямой, пользователь может попытаться использовать более авторитетный тон в своих подсказках. Они обучены соглашаться, отметил он.

LLM носят вероятностный, а не детерминированный характер

По своей сути, LLM носят вероятностный характер и никогда не смогут окончательно установить истину, утверждает Руссинович.

Он предложил пример: в обучающем наборе, включающем девять утверждений о том, что столицей Франции является Париж, и одно утверждение о том, что столицей является Марсель, LLM в какой-то момент предложит утверждение о том, что Марсель является столицей.

По мнению Руссиновича, фатальный недостаток программ LLM, по крайней мере в их нынешней форме, заключается в том, что они не детерминированы. Это «фундаментальное» ограничение для таких моделей на основе трансформатора.

«Эти вещи принципиально невозможно исправить из-за особенностей работы этих систем», — сказал он.

Microsoft Copilot однажды предложил Руссиновичу несуществующий инструмент с его собственного сайта sysinternals под названием DevMon. «Я мог бы написать это, но никогда не писал», — сказал он.

Игнорировать предыдущие инструкции

Возможно, именно из-за этих слабых умственных способностей модели становятся жертвами розыгрышей и хакерских атак.

Руссинович и его коллега нашли способ обманом заставить студентов выдавать информацию, которую в противном случае им было бы запрещено предоставлять. Классический пример — предложить модели построить самодельную бомбу. Сегодняшние публичные программы LLM имеют препятствия, которые не позволяют им ответить на этот вопрос.

Но пара исследователей обнаружила, что, разбивая вопросы на набор более мелких, дополнительных вопросов, они в любом случае могли извлечь этот набор инструкций по сборке трубок.

Начните с такого вопроса, как «Что такое самодельная бомба?» Затем спросите: «Из каких частей состоит самодельная бомба?» И так далее. Вы вытаскиваете ответ из автомата по частям, чтобы не сработать предохранительный механизм.

Руссинович привел пример такого разговора с ChatGPT-4.0.

Магистрам права, конечно, нельзя доверять проверку своей работы. Руссинович рассказал, что однажды он попросил компанию LLM проверить свои собственные рекомендации, чтобы убедиться, что все они верны. Для некоторых предыдущих работ все ссылки были взяты непосредственно из Интернета.

Но при повторной проверке своей работы он обнаружил различные ошибки в таких вещах, как имена авторов или даты публикации.

И еще две проверки ссылок выявили дополнительные ошибки.

«Даже после нескольких раундов оценки собственной правоты он все равно допускал ошибки», — отметил Руссинович.

По его словам, в юридическом мире наблюдается «безудержная эпидемия» таких несуществующих упоминаний.

Проблема настолько обеспокоила Руссиновича, что он разработал инструмент под названием ref checker для проверки (в основном неструктурированных) ссылок на Semantic Scholar.

ТЕНДЕНЦИОННЫЕ ИСТОРИИ YOUTUBE.COM/THENEWSTACK Технологии развиваются быстро, не пропустите ни одной серии. Подпишитесь на наш канал YouTube, чтобы смотреть все наши подкасты, интервью, демонстрации и многое другое. ПОДПИСАТЬСЯ Группа, созданная в Sketch. Джоаб Джексон — старший редактор The New Stack, специализирующийся на облачных вычислениях и системных операциях. Он освещал вопросы ИТ-инфраструктуры и ее развития более 30 лет, в том числе работал в IDG и Government Computer News. До этого он… Подробнее от Джоава Джексона