Последние несколько лет показали, что крупные языковые модели (LLMS) обладают впечатляющими возможностями в анализе, понимании и генерировании текста по-человечески, и они все чаще вступают в повседневную жизнь людей, к лучшему или к худшему.

Но даже самые мощные LLM имеют ограничения, особенно когда речь идет о задачах, которые требуют двунаправленных и долгосрочных рассуждений, сложного планирования и поддержания когерентности по сравнению с расширенными контекстами. Эти ограничения возникают потому, что многие из текущих LLM основаны на статистической технике, называемой авторегрессией, что означает, что они предназначены для обработки и прогнозирования текстовых токенов последовательными, слева направо. При более сложных задачах вычислительные требования и потенциал для задержки значительно увеличиваются.

Тем не менее, в настоящее время существует растущее число крупных языковых моделей на основе диффузии, которые делают свой след, бросая вызов авторегрессивной парадигме, лежащей в основе многих современных LLM.

Dream 7B — одна из таких диффузионных языковых модели (DLM), которая использует тот же подход, что и диффузионные модели, которые генерируют изображения. Созданы исследователями из Университета Гонконга и лаборатории Ноя в Huawei, Dream 7b (который означает ДюймовыйМФФУСА Профильпредложение МODEL) является одним из самых мощных открытых диффузионных LLM на сегодняшний день, соответствующий или даже превышающий современные авторегрессивные модели (оружие) аналогичного размера по общим задачам, математике и кодированию.

Авторегрессия против диффузии

В отличие от традиционных авторегрессивных языковых моделей, которые последовательно генерируют выходы, модели диффузионного языка будут постепенно «отменять» последовательность слов, которые первоначально скрываются шумом. Это тот же метод, который используется на основе диффузии моделей ИИ, генерирующих изображение, и в обоих случаях этот процесс отменения происходит параллельно, что означает, что он намного быстрее, чем последовательный, пошаговый подход авторегрессивных моделей.

Как модель на основе диффузии отступает, чтобы получить выход (источник).

Благодаря этой параллельной обработке токенов Dream 7B работает значительно лучше, чем его авторегрессивные аналоги в этих областях:

- Двунаправленное моделирование контекста: Dream 7b имеет более целостное представление о рассмотрении контекста слова в предложении. Вместо того, чтобы просто анализировать фразу однонаправленным образом, Dream 7B может одновременно оценивать как начало, так и конец предложения, повышая точность, контекстуальную осведомленность и удержание, а также расширение когерентности для более сложных задач.

- Гибкий генерация текста: Текст может быть сгенерирован в любом случайном порядке, а не последовательно. Это означает, что диффузионные модели, такие как Dream 7B, лучше подходят для более широкого диапазона приложений, таких как завершение текста, заполнение и контролируемое генерацию.

- Улучшенные способности планирования: Способность рассуждать и планировать несколько этапов или решение проблем с несколькими параметрами, заметно повышена по сравнению с руками.

- Динамический контроль: Dream 7B позволяет пользователям регулировать количество шагов в процессе диффузии, чтобы оптимизировать качество выходных данных и вычислительную эффективность.

Архитектура и особенности Dream 7b

По словам исследователей, архитектура Dream 7B основана на предыдущей работе команды в репараметрированных дискретных диффузионных моделях (RDM), которая внедряет другой статистический подход, который упрощает обучение и обеспечивает гибкую выборку.

Авторегрессивный вес инициализация

Кроме того, Dream 7b расширяет новые улучшения, лежащие в основе Diffullama, используя стратегию этой модели в чтении определенных элементов и обучающих парадигм авторегрессивных моделей в модели диффузионного текста. Это означает, что вместо обучения модели с нуля Dream 7B инициализировалась с использованием весов модели от QWEN2.5 7B, что сократило время и стоимость обучения.

Команда также обнаружила, что уровень обучения является существенным фактором в обеспечении того, чтобы знания языка были сохранены на стадии инициализации, без впоследствии ингибируя процесс обучения диффузии.

«Если скорость обучения установлена слишком высокой, он может быстро смыть знания слева направо в начальных весах, оказывая небольшую помощь в обучении диффузии; в то время как, если оно установлено слишком низким, это может препятствовать диффузионному обучению»,-объяснила команда.

«Мы тщательно выбрали этот параметр вместе с другими параметрами обучения. Благодаря существующим знаниям слева направо в модели авторегрессии можно ускорить обучение диффузионной модели», что значительно уменьшило токены и вычисления, необходимые для предварительного обучения ».

Контекст-адаптивный механизм на уровне токенов

Другое инновации, представленное Dream 7B, представляет собой механизм, адаптируемый на уровне контекста, который динамически наполняет уровень шума для каждого токена в зависимости от его контекста.

В отличие от других парадигм диффузионных тренировок, которые применяют однородные уровни шума для всего предложения, это более целенаправленный и детальный подход, который помогает модели учиться более эффективно и генерировать более точные результаты, которые учитывают окружающий контекст.

Как складывается Dream 7b?

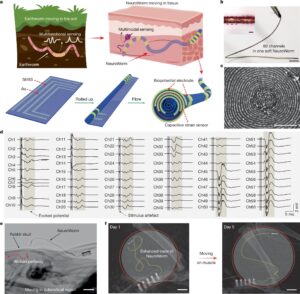

Оценка Dream 7b против известных авторегрессивных моделей, таких как Llama3 8b и qwen2.5 7b в общих языковых задачах, математических рассуждениях и генерации кода, команда обнаружила, что производительность Dream 7b либо соответствовала или превысила результаты этих традиционных LLM.

Кроме того, команда обнаружила, что возможности Dream 7B значительно превзошли возможности моделей аналогичного размера в таких задачах, как Countdown и Sudoku, которые требуют сложных рассуждений и интенсивного планирования.

«В нашей предыдущей работе мы продемонстрировали, что диффузия текста демонстрирует превосходные возможности планирования в небольшом, конкретном контексте задачи»,-отметила исследовательская группа. «Однако остается неясным, обладает ли общая масштабированная диффузионная модель с одинаковыми способностями. Теперь, с Dream 7B, мы можем лучше ответить на этот вопрос».

Примеры QWEN 2,5 7B и Dream 7B в трех задачах планирования.

Глядя в будущее: больше диффузии LLMS

Модели генерации текста на основе диффузии, такие как Dream 7B, только недавно появились, но они уже готовы в будущем увеличить доминирование авторегрессии LLMS. Поскольку поле ИИ продолжает развиваться и расти, модели диффузии языка могут потенциально стать следующей стадией эволюции для воплощенного ИИ, автономных агентов ИИ и систем принятия решений, которые требуют обширного долгосрочного планирования и организации.

Узнайте больше на странице проекта Dream 7B и ознакомьтесь с репозиторием модели на GitHub.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Кимберли Мок — репортер технологий и дизайна, который охватывает искусственный интеллект, робототехнику, квантовые вычисления, техническую культуру и научные истории для нового стека. Обученная как архитектор, она также является иллюстратором и междисциплинарным дизайнером, который был увлечен … Подробнее от Kimberley Mok