Многие из самых известных сегодняшних языковых моделей (LLM) являются авторегрессивными моделями искусственного интеллекта, которые предназначены для последовательного создания текста, часто слева направо.

Но есть новые и потенциально более эффективные и более быстрые претенденты LLM, которые сейчас выбирают методы на основе диффузии для создания текста, а не проверенных методов авторегрессии.

Более известные благодаря созданию визуальных изображений с помощью диффузионных моделей искусственного интеллекта, таких как стабильная диффузия и Midjourney, модели искусственного интеллекта на основе диффузии для генерации текста теперь привлекают внимание благодаря их сравнительной эффективности и скорости.

Одним из последних появлений является LLADA (большая языковая распространение с маскировкой), LLM, разработанной группой ML в Китайском университете Ренмина.

Динамическая маскировка

LLADA использует динамический подход маскирования, который позволяет модели прогнозировать несколько токенов одновременно и, в частности, в двухстороннем направлении.

Этот метод отличает LLADA от своих авторегрессивных двоюродных братьев, потому что, хотя методика авторегрессии обычно работает довольно хорошо для коротких последовательностей текста, ауторегрессивные модели (руки) представляют некоторые ограничения вычислительной эффективности и двунаправленных рассуждений, когда речь идет о создании более длинных, более сложных последовательностей.

Как правило, руки работают, прогнозируя слова последовательно, что означает, что по мере роста контекста окна растут, необходимы более сложные вычисления, что приводит к значительным узким местам и проблемам с задержкой.

Кроме того, обычные авторегрессивные модели страдают от того, что известно как проклятие реверса, или неспособность авторегрессивных LLM рассуждать назад на причинно -следственные высказывания, на которых они ранее были обучены. Другими словами, эти модели узнают, что A I IS B, но будет изо всех сил пытаться сделать вывод, что B также является их последовательным характером.

Как работает Llada

Основное преимущество LLADA заключается в том, что он использует многоэтапную процедуру, которая также работает как в прямом, так и в обратном направлениях.

«В отличие от традиционных авторегрессивных моделей, LLADA использует маскированную диффузионную модель (MDM), которая включает в себя дискретный процесс случайного маскирования и обучает предиктора маски для приближения своего обратного процесса», — написала команда в своем исследовательском документе.

LLADA вовлекается сначала в прямом процессе, который постепенно маскирует токены в последовательности, а затем будет проходить обратный процесс, который использует ванильный трансформатор для одновременного «De-Mask», предсказанных токенов. Он похож на процесс диффузии для генерации изображений, где ввод, постепенно разбитый, для генерации конечного изображения.

- Фаза перед тренировкой: Модель учится отменять и реконструировать текстовые сегменты на 2,3 триллиона токена, которые были случайным образом замаскированы. Это позволяет изучать общие закономерности в языке, предсказывая следующее наиболее вероятное слово с помощью самоотверженного обучения.

- Наблюдаемая фаза точной настройки: Затем модель затем дополнительно уточняется с использованием паров инструкций-ответа, где маскируется часть отклика. Это помогает повысить его способность реагировать на инструкции и генерировать когерентные результаты, которые могут быть специфичными для определенной области знаний, а также помогают поддерживать двунаправленное понимание.

- Генерация текста: Модель начинается с выходных полей, которые замаскируются, а затем уточняет свои прогнозы посредством итеративного процесса переосмысления. На каждом этапе диффузии модель предсказывает все токены в масках одновременно, и прогнозы, которые не имеют высокого уровня уверенности, переосмысливаются, так что модель может переоценить их. Этот процесс разжигания и повторного мазыки проводится снова и снова, пока не будет создано что-то согласованное.

Как писала исследовательская группа: «Распределение моделей LLADA через процесс маскировки прямого маскирования данных и обратный процесс, параметризованный ванильным трансформатором для прогнозирования токенов замаскированных».

Чтобы повысить точность модели, был использован алгоритм оценки правдоподобия, отметил команду: «Оптимизируя границу правдоподобия, он обеспечивает принципиальный генеративный подход для вероятностного вывода».

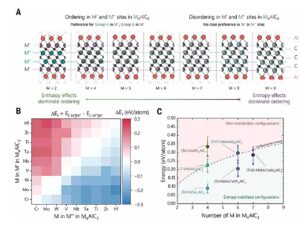

LLADA демонстрирует значительную производительность по сравнению с ламой и сильной масштабируемостью. (Источник: «Модели диффузии больших языков», ML Group в Китайском университете Ренмина.)

При оценке эффективности модели параметров 8 миллиардов исследователей обнаружили, что LLADA имеет относительно впечатляющие результаты в двунаправленных рассуждениях.

Например, в тесте на завершение либо следующей, так и предыдущей строки хорошо известной стихотворения, LLADA была наравне с GPT-4 на генерации текста в прямом направлении, достигнув 42% на обратном генерации текста (изменение) по сравнению с 32% для GPT-4.

Аналогичные результаты были замечены с помощью генерации кода, математических и научных задач, где LLADA стала лучше по ряду критериев, чем сопоставимые авторегрессивные модели примерно такого же размера. Кроме того, LLADA демонстрирует аналогичную производительность со своими кузенами авторегрессии того же размера модели, но использует гораздо меньше жетонов.

В конечном счете, на основе диффузии крупных языковых моделей, таких как LLADA и «Меркурий Лаборатории», могут представить себе новое направление для LLMS, с потенциальными альтернативами на основе диффузии-или даже гибридными моделями-которые бросают вызов доминированию текущих оружия.

Это может означать значительные скачки вперед для разговорного ИИ, генерации кода и сложных, двунаправленных рассуждений, особенно когда речь идет о масштабировании этих систем на основе диффузии-все это с повышением эффективности и скорости и улучшением понимания контекста.

Узнайте больше в документе команды, Project Page и на GitHub.

Trending Stories youtube.com/thenewstack Tech движется быстро, не пропустите эпизод. Подпишитесь на наш канал YouTube, чтобы транслировать все наши подкасты, интервью, демонстрации и многое другое. Группа подпишитесь с эскизом. Кимберли Мок — репортер технологий и дизайна, который охватывает искусственный интеллект, робототехнику, квантовые вычисления, техническую культуру и научные истории для нового стека. Обученная как архитектор, она также является иллюстратором и междисциплинарным дизайнером, который был увлечен … Подробнее от Kimberley Mok