Исследователи MIT обучили агентов искусственного интеллекта играть в игры Atari, которые были изменены, чтобы включить некоторую непредсказуемость. Кредит: Хосе-Луис Оливарес, MIT

Домашний робот, обученный выполнять домашние задачи на фабрике, может не ударить эффективно вычистить раковину или убрать мусор при развертывании на кухне пользователя, поскольку эта новая среда отличается от своего учебного пространства.

Чтобы избежать этого, инженеры часто пытаются соответствовать моделируемой учебной среде как можно ближе к реальному миру, где будет развернут агент.

Тем не менее, исследователи из MIT и в других местах обнаружили, что, несмотря на эту традиционную мудрость, иногда обучение в совершенно другой среде дает лучшего агента искусственного интеллекта.

Их результаты показывают, что в некоторых ситуациях обучение моделируемого агента ИИ в мире с меньшей неопределенностью или «шумом» позволило ему работать лучше, чем конкурирующий агент ИИ, обученный в том же, шумном мире, который они использовали для тестирования обоих агентов.

Исследователи называют это неожиданным явлением эффектом тренировок в помещении.

«Если мы научимся играть в теннис в внутренней среде, где нет шума, мы могли бы более легко освоить различные снимки. Тогда, если мы перейдем в более шумную среду, например, ветреный теннисный корт, у нас может быть более высокая вероятность Из игры в теннис хорошо, чем если бы мы начали учиться в ветреной среде », — объясняет Серена Боно, научный сотрудник MIT Media Lab, и ведущий автор статьи о эффекте обучения в помещении.

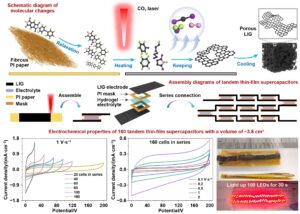

Исследователи изучили это явление, обучая агентов ИИ играть в игры Atari, которые они модифицировали, добавив некоторую непредсказуемость. Они были удивлены, обнаружив, что эффект обучения в помещении последовательно происходил в играх Атари и вариациях игр. Выводы есть опубликовано на arxiv Сервер препринта.

Они надеются, что эти результаты подпитывают дополнительные исследования для разработки лучших методов обучения для агентов искусственного интеллекта.

«Это совершенно новая ось, о которой нужно думать. Вместо того, чтобы пытаться соответствовать средам обучения и тестирования, мы можем построить моделируемые среды, где агент ИИ учится еще лучше»,-добавляет соавтор Спандан Мадан, аспирант в Гарвардский университет.

Боно и Мадан присоединяются к газете Ишаан Гровер, аспирант MIT; Мао Яседа, аспирант Йельского университета; Синтия Бреазел, профессор медиа -искусств и наук и лидер личной робототехнической группы в MIT Media Lab; Hanspeter Pfister, профессор компьютерных наук Wang в Гарварде; и Габриэль Крейман, профессор Гарвардской медицинской школы. Исследование будет представлено на конференции Ассоциации по продвижению искусственного интеллекта.

Проблемы с обучением

Исследователи решили исследовать, почему агенты подкрепления обучения, как правило, имеют такие мрачные показатели при тестировании на среде, которые отличаются от их учебного пространства.

Подкрепление обучения-это метод проб и ошибок, в котором агент исследует учебное пространство и учится предпринять действия, которые максимизируют ее вознаграждение.

Команда разработала методику для явного добавления определенного количества шума в один элемент проблемы обучения подкреплению, называемую функцией перехода. Функция перехода определяет вероятность, что агент перейдет из одного состояния в другое, на основе выбранного оно действием.

Если агент играет PAC-Man, функция перехода может определить вероятность того, что призраки на игровой доске будут двигаться вверх, вниз, влево или вправо. При стандартном обучении подкрепления ИИ будет обучаться и протестирован с использованием той же функции перехода.

Исследователи добавили шум к функции перехода с этим обычным подходом, и, как и ожидалось, это повредило производительности Pac-Man агента.

Но когда исследователи обучили агента без шумоподасной игры Pac-Man, затем проверили его в среде, в которой они вводили шум в функцию перехода, он работал лучше, чем агент, обученный шумной игре.

«Правило эмпирента заключается в том, что вы должны попытаться захватить функцию перехода в условиях развертывания, как и во время тренировки, чтобы получить максимальную отдачу от вашего доллара. Мы действительно проверили это понимание до смерти, потому что мы не могли поверить в это сами». Мадан говорит.

Внедрение различного количества шума в функцию перехода позволяет исследователям тестировать многие среды, но не создавали реалистичные игры. Чем больше шума они вводили в PAC-Man, тем более вероятно, что призраки случайным образом телепортируются на разные квадраты.

Чтобы увидеть, произошел ли эффект тренировок в помещении в обычных играх Pac-Man, они скорректировали основные вероятности, поэтому призраки двигались нормально, но с большей вероятностью двигались вверх и вниз, а не влево и вправо. Агенты ИИ, обученные без шума, все еще работали лучше в этих реалистичных играх.

«Это было не только из -за того, как мы добавляли шум для создания специальных сред. Это, похоже, это свойство проблемы с подкреплением. И это было еще более удивительно видеть», — говорит Боно.

Исследование объяснений

Когда исследователи копались глубже в поисках объяснения, они увидели некоторые корреляции в том, как агенты ИИ исследуют учебное пространство.

Когда оба агента ИИ исследуют в основном одни и те же области, агент, обученный в небрежной среде, работает лучше, возможно, потому что агенту легче изучить правила игры без вмешательства шума.

Если их модели исследования различны, то агент, обученный шумной среде, имеет тенденцию работать лучше. Это может произойти, потому что агент должен понимать шаблоны, которые он не может изучать в среде без шума.

«Если я только научусь играть в теннис с моей справочной в небрежной среде, но тогда в шумной Полем

В будущем исследователи надеются изучить, как эффект обучения в помещении может произойти в более сложных условиях обучения подкрепления или с другими методами, такими как компьютерное зрение и обработка естественного языка. Они также хотят создать учебную среду, предназначенную для использования эффекта обучения в помещении, что может помочь агентам искусственного интеллекта лучше работать в неопределенной среде.

Больше информации:

Серена Боно и др., Эффект обучения в помещении: неожиданные выгоды от сдвигов распределения в функции перехода, arxiv (2024). Doi: 10.48550/arxiv.2401.15856

Эта история переиздана предоставлена MIT News (web.mit.edu/newsoffice/), популярный сайт, который охватывает новости о исследованиях, инновациях и преподавании MIT.

Этот документ подлежит авторским правам. Помимо каких -либо справедливых сделок с целью частного исследования или исследования, никакая часть не может быть воспроизведена без письменного разрешения. Контент предоставляется только для информационных целей.